社区日报 第176期 (2018-02-01)

-

卫星系统——酒店后端全链路日志收集工具介绍。 http://t.cn/RQxFzOF

-

搜索,分析数据库和分布式计算引擎的融合介绍。 http://t.cn/R65inbR

- 使用Apache Spark将数据写入ElasticSearch。 http://t.cn/R8flF70

-

卫星系统——酒店后端全链路日志收集工具介绍。 http://t.cn/RQxFzOF

-

搜索,分析数据库和分布式计算引擎的融合介绍。 http://t.cn/R65inbR

- 使用Apache Spark将数据写入ElasticSearch。 http://t.cn/R8flF70

社区日报 第175期 (2018-01-31)

-

macos上安装elk详细教程 http://t.cn/R8bevN3

-

自己动手用ELK分析你的支出 http://t.cn/R8bko7m

- 利用es对地理坐标进行索引和搜索 http://t.cn/R8bFHB2

-

macos上安装elk详细教程 http://t.cn/R8bevN3

-

自己动手用ELK分析你的支出 http://t.cn/R8bko7m

- 利用es对地理坐标进行索引和搜索 http://t.cn/R8bFHB2

社区日报 第174期 (2018-01-30)

http://t.cn/R8yg6ob

2.Elasticsearch和Redis的多种整合方式实战。

http://t.cn/R8LK0Oe

3.使用Apache JMeter对Elasticsearch进行性能测试。

http://t.cn/R8LKlw8

编辑:叮咚光军

归档:https://elasticsearch.cn/article/475

订阅:https://tinyletter.com/elastic-daily

http://t.cn/R8yg6ob

2.Elasticsearch和Redis的多种整合方式实战。

http://t.cn/R8LK0Oe

3.使用Apache JMeter对Elasticsearch进行性能测试。

http://t.cn/R8LKlw8

编辑:叮咚光军

归档:https://elasticsearch.cn/article/475

订阅:https://tinyletter.com/elastic-daily

收起阅读 »

社区日报 第173期 (2018-01-29)

http://t.cn/R8wsVhO

2.使用elastic site search替代即将被关闭的google site search

http://t.cn/R8wsHvl

3.elastic stack APM 线上演示教程,快来预约吧。

http://t.cn/R8APlEN

编辑:cybrdak

归档:https://elasticsearch.cn/article/474

订阅:https://tinyletter.com/elastic-daily

http://t.cn/R8wsVhO

2.使用elastic site search替代即将被关闭的google site search

http://t.cn/R8wsHvl

3.elastic stack APM 线上演示教程,快来预约吧。

http://t.cn/R8APlEN

编辑:cybrdak

归档:https://elasticsearch.cn/article/474

订阅:https://tinyletter.com/elastic-daily

收起阅读 »

社区日报 第172期 (2018-01-28)

1. Puppet使用ELK堆栈进行日志记录--Part 2。 http://t.cn/R878jnu

2. Kubernetes监测:最佳实践,方法和现有解决方案。 http://t.cn/R87HYZE

3. (自备梯子)你职业生涯中的三个问题。 http://t.cn/R87YMvk

1. Puppet使用ELK堆栈进行日志记录--Part 2。 http://t.cn/R878jnu

2. Kubernetes监测:最佳实践,方法和现有解决方案。 http://t.cn/R87HYZE

3. (自备梯子)你职业生涯中的三个问题。 http://t.cn/R87YMvk

收起阅读 »社区日报 第171期 (2018-01-27)

1、社区文章:利用es获取词频的方法 https://elasticsearch.cn/article/461

2、关于es搜索客户端的源码分析,该博客的一系列es源码分析都值得一看。 http://t.cn/RtLXZol

3、一周热点:你是怎么抢火车票的呢? http://t.cn/R8vJ9Rf

1、社区文章:利用es获取词频的方法 https://elasticsearch.cn/article/461

2、关于es搜索客户端的源码分析,该博客的一系列es源码分析都值得一看。 http://t.cn/RtLXZol

3、一周热点:你是怎么抢火车票的呢? http://t.cn/R8vJ9Rf

收起阅读 »社区日报 第170期 (2018-01-26)

http://t.cn/RQkbVhv

2、ElasticSearch Aggregations 进行统计分析实战

http://t.cn/RQD5n3F

3、注意,这6种方式能搞死Elasticsearch!

http://t.cn/RQxkfQH

编辑:铭毅天下

归档:https://elasticsearch.cn/article/471

订阅:https://tinyletter.com/elastic-daily

http://t.cn/RQkbVhv

2、ElasticSearch Aggregations 进行统计分析实战

http://t.cn/RQD5n3F

3、注意,这6种方式能搞死Elasticsearch!

http://t.cn/RQxkfQH

编辑:铭毅天下

归档:https://elasticsearch.cn/article/471

订阅:https://tinyletter.com/elastic-daily 收起阅读 »

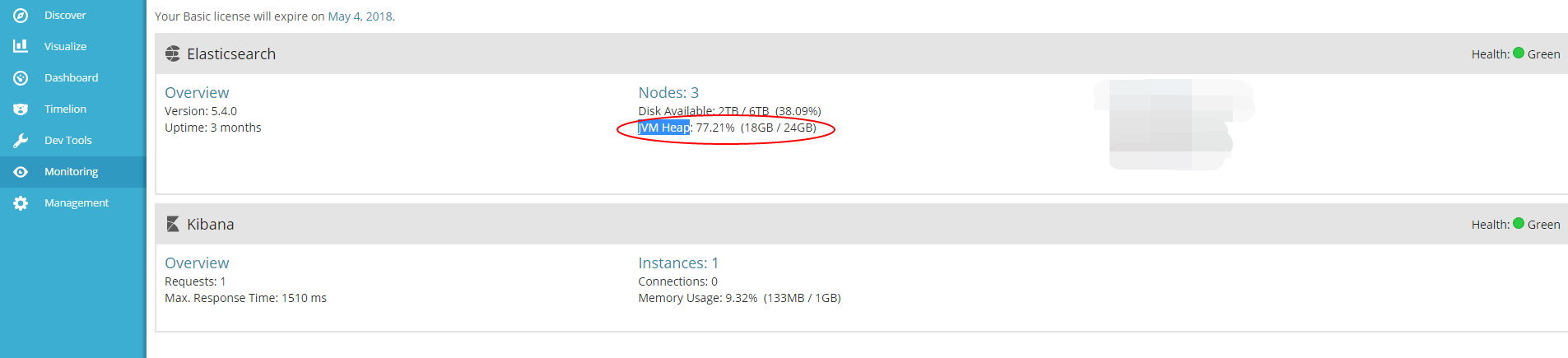

Elastic 中文社区运维监控实战 (1) - 序

序

本文为系列文章第一篇,主要介绍如何把 Elastic 中文社区的网站服务器监控起来,对有同样想了解如何使用 Elastic Stack 来做运维监控的同学,可以作为一个很好的参考和入门资料,学习门槛定义为入门级。

首先,我们要监控的网站,也就是大家现在正在访问的 Elastic 官方中文社区,网址:elasticsearch.cn,这个网站基于开源的 WeCenter 搭建,开发语言是 PHP,后端数据库是 MySQL,目前只有一台服务器,由 ConvertLab 友情无偿赞助,大写的赞!再次感谢!

服务器部署环境是 Ubuntu 16.04.2,部署了以下服务及软件:

- Nginx - Http 反向代理,不要介绍了吧

- PHP-FPM - 一个常用的 PHP FastCGI 管理

- Elasticsearch - Elasticsearch 服务,用于社区的垂直搜索服务 Elastic 情报局 服务

- GOPA - 可以说是为社区而写的,一个轻量级的爬虫,用于爬取 Elatic 周边相关相关资料,创建索引存放到 Elasticsearch 里面,提供垂直搜索服务,代码地址

- Grok Debugger - 一个 Java 的 Grok pattern 调试服务,方便大家调试 Grok 日志解析规则,访问地址:grok.elasticsearch.cn

服务器上所有的财产就这些了,一个平淡无奇的网站,基本上所有的东西都能公开访问到,这个网站的目的就是为所有 Elastic 爱好者服务的,供大家交流和沟通的专属平台,所以请各位黑客大侠不要再扫描和攻击啦,画一个简单的拓扑图如下所示:

作为一个合格的网管,除了重启服务器之外,还必须要保证网站的正常运行,所以了解网站的运行情况就变成了一个需要解决的首要问题,我们可以先把任务具体列一下:

- 网站是否正常访问,各项服务有没有挂

- 网站访问情况如何,用户访问速度如何

- 网站访客统计分析,访客相关数据分析

- 服务器的各项指标,详细指标监控分析

- 服务器的各项服务,日志集中分析处理

- 服务器是否很安全,有没有黑客来造访

- 数据是否安全备份,有没有定期测试过

实在编不下去了(话说对的还蛮齐),说人话就是监控起服务器的各项指标和收集服务的日志,然后出几个分析的 Dashboard,监控报警整起来。

我们这次需要用到的工具主要就是 Elastic Stack 啦,Elastic Stack 包括 Elasticsearch、Logstash、Beats 和 Kibana,版本都用最新的 6.x,再结合我们实际的数据和实际的需求,在后面的文章里面,我会具体介绍它们是什么以及如何使用。

今天先写到这里,明天写监控指标的收集,此系列文章暂且定为需要 100 期完成。(开个玩笑,哈哈)。

序

本文为系列文章第一篇,主要介绍如何把 Elastic 中文社区的网站服务器监控起来,对有同样想了解如何使用 Elastic Stack 来做运维监控的同学,可以作为一个很好的参考和入门资料,学习门槛定义为入门级。

首先,我们要监控的网站,也就是大家现在正在访问的 Elastic 官方中文社区,网址:elasticsearch.cn,这个网站基于开源的 WeCenter 搭建,开发语言是 PHP,后端数据库是 MySQL,目前只有一台服务器,由 ConvertLab 友情无偿赞助,大写的赞!再次感谢!

服务器部署环境是 Ubuntu 16.04.2,部署了以下服务及软件:

- Nginx - Http 反向代理,不要介绍了吧

- PHP-FPM - 一个常用的 PHP FastCGI 管理

- Elasticsearch - Elasticsearch 服务,用于社区的垂直搜索服务 Elastic 情报局 服务

- GOPA - 可以说是为社区而写的,一个轻量级的爬虫,用于爬取 Elatic 周边相关相关资料,创建索引存放到 Elasticsearch 里面,提供垂直搜索服务,代码地址

- Grok Debugger - 一个 Java 的 Grok pattern 调试服务,方便大家调试 Grok 日志解析规则,访问地址:grok.elasticsearch.cn

服务器上所有的财产就这些了,一个平淡无奇的网站,基本上所有的东西都能公开访问到,这个网站的目的就是为所有 Elastic 爱好者服务的,供大家交流和沟通的专属平台,所以请各位黑客大侠不要再扫描和攻击啦,画一个简单的拓扑图如下所示:

作为一个合格的网管,除了重启服务器之外,还必须要保证网站的正常运行,所以了解网站的运行情况就变成了一个需要解决的首要问题,我们可以先把任务具体列一下:

- 网站是否正常访问,各项服务有没有挂

- 网站访问情况如何,用户访问速度如何

- 网站访客统计分析,访客相关数据分析

- 服务器的各项指标,详细指标监控分析

- 服务器的各项服务,日志集中分析处理

- 服务器是否很安全,有没有黑客来造访

- 数据是否安全备份,有没有定期测试过

实在编不下去了(话说对的还蛮齐),说人话就是监控起服务器的各项指标和收集服务的日志,然后出几个分析的 Dashboard,监控报警整起来。

我们这次需要用到的工具主要就是 Elastic Stack 啦,Elastic Stack 包括 Elasticsearch、Logstash、Beats 和 Kibana,版本都用最新的 6.x,再结合我们实际的数据和实际的需求,在后面的文章里面,我会具体介绍它们是什么以及如何使用。

今天先写到这里,明天写监控指标的收集,此系列文章暂且定为需要 100 期完成。(开个玩笑,哈哈)。

收起阅读 »社区日报 第169期 (2018-01-25)

-

如何运行一个elasticsearch集群。 https://elasticsearch.cn/article/465

-

Elasticsearch自定义过滤插件实现复杂逻辑过滤。 http://t.cn/RQ10N3J

- Elasticsearch refresh 和flush 操作指南。 http://t.cn/RQ10Ttw

-

如何运行一个elasticsearch集群。 https://elasticsearch.cn/article/465

-

Elasticsearch自定义过滤插件实现复杂逻辑过滤。 http://t.cn/RQ10N3J

- Elasticsearch refresh 和flush 操作指南。 http://t.cn/RQ10Ttw

社区日报 第168期 (2018-01-24)

http://t.cn/RQncDxy

2. AIOps 时代下的利器:ELK

http://t.cn/RQnVo4r

3. Elasticsearch 使用 optimize 强制合并 segment 测试

http://t.cn/RQnfz71

编辑:江水

归档:https://elasticsearch.cn/article/468

订阅:https://tinyletter.com/elastic-daily

http://t.cn/RQncDxy

2. AIOps 时代下的利器:ELK

http://t.cn/RQnVo4r

3. Elasticsearch 使用 optimize 强制合并 segment 测试

http://t.cn/RQnfz71

编辑:江水

归档:https://elasticsearch.cn/article/468

订阅:https://tinyletter.com/elastic-daily

收起阅读 »

社区日报 第167期 (2018-01-23)

http://t.cn/RQTbVuA

2.eBay Elasticsearch 性能优化实战之中文篇。

http://t.cn/RQTbKQn

3.Elastic Filebeat 快速入门。

http://t.cn/RQTbjQy

编辑:叮咚光军

归档:https://elasticsearch.cn/article/466

订阅:https://tinyletter.com/elastic-daily

http://t.cn/RQTbVuA

2.eBay Elasticsearch 性能优化实战之中文篇。

http://t.cn/RQTbKQn

3.Elastic Filebeat 快速入门。

http://t.cn/RQTbjQy

编辑:叮咚光军

归档:https://elasticsearch.cn/article/466

订阅:https://tinyletter.com/elastic-daily

收起阅读 »

如何运行一个elasticsearch集群

Elasticsearch 和大多数的组件是一样,你若想要她全心全意的为你服务,你就必须满足她的需求,毕竟巧妇也难为无米之炊嘛。 Elasticsearch 的要求不高,仅仅需要合适的操作系统和JVM版本,这是最基本的要求了,如果无法满足还请放开她。

操作系统

若没有特殊说明,以后文章中ES的操作系统运行环境默认为 :

CentOS Linux release 7.2.1511 (Core)JVM

若没有特殊说明,以后文章中运行ES的Java版本默认为 :

Java version 1.8.0_102挑选合适的Elasticsearch版本

如何选择Elasticsearch 版本与如何选择找女朋友的原理是一样的。 新的版本、年轻的姑娘相信大家都喜欢.但是新的姑娘大部都分经历少、 可能家务也不会做,如果这缺点你有接受那没有问题。新的Elasticsearch 版本也是一样, 新的Elasticsearch 插件的支持可能没有那么好,新特性未被实际的生产环境验证过,如果 这些都能容忍,那么使用最新的Elasticsearch版本是最好的选择。

下载Elasticsearch

Elasticsearch下载 ( ← 右击在新标签页打开 ^-^)

解压到指定位置

1. mkdir -p $ES_HOME_PARENT //创建用于存放elasticsearch组件的父目录

2. tar -zxvf elasticsearch-6.1.1.tar.gz -C $ES_HOME_PARENT

3. cd $ES_HOME_PARENT

4. mv elasticsearch-6.1.1 es-6.1.1_benchmark611 //修改个名称

5. mkdir -p $ES_DATA_PATH/store/es-6.1.1_benchmark611 //用于存放Elasticsearch 数据

6. mkdir -p $ES_DATA_PATH/logs/es-6.1.1_benchmark611 //用于存放Elasticsearch 日志 启动前检查

Linux 系统参数检查

为什么要设置这些系统参数呢?如果不设置会对集群产生哪些影响呢?

文件句柄( File Descriptors) 如果设置过小的文件句柄,Elasticsearch 将无法与集群进行通信以及创建新的索引。

内存锁定(Memory Lock) 如果没有锁定内存,操作系统会扫描不使用的内存并把他交换到磁盘上,需要的时候 在加载到内存中。这样的操作会引起磁盘抖动,对于低延时的请求会造成比较大的伤害。 因为JVM已经有垃圾回收器,所以不需要操作系统层面的策略来管理内存,在这里我们 锁定内存来阻止系统层面插手内存管理 。

用户线程限制(User maximum number of threads) Elasticsearch 中有各种线程池,每种线程池里都会运行着不同的任务,如果操作系统支持的用户线程数据设置的较低, 集群将无法创建更多的线程运行任务,导致集群无法正常工作。

虚拟内存(Virtual Memory) 操作系统默认virtual memory都是unlimited,如果不是就重新设置,主要与内存映射总数配置同时设置,加速访问索引数据访问。

设置 文件句柄( File Descriptors) 、 内存锁定(Memory Lock)、用户线程限制(User maximum number of threads)

如下图,我已经修改了操作系统设置,如果你还没设置请用下面的命令设置

查询命令(ulimit -a)

修改命令(执行此命令需要root 权限)

vim /etc/security/limits.conf

esadmin soft nproc 40000

esadmin hard nproc 40000

esadmin soft nofile 65536

esadmin hard nofile 65536

esadmin soft memlock -1

esadmin hard memlock -1内存映射总数(Max Map Count)

内存映射总数(Max Map Count) Elasticsearch使用mmap把索引映射到虚拟内存空间,Elasticsearch 同样也需求足够的数据来创建内存映射区域。 Elasticsearch 要求最大内存映射总数至少设置 262144,过小可能无法完成索引的映射

修改命令(执行此命令需要root 权限)

sysctl -w vm.max_map_count=262144除了以上只是启动前更多需要检查的配置如下

ES启动前检查 ( ← 右击在新标签页打开 ^-^)

集群运行最少的参数配置

这是Master Node 配置参数

vim $ES_HOME/config/elasticsearch.yml# ======================== ES 参数配置 =========================

#

#

# ------------------------ 集群设定 ----------------------------

#

# 集群名称

cluster.name: benchmark612

#

# ------------------------ 节点设定 ----------------------------

#

# 节点名称

node.name: ${HOSTNAME}

#

# 节点角色

node.master: true

node.data: false

node.ingest: false

#

# ------------------------ 路径设定 ----------------------------

#

# 索引、日志存放路径

path:

data: /data/store/es-6.1.2_benchmark612

logs: /data/logs/es-6.1.2_benchmark612

#

# ------------------------ 内存设定 ----------------------------

#

#

# 锁定内存,阻止操作系统管理内存,可以有效的防止内存数据被交换到磁盘空间,

# 交换过程中磁盘会抖动,会对性能产生较大的影响。因为ES是基于JAVA开发的

# 可以能过垃圾回收器来单独管理内存,所以关闭操作系统级别的内存管理可以

# 提升性能

bootstrap.memory_lock: true

#

# ------------------------ 网络设定 ----------------------------

#

# 绑定节点上的所有网络接口,用于接收通过任意网卡传输过来的请求

network.bind_host: 0.0.0.0

#

# 绑定一个网络接口(网卡),用于集群内部节点通信(一般选择吞吐量大的网卡)

network.publish_host: _eth0:ipv4_

#

# HTTP 通信端口

http.port: 50000

#

# TCP 通信端口

transport.tcp.port: 50100

#

# --------------------------------- 集群发现 模块 ----------------------------------

#

# 集群初始化连接列表,节点启动后,首先通过连接初始化列表里的地址去发现集群。

discovery.zen.ping.unicast.hosts: ["20.120.203.74:50100","20.120.203.76:50100","20.120.203.81:50100","20.120.203.84:50100","20.120.203.85:50100"]

#

# 为了防止集群脑裂,目前的策略是当且仅当节点有超过半数的master候选者存活时(目前是2台,可以完成选举),集群才会进行master选举

discovery.zen.minimum_master_nodes: 2

#

# ---------------------------------- 其它 -----------------------------------

#

# 关闭操作系统内核验证(我的操作系统没有升级,如果不关闭验证则无法启动)

bootstrap.system_call_filter: false

#

# ------------------------ HTTP ----------------------------

#

# 是否支持跨域访问资源

http.cors.enabled: true

#

#

#允许访问资源的类型

http.cors.allow-origin: "*"

#

#

# 允许HTTP请求的方法类型

http.cors.allow-methods: OPTIONS,HEAD,GET,POST,PUT,DELETE

#

# 允许HTTP请求头返回类型

http.cors.allow-headers: X-Requested-With,Content-Type,Content-Length,Authorization,Content-Encoding,Accept-Encoding

#

# 支持HTTP访问API 总开关

http.enabled: true

#

#这是Data Node 配置参数

vim $ES_HOME/config/elasticsearch.yml# ======================== ES 参数配置 =========================

#

#

# ------------------------ 集群设定 ----------------------------

#

# 集群名称

cluster.name: benchmark612

#

# ------------------------ 节点设定 ----------------------------

#

# 节点名称

node.name: ${HOSTNAME}

#

# 节点角色

node.master: false

node.data: true

node.ingest: false

#

# ------------------------ 路径设定 ----------------------------

#

# 索引、日志存放路径

path:

data: /data/store/es-6.1.2_benchmark612

logs: /data/logs/es-6.1.2_benchmark612

#

# ------------------------ 内存设定 ----------------------------

#

#

# 锁定内存,阻止操作系统管理内存,可以有效的防止内存数据被交换到磁盘空间,

# 交换过程中磁盘会抖动,会对性能产生较大的影响。因为ES是基于JAVA开发的

# 可以能过垃圾回收器来单独管理内存,所以关闭操作系统级别的内存管理可以

# 提升性能

bootstrap.memory_lock: true

#

# ------------------------ 网络设定 ----------------------------

#

# 绑定节点上的所有网络接口,用于接收通过任意网卡传输过来的请求

network.bind_host: 0.0.0.0

#

# 绑定一个网络接口(网卡),用于集群内部节点通信(一般选择吞吐量大的网卡)

network.publish_host: _eth0:ipv4_

#

# HTTP 通信端口

http.port: 50000

#

# TCP 通信端口

transport.tcp.port: 50100

#

# --------------------------------- 集群发现 模块 ----------------------------------

#

# 集群初始化连接列表,节点启动后,首先通过连接初始化列表里的地址去发现集群。

discovery.zen.ping.unicast.hosts: ["20.120.203.74:50100","20.120.203.76:50100","20.120.203.81:50100","20.120.203.84:50100","20.120.203.85:50100"]

#

# 为了防止集群脑裂,目前的策略是当且仅当节点有超过半数的master候选者存活时(目前是2台,可以完成选举),集群才会进行master选举

discovery.zen.minimum_master_nodes: 2

#

# ---------------------------------- 其它 -----------------------------------

#

# 关闭操作系统内核验证(我的操作系统没有升级,如果不关闭验证则无法启动)

bootstrap.system_call_filter: false

#相信细心的同学发现了Master和Data 配置的区别

1) 区别一, Master 和 Data 节点角色配置的不同

# 节点角色 Master

node.master: true

node.data: false

node.ingest: false

# 节点角色 Data

node.master: false

node.data: true

node.ingest: false2) 区别二, Master 设置了HTTP 相关参数,如果不设置,将无法通过HEAD能插件来访问集群

#

# ------------------------ HTTP ----------------------------

#

# 是否支持跨域访问资源

http.cors.enabled: true

#

#

#允许访问资源的类型

http.cors.allow-origin: "*"

#

#

# 允许HTTP请求的方法类型

http.cors.allow-methods: OPTIONS,HEAD,GET,POST,PUT,DELETE

#

# 允许HTTP请求头返回类型

http.cors.allow-headers: X-Requested-With,Content-Type,Content-Length,Authorization,Content-Encoding,Accept-Encoding

#

# 支持HTTP访问API 总开关

http.enabled: true

#不设置HTTP参数

设置HTTP参数后

到这里,一个Elasticsearch 就正常的运行起来了。

转自: http://elasticsearch.club/elasticsearch/es-tutorial/how-to-run-an-elasticsearch-cluster/

Elasticsearch 和大多数的组件是一样,你若想要她全心全意的为你服务,你就必须满足她的需求,毕竟巧妇也难为无米之炊嘛。 Elasticsearch 的要求不高,仅仅需要合适的操作系统和JVM版本,这是最基本的要求了,如果无法满足还请放开她。

操作系统

若没有特殊说明,以后文章中ES的操作系统运行环境默认为 :

CentOS Linux release 7.2.1511 (Core)JVM

若没有特殊说明,以后文章中运行ES的Java版本默认为 :

Java version 1.8.0_102挑选合适的Elasticsearch版本

如何选择Elasticsearch 版本与如何选择找女朋友的原理是一样的。 新的版本、年轻的姑娘相信大家都喜欢.但是新的姑娘大部都分经历少、 可能家务也不会做,如果这缺点你有接受那没有问题。新的Elasticsearch 版本也是一样, 新的Elasticsearch 插件的支持可能没有那么好,新特性未被实际的生产环境验证过,如果 这些都能容忍,那么使用最新的Elasticsearch版本是最好的选择。

下载Elasticsearch

Elasticsearch下载 ( ← 右击在新标签页打开 ^-^)

解压到指定位置

1. mkdir -p $ES_HOME_PARENT //创建用于存放elasticsearch组件的父目录

2. tar -zxvf elasticsearch-6.1.1.tar.gz -C $ES_HOME_PARENT

3. cd $ES_HOME_PARENT

4. mv elasticsearch-6.1.1 es-6.1.1_benchmark611 //修改个名称

5. mkdir -p $ES_DATA_PATH/store/es-6.1.1_benchmark611 //用于存放Elasticsearch 数据

6. mkdir -p $ES_DATA_PATH/logs/es-6.1.1_benchmark611 //用于存放Elasticsearch 日志 启动前检查

Linux 系统参数检查

为什么要设置这些系统参数呢?如果不设置会对集群产生哪些影响呢?

文件句柄( File Descriptors) 如果设置过小的文件句柄,Elasticsearch 将无法与集群进行通信以及创建新的索引。

内存锁定(Memory Lock) 如果没有锁定内存,操作系统会扫描不使用的内存并把他交换到磁盘上,需要的时候 在加载到内存中。这样的操作会引起磁盘抖动,对于低延时的请求会造成比较大的伤害。 因为JVM已经有垃圾回收器,所以不需要操作系统层面的策略来管理内存,在这里我们 锁定内存来阻止系统层面插手内存管理 。

用户线程限制(User maximum number of threads) Elasticsearch 中有各种线程池,每种线程池里都会运行着不同的任务,如果操作系统支持的用户线程数据设置的较低, 集群将无法创建更多的线程运行任务,导致集群无法正常工作。

虚拟内存(Virtual Memory) 操作系统默认virtual memory都是unlimited,如果不是就重新设置,主要与内存映射总数配置同时设置,加速访问索引数据访问。

设置 文件句柄( File Descriptors) 、 内存锁定(Memory Lock)、用户线程限制(User maximum number of threads)

如下图,我已经修改了操作系统设置,如果你还没设置请用下面的命令设置

查询命令(ulimit -a)

修改命令(执行此命令需要root 权限)

vim /etc/security/limits.conf

esadmin soft nproc 40000

esadmin hard nproc 40000

esadmin soft nofile 65536

esadmin hard nofile 65536

esadmin soft memlock -1

esadmin hard memlock -1内存映射总数(Max Map Count)

内存映射总数(Max Map Count) Elasticsearch使用mmap把索引映射到虚拟内存空间,Elasticsearch 同样也需求足够的数据来创建内存映射区域。 Elasticsearch 要求最大内存映射总数至少设置 262144,过小可能无法完成索引的映射

修改命令(执行此命令需要root 权限)

sysctl -w vm.max_map_count=262144除了以上只是启动前更多需要检查的配置如下

ES启动前检查 ( ← 右击在新标签页打开 ^-^)

集群运行最少的参数配置

这是Master Node 配置参数

vim $ES_HOME/config/elasticsearch.yml# ======================== ES 参数配置 =========================

#

#

# ------------------------ 集群设定 ----------------------------

#

# 集群名称

cluster.name: benchmark612

#

# ------------------------ 节点设定 ----------------------------

#

# 节点名称

node.name: ${HOSTNAME}

#

# 节点角色

node.master: true

node.data: false

node.ingest: false

#

# ------------------------ 路径设定 ----------------------------

#

# 索引、日志存放路径

path:

data: /data/store/es-6.1.2_benchmark612

logs: /data/logs/es-6.1.2_benchmark612

#

# ------------------------ 内存设定 ----------------------------

#

#

# 锁定内存,阻止操作系统管理内存,可以有效的防止内存数据被交换到磁盘空间,

# 交换过程中磁盘会抖动,会对性能产生较大的影响。因为ES是基于JAVA开发的

# 可以能过垃圾回收器来单独管理内存,所以关闭操作系统级别的内存管理可以

# 提升性能

bootstrap.memory_lock: true

#

# ------------------------ 网络设定 ----------------------------

#

# 绑定节点上的所有网络接口,用于接收通过任意网卡传输过来的请求

network.bind_host: 0.0.0.0

#

# 绑定一个网络接口(网卡),用于集群内部节点通信(一般选择吞吐量大的网卡)

network.publish_host: _eth0:ipv4_

#

# HTTP 通信端口

http.port: 50000

#

# TCP 通信端口

transport.tcp.port: 50100

#

# --------------------------------- 集群发现 模块 ----------------------------------

#

# 集群初始化连接列表,节点启动后,首先通过连接初始化列表里的地址去发现集群。

discovery.zen.ping.unicast.hosts: ["20.120.203.74:50100","20.120.203.76:50100","20.120.203.81:50100","20.120.203.84:50100","20.120.203.85:50100"]

#

# 为了防止集群脑裂,目前的策略是当且仅当节点有超过半数的master候选者存活时(目前是2台,可以完成选举),集群才会进行master选举

discovery.zen.minimum_master_nodes: 2

#

# ---------------------------------- 其它 -----------------------------------

#

# 关闭操作系统内核验证(我的操作系统没有升级,如果不关闭验证则无法启动)

bootstrap.system_call_filter: false

#

# ------------------------ HTTP ----------------------------

#

# 是否支持跨域访问资源

http.cors.enabled: true

#

#

#允许访问资源的类型

http.cors.allow-origin: "*"

#

#

# 允许HTTP请求的方法类型

http.cors.allow-methods: OPTIONS,HEAD,GET,POST,PUT,DELETE

#

# 允许HTTP请求头返回类型

http.cors.allow-headers: X-Requested-With,Content-Type,Content-Length,Authorization,Content-Encoding,Accept-Encoding

#

# 支持HTTP访问API 总开关

http.enabled: true

#

#这是Data Node 配置参数

vim $ES_HOME/config/elasticsearch.yml# ======================== ES 参数配置 =========================

#

#

# ------------------------ 集群设定 ----------------------------

#

# 集群名称

cluster.name: benchmark612

#

# ------------------------ 节点设定 ----------------------------

#

# 节点名称

node.name: ${HOSTNAME}

#

# 节点角色

node.master: false

node.data: true

node.ingest: false

#

# ------------------------ 路径设定 ----------------------------

#

# 索引、日志存放路径

path:

data: /data/store/es-6.1.2_benchmark612

logs: /data/logs/es-6.1.2_benchmark612

#

# ------------------------ 内存设定 ----------------------------

#

#

# 锁定内存,阻止操作系统管理内存,可以有效的防止内存数据被交换到磁盘空间,

# 交换过程中磁盘会抖动,会对性能产生较大的影响。因为ES是基于JAVA开发的

# 可以能过垃圾回收器来单独管理内存,所以关闭操作系统级别的内存管理可以

# 提升性能

bootstrap.memory_lock: true

#

# ------------------------ 网络设定 ----------------------------

#

# 绑定节点上的所有网络接口,用于接收通过任意网卡传输过来的请求

network.bind_host: 0.0.0.0

#

# 绑定一个网络接口(网卡),用于集群内部节点通信(一般选择吞吐量大的网卡)

network.publish_host: _eth0:ipv4_

#

# HTTP 通信端口

http.port: 50000

#

# TCP 通信端口

transport.tcp.port: 50100

#

# --------------------------------- 集群发现 模块 ----------------------------------

#

# 集群初始化连接列表,节点启动后,首先通过连接初始化列表里的地址去发现集群。

discovery.zen.ping.unicast.hosts: ["20.120.203.74:50100","20.120.203.76:50100","20.120.203.81:50100","20.120.203.84:50100","20.120.203.85:50100"]

#

# 为了防止集群脑裂,目前的策略是当且仅当节点有超过半数的master候选者存活时(目前是2台,可以完成选举),集群才会进行master选举

discovery.zen.minimum_master_nodes: 2

#

# ---------------------------------- 其它 -----------------------------------

#

# 关闭操作系统内核验证(我的操作系统没有升级,如果不关闭验证则无法启动)

bootstrap.system_call_filter: false

#相信细心的同学发现了Master和Data 配置的区别

1) 区别一, Master 和 Data 节点角色配置的不同

# 节点角色 Master

node.master: true

node.data: false

node.ingest: false

# 节点角色 Data

node.master: false

node.data: true

node.ingest: false2) 区别二, Master 设置了HTTP 相关参数,如果不设置,将无法通过HEAD能插件来访问集群

#

# ------------------------ HTTP ----------------------------

#

# 是否支持跨域访问资源

http.cors.enabled: true

#

#

#允许访问资源的类型

http.cors.allow-origin: "*"

#

#

# 允许HTTP请求的方法类型

http.cors.allow-methods: OPTIONS,HEAD,GET,POST,PUT,DELETE

#

# 允许HTTP请求头返回类型

http.cors.allow-headers: X-Requested-With,Content-Type,Content-Length,Authorization,Content-Encoding,Accept-Encoding

#

# 支持HTTP访问API 总开关

http.enabled: true

#不设置HTTP参数

设置HTTP参数后

到这里,一个Elasticsearch 就正常的运行起来了。

转自: http://elasticsearch.club/elasticsearch/es-tutorial/how-to-run-an-elasticsearch-cluster/

收起阅读 »社区日报 第166期 (2018-01-22)

http://t.cn/RQjPCYj

2.为machine learning jobs自定义聚合查询。

http://t.cn/RQjPQdf

3.elasticsearch因为cpu漏洞所受到的性能冲击。

http://t.cn/RQjh2oD

编辑:cyberdak

归档:https://elasticsearch.cn/article/464

订阅:https://tinyletter.com/elastic-daily

http://t.cn/RQjPCYj

2.为machine learning jobs自定义聚合查询。

http://t.cn/RQjPQdf

3.elasticsearch因为cpu漏洞所受到的性能冲击。

http://t.cn/RQjh2oD

编辑:cyberdak

归档:https://elasticsearch.cn/article/464

订阅:https://tinyletter.com/elastic-daily

收起阅读 »

社区日报 第165期 (2018-01-21)

-

Elasticsearch的最佳分片管理策略。 http://t.cn/RQp1VMF

-

Elasticsearch映射:关于如何创建,编辑,删除的例子。 http://t.cn/RQObLTG

- (自备梯子)想象一个更好的互联网环境。 http://t.cn/RQO589h

-

Elasticsearch的最佳分片管理策略。 http://t.cn/RQp1VMF

-

Elasticsearch映射:关于如何创建,编辑,删除的例子。 http://t.cn/RQObLTG

- (自备梯子)想象一个更好的互联网环境。 http://t.cn/RQO589h