社区日报 第1147期 (2020-12-23)

https://www.elastic.co/blog/ho ... ction

2. Elasticsearch Machine Learning AIOps 实践

https://flashgene.com/archives/69226.html

3. 一款elasticsearch向量词快速评分插件

https://github.com/lior-k/fast ... oring

编辑:wt

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://www.elastic.co/blog/ho ... ction

2. Elasticsearch Machine Learning AIOps 实践

https://flashgene.com/archives/69226.html

3. 一款elasticsearch向量词快速评分插件

https://github.com/lior-k/fast ... oring

编辑:wt

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup 收起阅读 »

社区日报 第1146期 (2020-12-22)

https://www.elastic.co/cn/blog ... cloud

2. 训练、评估、监测、推理:Elastic 中的端对端 Machine Learning

https://www.elastic.co/cn/blog ... astic

3.Rancher开源Harvester:基于K8S的超融合基础架构软件

https://mp.weixin.qq.com/s/MWcYD0PnvtVQTNrF2NBe9g

编辑:寂寞的烟

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://www.elastic.co/cn/blog ... cloud

2. 训练、评估、监测、推理:Elastic 中的端对端 Machine Learning

https://www.elastic.co/cn/blog ... astic

3.Rancher开源Harvester:基于K8S的超融合基础架构软件

https://mp.weixin.qq.com/s/MWcYD0PnvtVQTNrF2NBe9g

编辑:寂寞的烟

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup 收起阅读 »

社区日报 第1145期 (2020-12-21)

https://zhuanlan.zhihu.com/p/266314466

2.使用python和django搭建的elasticsearch搜索脚手架

https://github.com/sunnyjiecha ... jango

3.一个基于springboot的elasticsearch java客户端调用封装工具

https://gitee.com/zxporz/ESClientRHL

编辑:cyberdak

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://zhuanlan.zhihu.com/p/266314466

2.使用python和django搭建的elasticsearch搜索脚手架

https://github.com/sunnyjiecha ... jango

3.一个基于springboot的elasticsearch java客户端调用封装工具

https://gitee.com/zxporz/ESClientRHL

编辑:cyberdak

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

收起阅读 »

社区日报 第1144期 (2020-12-20)

https://github.com/moshe/elast ... ME.md

2.(自备梯子)集成Elasticsearch和KsqlDB实现强大的数据分析。

https://www.confluent.io/blog/ ... tics/

3.计算机辅助学习对学生长期发展的影响。

https://papers.ssrn.com/sol3/p ... 09169

编辑:至尊宝

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://github.com/moshe/elast ... ME.md

2.(自备梯子)集成Elasticsearch和KsqlDB实现强大的数据分析。

https://www.confluent.io/blog/ ... tics/

3.计算机辅助学习对学生长期发展的影响。

https://papers.ssrn.com/sol3/p ... 09169

编辑:至尊宝

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

收起阅读 »

社区日报 第1143期 (2020-12-19)

1.如何使用terraform自动化部署Elastic Cloud

https://xeraa.net/blog/2020_how-to-automate-elastic-cloud-with-terraform/

2.使用ILM构建hot-warm-cold架构(自备梯子)

https://medium.com/bestcloudforme/data-aging-with-elasticsearch-hot-warm-cold-infrastructure-6e5eef4c9e65

3.ES底层字符串数组和字符串的索引区别

https://stackoverflow.com/questions/65271653/internals-of-array-of-strings-vs-concatenated-string-in-elasticsearch

1.如何使用terraform自动化部署Elastic Cloud

https://xeraa.net/blog/2020_how-to-automate-elastic-cloud-with-terraform/

2.使用ILM构建hot-warm-cold架构(自备梯子)

https://medium.com/bestcloudforme/data-aging-with-elasticsearch-hot-warm-cold-infrastructure-6e5eef4c9e65

3.ES底层字符串数组和字符串的索引区别

https://stackoverflow.com/questions/65271653/internals-of-array-of-strings-vs-concatenated-string-in-elasticsearch

收起阅读 »INFINI Gateway 的使用方法和使用心得分享

安装部署

安装部署非常简单,INFINI Gateway使用go语言进行编写,linux系统基本不需要安装任何其他依赖,直接从github上下载解压即可使用,由于需要反复重启调试,同时网关需要具备进程保护功能,我使用了supervisord进行纳管,supervisord安装部署我在此省略,有兴趣的同学直接网上搜索即可。Supervisord配置文件如下:

[program:gateway]

command = /app/logger/gateway/gateway-linux64

username = appuser

autostart=false

autorestart=true

startsecs=3

priority=1007

stdout_logfile=/app/logger/gateway/log/infini_gateway.log配置文件

这块可能是我比较重点想分享的地方,因为可能由于目前项目刚刚发布,medcl大神一直忙于功能开发无暇顾及使用说明的介绍(我妄自揣测,请medcl大神不要见怪^_^),所以配置文件目前在安装介质中只有一个模板,外加模板中的一些参数注释的介绍,可能对于新手进行配置还是有比较大的难度(比如我),所以在自己摸索外加medcl大神的指导下我初步成功配置并实现了预期效果,现在分享给大家。

Path模块:

path.data: data

path.logs: logentry模块:

entry:

- name: es_gateway #your gateway endpoint

enable: true

router: default #configure your gateway's routing flow

network:

binding: 0.0.0.0:8000

reuse_port: true #you can start multi gateway instance, they share same port, to full utilize system's resources

tls:

enabled: false #if your es is using https, the gateway entrypoint should enable https tooflow模块:

- name: cache_first

filter: #comment out any filter sections, like you don't need cache or rate-limiter

- name: get_cache_1

type: get_cache

- name: rate_limit_1

type: rate_limit

parameters:

message: "Hey, You just reached our request limit!"

rules: #configure match rules against request's PATH, eg: /_cluster/health, match the first rule and return

- pattern: "/(?P<index_name>test.*?)/_search" #use regex pattern to match index, will match any /$index/_search, and limit each index with max_qps ~=100

max_qps: 1000

group: index_name

- name: elasticsearch_1

type: elasticsearch

parameters:

elasticsearch: default #elasticsearch configure reference name

max_connection: 1000 #max tcp connection to upstream, default for all nodes

max_response_size: -1 #default for all nodes

balancer: weight

- host: 192.168.3.201:9200 #the format is host:port

weight: 100

- host: 192.168.3.202:9200

weight: 100

discovery:

enabled: false

- name: set_cache_1

type: set_cache

parameters:

cache_ttl: 1000s

# max_cache_items: 100000

- name: request_logging # this flow is used for request logging, refer to `router`'s `tracing_flow`

filter:

- name: request_path_filter_1

type: request_path_filter

parameters:

must: #must match all rules to continue

prefix:

- /test

- name: request_logging_1

type: request_logging

parameters:

queue_name: request_loggingrequest_logging的流其实就是网关trace监控自己用的,由于后面进行了filter强匹配,所以采样sample参数我就没有配置。注意这里其实我们在cache_first中并没有配置filter规则,所以这里任何过网关的查询都会进入缓存,包括查询tracing_flow自己创建的索引。在request_logging尽量按照自己的需求去配置一些filter规则来减少监控写入的索引,如果不配置,写入的量级会非常多,后续用仪表盘进行监控时响应会非常慢。目前gateway网关支持的filter类型非常全面,包括request_path_filter根据索引名或者路径去筛选,request_header_filter根据请求头部信息去筛选索引,request_method_filter根据请求的方法类型去筛选,注意如果使用request_header_filter根据请求头部信息去筛选索引,需要在应用在请求的头里加入特殊标识,比如如果要通过request_header_filter方式把所有kibana的请求全部过滤掉,就需要在kibana配置文件中增加头部参数并自定义值:

elasticsearch.customHeaders: { "app": "kibana" }- name: request_header_filter1 # filter out the requests that we are not interested, reduce tracing pressure

type: request_header_filter

parameters:

exclude: # any rule match will marked request as filtered

- app: kibana # in order to filter kibana's access log, config `elasticsearch.customHeaders: { "app": "kibana" }` to your kibana's config `/config/kibana.yml`这里还有一个点,就是在filter类型中还有个特殊的类型,叫做request_logging,这个是专门针对tracing_flow设计的,其中有一个重要参数是queue_name,他会在gateway网关所在的服务器磁盘上创建一个队列用来加速写入,减少tracing_flow对网关所造成的性能影响,所以这个队列在这里创建之后会在后面的pipelines中去指定写入磁盘队列。

router模块:

router:

- name: default

tracing_flow: request_logging #a flow will execute after request finish

default_flow: cache_first

rules: #rules can't be conflicted with each other, will be improved in the future

- id: 1 # this rule means match every requests, and sent to `cache_first` flow

method:

- "*"

pattern:

- /

# priority: 1

flow:

- cache_first # after match, which processing flow will go throughelasticsearch模块:

elasticsearch:

- name: default

enabled: true

endpoint: http://localhost:9200 # if your elasticsearch is using https, your gateway should be listen on as https as well

version: 7.9.1 #optional, used to select es adaptor, can be done automatically after connect to es

index_prefix: gateway_

basic_auth: #used to discovery full cluster nodes, or check elasticsearch's health and versions

username: elastic

password: passmodules模块:

modules:

- name: elastic

enabled: true

elasticsearch: default

init_template: true

- name: pipeline

enabled: true

runners:

- name: primary

enabled: true

max_go_routine: 1

threshold_in_ms: 0

timeout_in_ms: 5000

pipeline_id: request_logging_indexrequest_logging要往es中写数做准备,es模块使用默认模板,pipeline设置一些写入需要的参数,我全部没改使用默认值。

pipelines模块:

pipelines:

- name: request_logging_index

start:

joint: json_indexing

enabled: true

parameters:

index_name: "gateway_requests"

elasticsearch: "default"

input_queue: "request_logging"

timeout: "60s"

worker_size: 1

bulk_size_in_mb: 10 #in MB

process:queue模块:

queue:

min_msg_size: 1

max_msg_size: 50000000

max_bytes_per_file: 53687091200

sync_every_records: 100000 # sync by records count

sync_timeout_in_ms: 10000 # sync by time in million seconds

read_chan_buffer: 0statsd模块:

enabled: false

host: 127.0.0.1

port: 8125

namespace: gateway.使用对比结果:

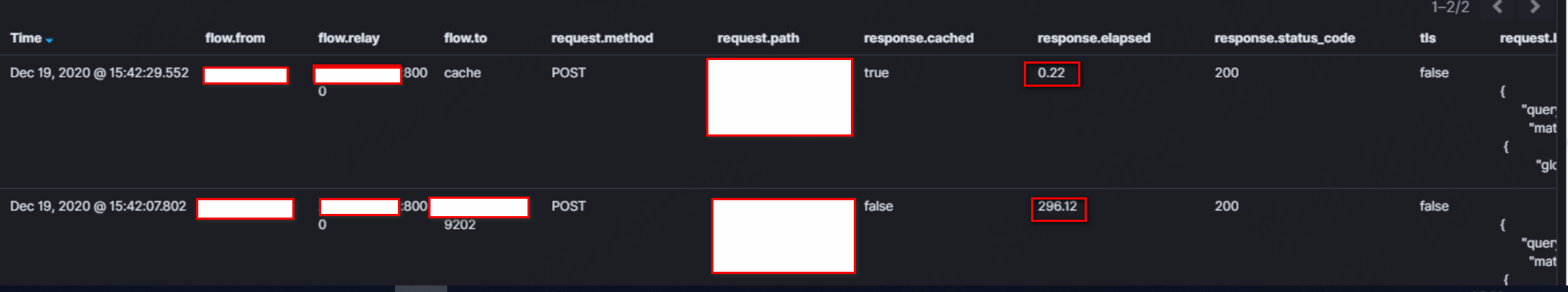

通过gateway中自带仪表盘可以对使用情况和效果进行方便的监控,通过比对可以发现一条复用的查询语句走网关缓存和不走网关缓存性能差距在100倍以上,使用网关进行查询优势巨大特别明显。

未来展望:

首先感谢Medcl大神把这么好的东西发布出来,使用网关对于业务查询有百倍上的性能提升确实十分诱人。而且目前虽然INFINI Gateway刚刚发布出来,但是已经陆陆续续迭代了好几个版本,可以明显看到一些bug修复、功能增强和性能优化提高,目前最新的版本又增加了请求灰度切换、流量迁移和流量复制功能,可以实现双写和多写,这个功能对于我来说后续很可能会应用到,因为实际上是一种变相的多集群数据同步方式的实现。所以可以看出INFINI Gateway网关不仅仅定位于查询缓存网关,而是集查询和写入功能为一体的综合性大网关,期待Medcl大神后续的精彩表演,让我们拭目以待。

安装部署

安装部署非常简单,INFINI Gateway使用go语言进行编写,linux系统基本不需要安装任何其他依赖,直接从github上下载解压即可使用,由于需要反复重启调试,同时网关需要具备进程保护功能,我使用了supervisord进行纳管,supervisord安装部署我在此省略,有兴趣的同学直接网上搜索即可。Supervisord配置文件如下:

[program:gateway]

command = /app/logger/gateway/gateway-linux64

username = appuser

autostart=false

autorestart=true

startsecs=3

priority=1007

stdout_logfile=/app/logger/gateway/log/infini_gateway.log配置文件

这块可能是我比较重点想分享的地方,因为可能由于目前项目刚刚发布,medcl大神一直忙于功能开发无暇顾及使用说明的介绍(我妄自揣测,请medcl大神不要见怪^_^),所以配置文件目前在安装介质中只有一个模板,外加模板中的一些参数注释的介绍,可能对于新手进行配置还是有比较大的难度(比如我),所以在自己摸索外加medcl大神的指导下我初步成功配置并实现了预期效果,现在分享给大家。

Path模块:

path.data: data

path.logs: logentry模块:

entry:

- name: es_gateway #your gateway endpoint

enable: true

router: default #configure your gateway's routing flow

network:

binding: 0.0.0.0:8000

reuse_port: true #you can start multi gateway instance, they share same port, to full utilize system's resources

tls:

enabled: false #if your es is using https, the gateway entrypoint should enable https tooflow模块:

- name: cache_first

filter: #comment out any filter sections, like you don't need cache or rate-limiter

- name: get_cache_1

type: get_cache

- name: rate_limit_1

type: rate_limit

parameters:

message: "Hey, You just reached our request limit!"

rules: #configure match rules against request's PATH, eg: /_cluster/health, match the first rule and return

- pattern: "/(?P<index_name>test.*?)/_search" #use regex pattern to match index, will match any /$index/_search, and limit each index with max_qps ~=100

max_qps: 1000

group: index_name

- name: elasticsearch_1

type: elasticsearch

parameters:

elasticsearch: default #elasticsearch configure reference name

max_connection: 1000 #max tcp connection to upstream, default for all nodes

max_response_size: -1 #default for all nodes

balancer: weight

- host: 192.168.3.201:9200 #the format is host:port

weight: 100

- host: 192.168.3.202:9200

weight: 100

discovery:

enabled: false

- name: set_cache_1

type: set_cache

parameters:

cache_ttl: 1000s

# max_cache_items: 100000

- name: request_logging # this flow is used for request logging, refer to `router`'s `tracing_flow`

filter:

- name: request_path_filter_1

type: request_path_filter

parameters:

must: #must match all rules to continue

prefix:

- /test

- name: request_logging_1

type: request_logging

parameters:

queue_name: request_loggingrequest_logging的流其实就是网关trace监控自己用的,由于后面进行了filter强匹配,所以采样sample参数我就没有配置。注意这里其实我们在cache_first中并没有配置filter规则,所以这里任何过网关的查询都会进入缓存,包括查询tracing_flow自己创建的索引。在request_logging尽量按照自己的需求去配置一些filter规则来减少监控写入的索引,如果不配置,写入的量级会非常多,后续用仪表盘进行监控时响应会非常慢。目前gateway网关支持的filter类型非常全面,包括request_path_filter根据索引名或者路径去筛选,request_header_filter根据请求头部信息去筛选索引,request_method_filter根据请求的方法类型去筛选,注意如果使用request_header_filter根据请求头部信息去筛选索引,需要在应用在请求的头里加入特殊标识,比如如果要通过request_header_filter方式把所有kibana的请求全部过滤掉,就需要在kibana配置文件中增加头部参数并自定义值:

elasticsearch.customHeaders: { "app": "kibana" }- name: request_header_filter1 # filter out the requests that we are not interested, reduce tracing pressure

type: request_header_filter

parameters:

exclude: # any rule match will marked request as filtered

- app: kibana # in order to filter kibana's access log, config `elasticsearch.customHeaders: { "app": "kibana" }` to your kibana's config `/config/kibana.yml`这里还有一个点,就是在filter类型中还有个特殊的类型,叫做request_logging,这个是专门针对tracing_flow设计的,其中有一个重要参数是queue_name,他会在gateway网关所在的服务器磁盘上创建一个队列用来加速写入,减少tracing_flow对网关所造成的性能影响,所以这个队列在这里创建之后会在后面的pipelines中去指定写入磁盘队列。

router模块:

router:

- name: default

tracing_flow: request_logging #a flow will execute after request finish

default_flow: cache_first

rules: #rules can't be conflicted with each other, will be improved in the future

- id: 1 # this rule means match every requests, and sent to `cache_first` flow

method:

- "*"

pattern:

- /

# priority: 1

flow:

- cache_first # after match, which processing flow will go throughelasticsearch模块:

elasticsearch:

- name: default

enabled: true

endpoint: http://localhost:9200 # if your elasticsearch is using https, your gateway should be listen on as https as well

version: 7.9.1 #optional, used to select es adaptor, can be done automatically after connect to es

index_prefix: gateway_

basic_auth: #used to discovery full cluster nodes, or check elasticsearch's health and versions

username: elastic

password: passmodules模块:

modules:

- name: elastic

enabled: true

elasticsearch: default

init_template: true

- name: pipeline

enabled: true

runners:

- name: primary

enabled: true

max_go_routine: 1

threshold_in_ms: 0

timeout_in_ms: 5000

pipeline_id: request_logging_indexrequest_logging要往es中写数做准备,es模块使用默认模板,pipeline设置一些写入需要的参数,我全部没改使用默认值。

pipelines模块:

pipelines:

- name: request_logging_index

start:

joint: json_indexing

enabled: true

parameters:

index_name: "gateway_requests"

elasticsearch: "default"

input_queue: "request_logging"

timeout: "60s"

worker_size: 1

bulk_size_in_mb: 10 #in MB

process:queue模块:

queue:

min_msg_size: 1

max_msg_size: 50000000

max_bytes_per_file: 53687091200

sync_every_records: 100000 # sync by records count

sync_timeout_in_ms: 10000 # sync by time in million seconds

read_chan_buffer: 0statsd模块:

enabled: false

host: 127.0.0.1

port: 8125

namespace: gateway.使用对比结果:

通过gateway中自带仪表盘可以对使用情况和效果进行方便的监控,通过比对可以发现一条复用的查询语句走网关缓存和不走网关缓存性能差距在100倍以上,使用网关进行查询优势巨大特别明显。

未来展望:

首先感谢Medcl大神把这么好的东西发布出来,使用网关对于业务查询有百倍上的性能提升确实十分诱人。而且目前虽然INFINI Gateway刚刚发布出来,但是已经陆陆续续迭代了好几个版本,可以明显看到一些bug修复、功能增强和性能优化提高,目前最新的版本又增加了请求灰度切换、流量迁移和流量复制功能,可以实现双写和多写,这个功能对于我来说后续很可能会应用到,因为实际上是一种变相的多集群数据同步方式的实现。所以可以看出INFINI Gateway网关不仅仅定位于查询缓存网关,而是集查询和写入功能为一体的综合性大网关,期待Medcl大神后续的精彩表演,让我们拭目以待。 收起阅读 »

社区日报 第1142期 (2020-12-18)

https://mp.weixin.qq.com/s/7VzmoK4ZsVfnJflEs_B9tA

2、为博客添加Elasticsearch引擎

https://blog.lsonline.fr/2020/ ... blog/

3、Elasticsearch最佳实践

https://blockgeni.com/best-pra ... arch/

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://mp.weixin.qq.com/s/7VzmoK4ZsVfnJflEs_B9tA

2、为博客添加Elasticsearch引擎

https://blog.lsonline.fr/2020/ ... blog/

3、Elasticsearch最佳实践

https://blockgeni.com/best-pra ... arch/

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup 收起阅读 »

社区日报 第1141期 (2020-12-17)

https://www.jianshu.com/p/2bfd2d633f0c

2.Elasticsearch-CCR源码剖析

https://www.jianshu.com/p/b9169d1b6791

3.ElasticSearch读写底层原理及性能调优

https://my.oschina.net/wangzhi ... 09389

编辑:金桥

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://www.jianshu.com/p/2bfd2d633f0c

2.Elasticsearch-CCR源码剖析

https://www.jianshu.com/p/b9169d1b6791

3.ElasticSearch读写底层原理及性能调优

https://my.oschina.net/wangzhi ... 09389

编辑:金桥

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup 收起阅读 »

配置 Elasticsearch 服务器 logs

<cluster name>.log

<cluster name>_server.json

假如我在 config/eleasticsearch.yml 文件中把 cluster.name 定义为如下的值:cluster.name: liuxg-cluster那么我们就可以在 logs/ 目录下看到如下的文件:

$ pwd

/Users/liuxg/elastic0/elasticsearch-7.10.0/logs

liuxg:logs liuxg$ ls liuxg-cluster*

liuxg-cluster.log

liuxg-cluster_audit.json

liuxg-cluster_deprecation.json

liuxg-cluster_deprecation.log

liuxg-cluster_index_indexing_slowlog.json

liuxg-cluster_index_indexing_slowlog.log

liuxg-cluster_index_search_slowlog.json

liuxg-cluster_index_search_slowlog.log

liuxg-cluster_server.json

从上面,我们可以看到所有的文件以 liuxg-cluster 开始的文件名。这些日志记录了 elasticsearch 运行的状态。依据不同的日志等级,它会记录不同的事件。

详细阅读,请参阅 https://elasticstack.blog.csdn ... 90556

<cluster name>.log

<cluster name>_server.json

假如我在 config/eleasticsearch.yml 文件中把 cluster.name 定义为如下的值:cluster.name: liuxg-cluster那么我们就可以在 logs/ 目录下看到如下的文件:

$ pwd

/Users/liuxg/elastic0/elasticsearch-7.10.0/logs

liuxg:logs liuxg$ ls liuxg-cluster*

liuxg-cluster.log

liuxg-cluster_audit.json

liuxg-cluster_deprecation.json

liuxg-cluster_deprecation.log

liuxg-cluster_index_indexing_slowlog.json

liuxg-cluster_index_indexing_slowlog.log

liuxg-cluster_index_search_slowlog.json

liuxg-cluster_index_search_slowlog.log

liuxg-cluster_server.json

从上面,我们可以看到所有的文件以 liuxg-cluster 开始的文件名。这些日志记录了 elasticsearch 运行的状态。依据不同的日志等级,它会记录不同的事件。

详细阅读,请参阅 https://elasticstack.blog.csdn ... 90556 收起阅读 »

Elastic:Data tiers 介绍及索引生命周期管理 - 7.10 之后版本

Data tier 也就是数据层。是一个在 7.10 版本的一个新概念。数据层是具有相同数据角色的节点的集合,这些节点通常共享相同的硬件配置文件:

- Content tier (内容层)节点处理诸如产品目录之类的内容的索引和查询负载。

- Hot tier (热层) 节点处理诸如日志或指标之类的时间序列数据的索引负载,并保存你最近,最常访问的数据。

- Warm tier (温层)节点保存的时间序列数据访问频率较低,并且很少需要更新。

- Cold tier (冷层)节点保存时间序列数据,这些数据偶尔会被访问,并且通常不会更新。

详细阅读,请参阅 “Elastic:Data tiers 介绍及索引生命周期管理 - 7.10 之后版本” https://elasticstack.blog.csdn ... 50474

Data tier 也就是数据层。是一个在 7.10 版本的一个新概念。数据层是具有相同数据角色的节点的集合,这些节点通常共享相同的硬件配置文件:

- Content tier (内容层)节点处理诸如产品目录之类的内容的索引和查询负载。

- Hot tier (热层) 节点处理诸如日志或指标之类的时间序列数据的索引负载,并保存你最近,最常访问的数据。

- Warm tier (温层)节点保存的时间序列数据访问频率较低,并且很少需要更新。

- Cold tier (冷层)节点保存时间序列数据,这些数据偶尔会被访问,并且通常不会更新。

详细阅读,请参阅 “Elastic:Data tiers 介绍及索引生命周期管理 - 7.10 之后版本” https://elasticstack.blog.csdn ... 50474 收起阅读 »

社区日报 第1138期 (2020-12-14)

https://segmentfault.com/q/1010000014343913

2、ElasticSearch 索引配置隐私字段

https://blog.csdn.net/Vancl_Wa ... 16012

3、elasticsearch存储聊天消息的最佳实践

https://stackoverflow.com/ques ... earch

编辑:cyberdak

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://segmentfault.com/q/1010000014343913

2、ElasticSearch 索引配置隐私字段

https://blog.csdn.net/Vancl_Wa ... 16012

3、elasticsearch存储聊天消息的最佳实践

https://stackoverflow.com/ques ... earch

编辑:cyberdak

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup 收起阅读 »

在 Kibana 中的四种表格制作方式

- 在 Discover 界面中制作

- 使用 table 可视化进行制作

- 使用 TSVB 来制作

- 使用 Lens 进行制作

在这几种方式中,几种制作最后的结果是不一样的。我们在实际的使用中,需要根据自己的需求来分别进行选择。

详细阅读,请参阅 https://elasticstack.blog.csdn ... 88189

- 在 Discover 界面中制作

- 使用 table 可视化进行制作

- 使用 TSVB 来制作

- 使用 Lens 进行制作

在这几种方式中,几种制作最后的结果是不一样的。我们在实际的使用中,需要根据自己的需求来分别进行选择。

详细阅读,请参阅 https://elasticstack.blog.csdn ... 88189

收起阅读 »

社区日报 第1137期 (2020-12-13)

https://www.twingate.com/blog/ ... gate/

2.如何在Kafka和Elasticsearch探索数据。

https://lenses.io/blog/2020/04 ... -sql/

3.(自备梯子)赛博朋克2077通过Proton兼容层在Linux上运行。

https://twitter.com/Plagman2/s ... 34784

编辑:至尊宝

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://www.twingate.com/blog/ ... gate/

2.如何在Kafka和Elasticsearch探索数据。

https://lenses.io/blog/2020/04 ... -sql/

3.(自备梯子)赛博朋克2077通过Proton兼容层在Linux上运行。

https://twitter.com/Plagman2/s ... 34784

编辑:至尊宝

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

收起阅读 »

社区日报 第1136期 (2020-12-12)

1.复杂嵌套语句的搜索及优化

https://stackoverflow.com/questions/65237747/elasticsearch-query-by-generic-properties-keywords-and-numeric-values/65243079#65243079

2.Lucene vs Solr vs ElasticSearch

https://anytxt.net/how-to-choose-a-full-text-search-engine/

3.基于ES的问答系统

1.复杂嵌套语句的搜索及优化

https://stackoverflow.com/questions/65237747/elasticsearch-query-by-generic-properties-keywords-and-numeric-values/65243079#65243079

2.Lucene vs Solr vs ElasticSearch

https://anytxt.net/how-to-choose-a-full-text-search-engine/

3.基于ES的问答系统

https://github.com/jetnew/DrFAQ

收起阅读 »社区日报 第1135期 (2020-12-11)

https://www.javatpoint.com/ela ... cture

2、如何设计可扩展的 Elasticsearch 数据存储的架构

https://www.elastic.co/cn/blog ... scale

3、15分钟介绍ELK(PDF)

http://karunsubramanian.com/wp ... 1.pdf

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

https://www.javatpoint.com/ela ... cture

2、如何设计可扩展的 Elasticsearch 数据存储的架构

https://www.elastic.co/cn/blog ... scale

3、15分钟介绍ELK(PDF)

http://karunsubramanian.com/wp ... 1.pdf

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

收起阅读 »