新人求助:

我现在遇到一个有关elasticsearch备份恢复速度慢的问题,场景如下:

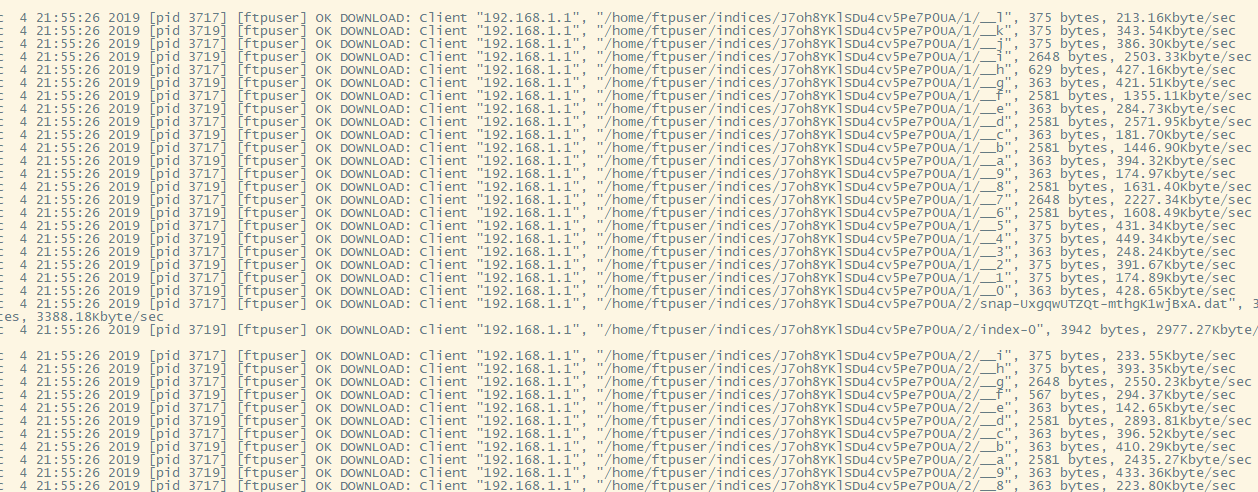

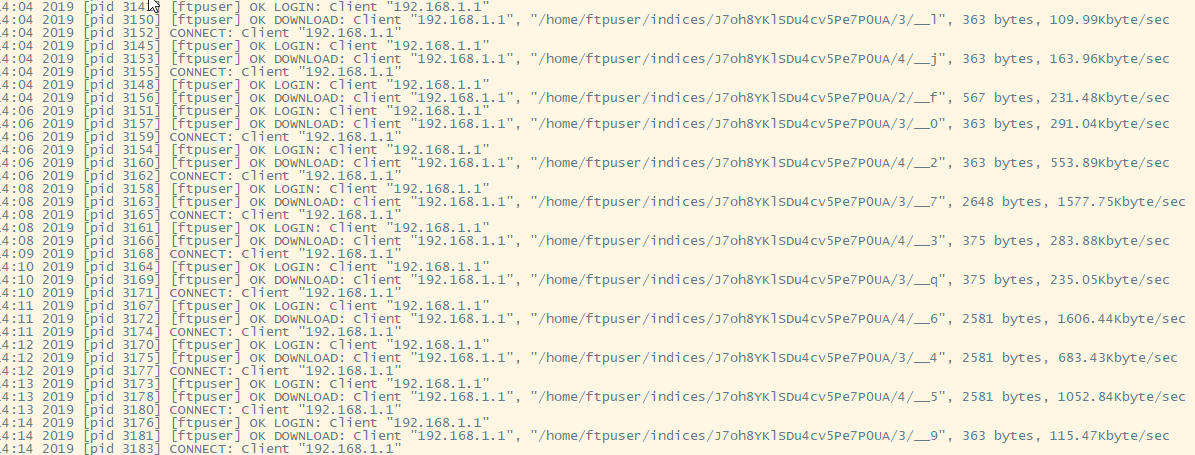

目前有三台linux虚拟机A、B、C,环境均为CentOS7。 我在A服务器上安装了vsftpd FTP服务器用于存储elasticsearch快照,在B服务器和C服务器上各装了elasticsearch5.6.10。 在使用时,我使用curlftpfs将A服务器挂载在B服务器上,这样就可以将B服务器上elasticsearch创建的快照直接存储到A的FTP服务器中保存。现在我想试试官方文档提供的Read-Only URL Repository:

官方文档:https://www.elastic.co/guide/e ... .html

我的做法:

1、在C服务器上elasticsearch 创建只读快照仓库,协议ftp, url直接指向A的FTP服务器

我现在遇到一个有关elasticsearch备份恢复速度慢的问题,场景如下:

目前有三台linux虚拟机A、B、C,环境均为CentOS7。 我在A服务器上安装了vsftpd FTP服务器用于存储elasticsearch快照,在B服务器和C服务器上各装了elasticsearch5.6.10。 在使用时,我使用curlftpfs将A服务器挂载在B服务器上,这样就可以将B服务器上elasticsearch创建的快照直接存储到A的FTP服务器中保存。现在我想试试官方文档提供的Read-Only URL Repository:

官方文档:https://www.elastic.co/guide/e ... .html

我的做法:

1、在C服务器上elasticsearch 创建只读快照仓库,协议ftp, url直接指向A的FTP服务器

{

"backup1": {

"type": "url",

"settings": {

"compress" : "true",

"url": "ftp://ftpuser:ftppwd@192.168.1.102:21",

"max_restore_bytes_per_sec": "50mb",

"max_snapshot_bytes_per_sec": "50mb"

}

}

}repositories.url.allowed_urls : ["ftp://ftpuser:ftppwd@addressA:21"]curl -XPOST 'http://127.0.0.1:9200/_snapshot/backup1/es_2.0.0_demo-0327/_restore?wait_for_completion=true'

2 个回复

匿名用户

赞同来自:

几个TB的数据,还玩什么增量和全量备份。

这不是灾难吗?

所有软件默认提供的备份和恢复方案,没有一个是成熟的,没有一个是生成级别的,全都是demo级别的。

Charele - Cisco4321

赞同来自:

FTP的方式我感受过,很慢。以前我在用一个软件的时候(Java写的),它要从网上download一个demo数据下来,代码里面是用FTP方式下载的,数据有100多M,运行了一个小时还在等待,

后来实在不耐烦了,找到了里面的数据源网址,手工下载下来的,半分钟就完成了。

可以试下用HDFS的方式