版本:6.1.1

Nodes: 4(master+data)

Indices: 3352

Memory: 51GB / 123GB

Total Shards: 33379

Documents: 1,456,904,986

Data: 492GB

国庆前进行了滚动重启,本以为数据会缓慢恢复,但是来了一看发现卡住了

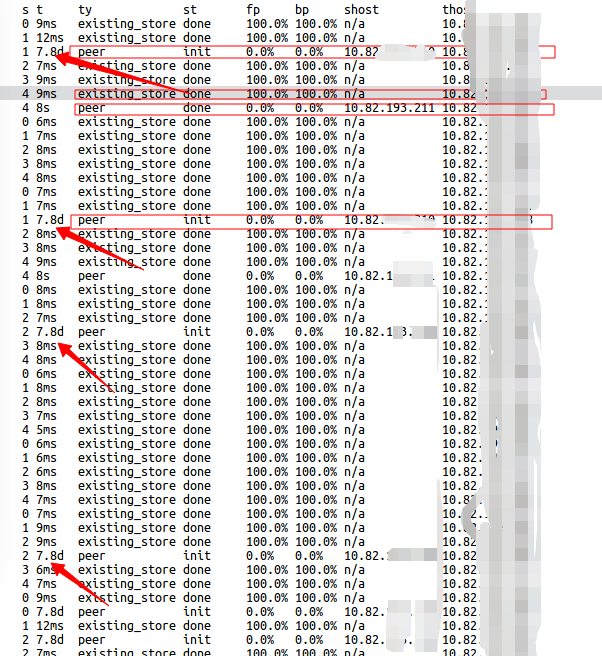

查看一下任务

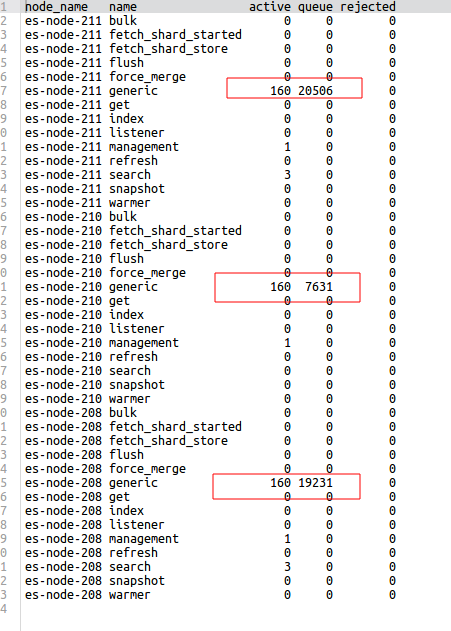

查看线程

整个集群状态为yellow,只要是从其他节点恢复数据的任务全部卡住,这是我的集群设置

Nodes: 4(master+data)

Indices: 3352

Memory: 51GB / 123GB

Total Shards: 33379

Documents: 1,456,904,986

Data: 492GB

国庆前进行了滚动重启,本以为数据会缓慢恢复,但是来了一看发现卡住了

查看一下任务

GET _cat/recovery?v&h=i,s,t,ty,st,fp,bp,shost,thost

查看线程

GET _cat/thread_pool?v整个集群状态为yellow,只要是从其他节点恢复数据的任务全部卡住,这是我的集群设置

{

"persistent": {

"cluster": {

"routing": {

"allocation": {

"allow_rebalance": "always",

"cluster_concurrent_rebalance": "500",

"enable": "all"

}

}

},

"discovery": {

"zen": {

"minimum_master_nodes": "2"

}

},

"indices": {

"recovery": {

"max_bytes_per_sec": "600mb"

}

}

},

"transient": {

"cluster": {

"routing": {

"allocation": {

"node_concurrent_incoming_recoveries": "500",

"node_initial_primaries_recoveries": "4",

"enable": "all",

"node_concurrent_outgoing_recoveries": "500"

}

}

}

}

}

3 个回复

juin - 大数据开发

赞同来自:

zqc0512 - andy zhou

赞同来自:

"node_concurrent_outgoing_recoveries": "500"

"cluster_concurrent_rebalance": "500",

节点多么?这几个值过大了。

yayg2008

赞同来自:

比如网络限制600mb,每秒600M,起码得万兆网卡才行;

比如cluster_concurrent_rebalance,500并发,也比较离谱,除非你的机器非常强大。