上周五集群出现响应特别慢的现象,用curl ip:9200 要等几分钟才返回结果,但是cup 内存都没表现出异常.

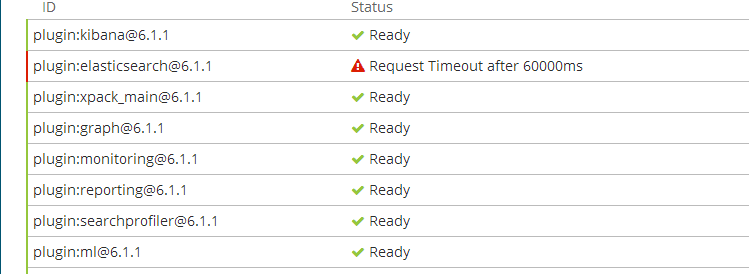

kibana上显示plugin:elasticsearch@6.1.1 request timeout after 60000ms,截图如下

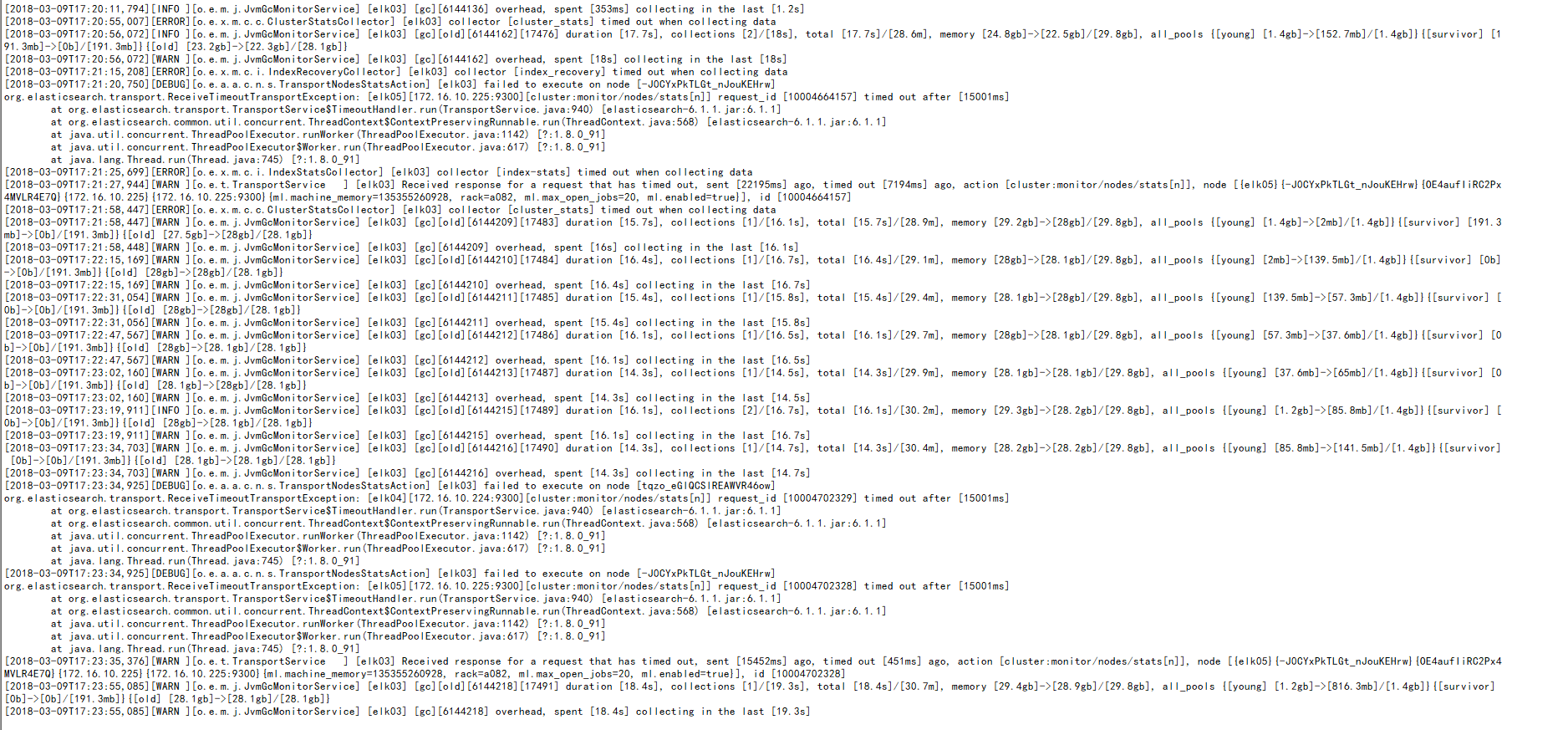

还有当时时间段的es的日志.截图如下

我当时直接把所有节点都重启了一下.然后服务可用了,集群状态成yellow等待恢复.

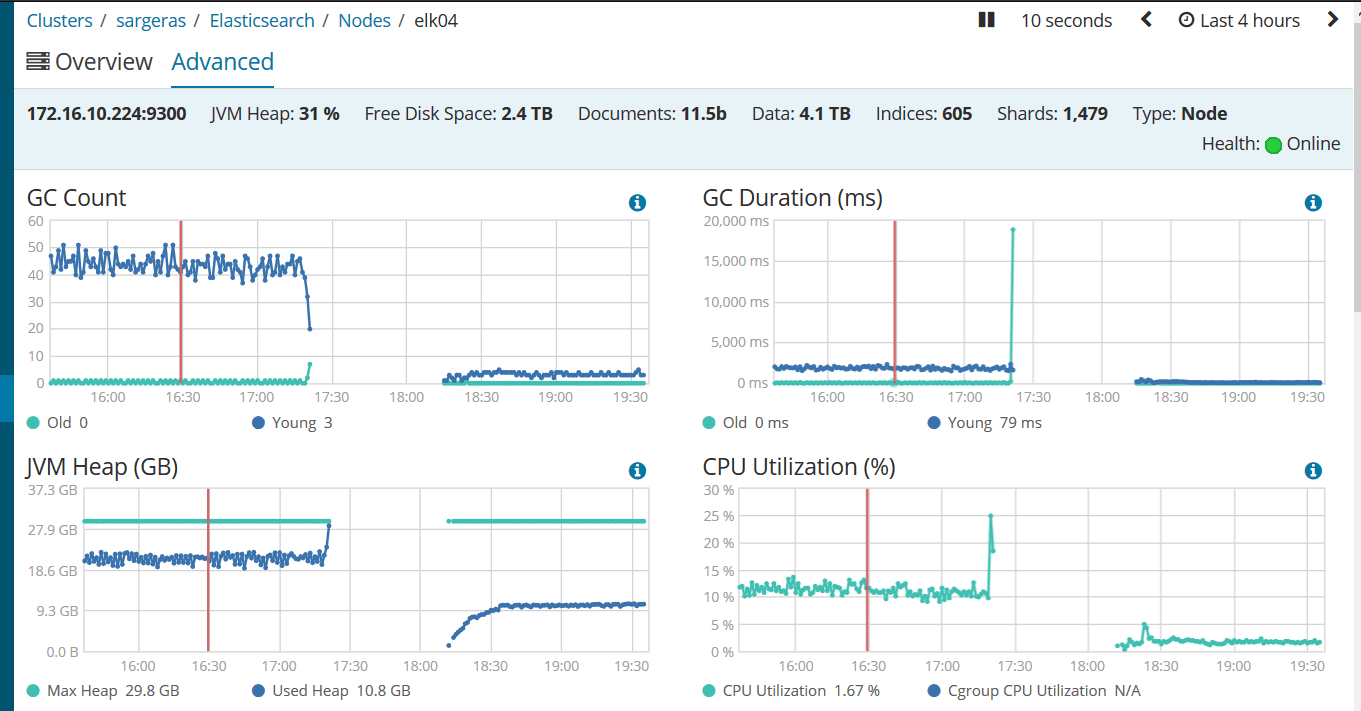

重启后kibana监控截图如下:

请大神们帮忙分析一下可能哪里出现的问题.

----------------------------------------------------------------------------------------

周六 集群状态恢复成green,但是日志里不断地刷这种日志:

kibana上显示plugin:elasticsearch@6.1.1 request timeout after 60000ms,截图如下

还有当时时间段的es的日志.截图如下

我当时直接把所有节点都重启了一下.然后服务可用了,集群状态成yellow等待恢复.

重启后kibana监控截图如下:

请大神们帮忙分析一下可能哪里出现的问题.

----------------------------------------------------------------------------------------

周六 集群状态恢复成green,但是日志里不断地刷这种日志:

[2018-03-12T09:39:13,008][WARN ][o.e.x.w.e.ExecutionService] [elk03] failed to execute watch [-5k9J17YS-akE0a216b_Ew_elasticsearch_version_mismatch]

[2018-03-12T09:39:13,012][WARN ][o.e.x.w.e.ExecutionService] [elk03] failed to execute watch [-5k9J17YS-akE0a216b_Ew_kibana_version_mismatch]

[2018-03-12T09:56:12,847][WARN ][o.e.x.w.e.ExecutionService] [elk03] failed to execute watch [-5k9J17YS-akE0a216b_Ew_kibana_version_mismatch]

2 个回复

rockybean - Elastic Certified Engineer, ElasticStack Fans,公众号:ElasticTalk

赞同来自: luohuanfeng

code4j - coder github: https://github.com/rpgmakervx

赞同来自: luohuanfeng