Elastic Certified Analyst 徽章到手!

rockybean 发表了文章 • 1 个评论 • 3464 次浏览 • 2020-06-17 11:04

关于认证考试的内容,我做了一次直播分享,感兴趣的可以来这里查看!

https://www.yuque.com/elastictalk/blog/et26

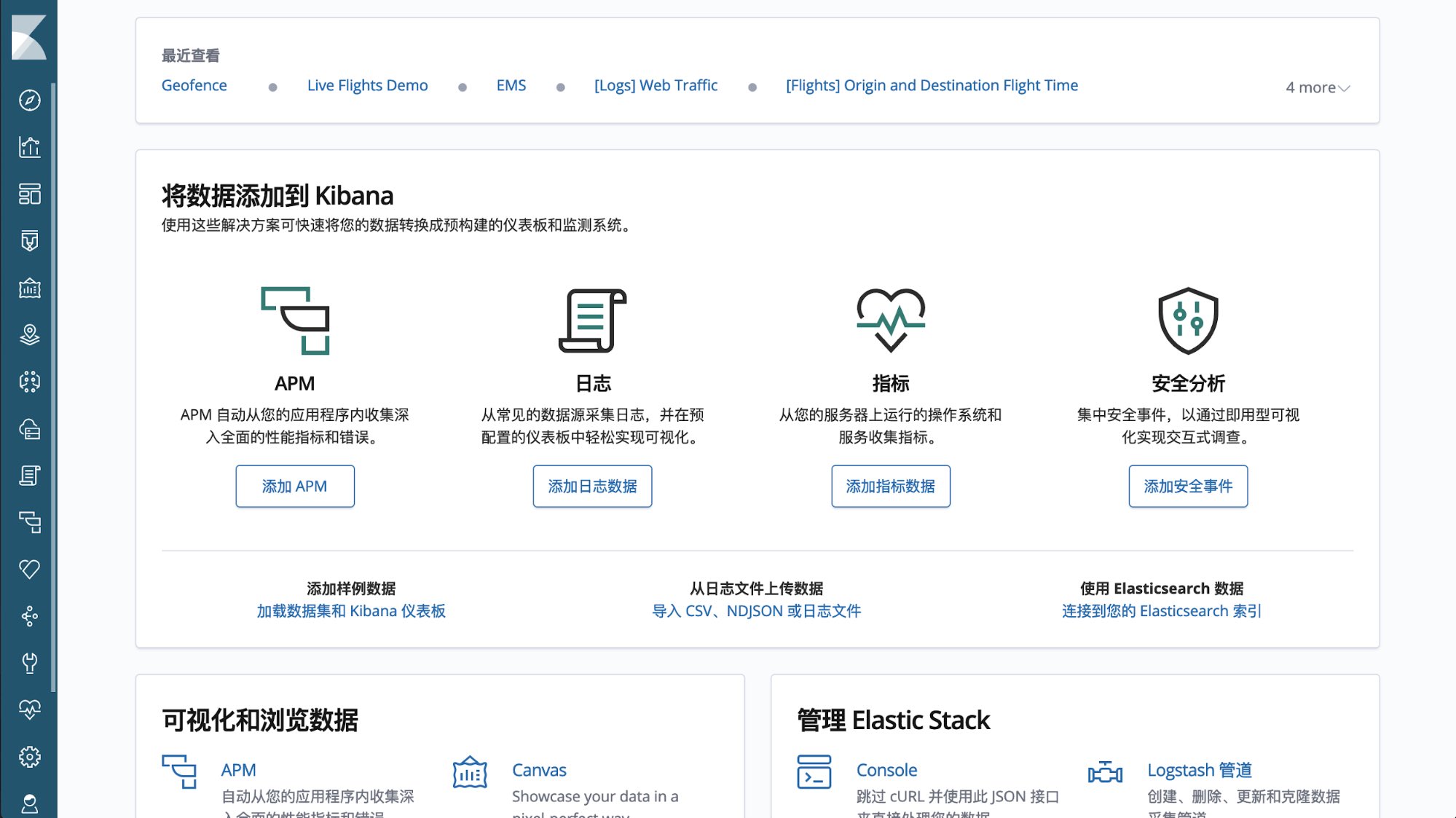

Elastic 最近推出了新的认证考试,Elastic Certified Analyst,主要是考察大家对 Kibana 的掌握程度。

https://www.elastic.co/trainin ... -exam

我上周参加了下,顺利拿到徽章,题目还是比较有意思的,周末找时间直播和大家聊一聊!

Elastic 官方培训开放注册中!

medcl 发表了文章 • 3 个评论 • 6740 次浏览 • 2020-04-10 18:42

Elastic 官方线上公开培训课现已开放注册。

本次课程为官方收费课程,为针对中国及亚洲华语学员单独开设的课程,本次课程为在线虚拟课程,共计 两门课程,包含一次 Elastic 认证工程师考试机会。

课程大纲!

本次课程的内容为 Elasticsearch 核心课程,分为两个部分:

- Elasticsearch Engineer I - Virtual

- Elasticsearch Engineer II - Virtual

各个课程的大纲分别为:

Elasticsearch Engineer I - Virtual

- Elasticsearch 基础理论

- Elasticsearch 查询

- Elasticsearch 聚合

- Elasticsearch 文本分析与映射

- Elasticsearch 节点与分片

- Elasticsearch 监控与诊断

更多详情请访问:https://training.elastic.co/in ... rtual

Elasticsearch Engineer II - Virtual

- Elasticsearch 数据建模

- Elasticsearch 数据加工

- Elasticsearch 从开发到生产环境

- Elasticsearch 集群部署

- Elasticsearch 节点和索引管理

- Elasticsearch 高级使用技巧

更多详情请访问:https://training.elastic.co/in ... rtual

授课方式!

本次课程为在线课程,每门课程有两位专门的授课老师,授课采用在线课堂的方式,提供远程实验动手环境,授课老师会实时指导,辅导上机操作。

课程教材为英文,全程由中文普通话讲授。

授课时间!

授课时间:

- Elasticsearch 课程 1:4月27日 – 4月30日

- Elasticsearch 课程 2:5月18日 – 5月21日

每门课程分别为 4 天(讲师授课指导半天、自己练习半天),两门课程共计 8 天,内容各不相同,没有交叉。

课程准备!

上课环境前提准备

- 稳定的互联网连接,10Mb 以上带宽

- 任意安装有 Mac, Linux 或 Windows 的电脑一台

- 最新稳定版本的 Chrome 或者 Firefox 浏览器(其它浏览器不支持)

- 课程开始前,关闭任何广告屏蔽插件,并重启浏览器

- 课程开始前,确保关闭任何的 VPN 服务

报名时间!

从即日起开设接收学员报名,报名截止时间为:2020 年 4 月 22 日,以实际付款时间为主。

报名费用!

两门课程 + 一次认证考试累计合计费用:$1920 美金

官网报名!

报名方法一:通过在线方式自主选择进行注册报名、缴费,需要选择 Location:China Standard Time。

https://training.elastic.co/lo ... China

人工报名!

报名方法二:您可以联系下面的 Elastic 官方合作伙伴,由他们来帮你购买课程和处理发票事宜。

扫下发二维码立即联系客服

常见问题!

Q:能否支持选择单项课程,如 ENG I 或者 ENG II?

A:不支持,本次课程为捆绑优惠套餐

Q:能否支持信用卡付款?

A:支持,信用卡需支持双币卡

Q:能否支持微信支付宝付款?

A:支持,需要联系人工报名

Q:能否提供发票用于报销?

A:支持,需要联系人工报名,有额外税点

本次课程名额有限,距离开课的时间也不多了,有兴趣的同学们赶快报名吧。

免责声明

有关此次在线培训活动的最终解释权给 Elastic 所有。

Kafka 消费端突然不进行消费

zhtanjy 回复了问题 • 5 人关注 • 4 个回复 • 6997 次浏览 • 2020-04-17 14:20

ElasticTalk #16 ElasticSearch 监控那些事儿

rockybean 发表了文章 • 0 个评论 • 3632 次浏览 • 2019-06-09 21:15

1.为什么要监控

2.应该监控哪些指标

3.如何监控

如果你没来的及参加直播,来看下回放吧!

本次直播由于耳机问题,导致声音断断续续,大家忍耐着看下片子吧 :-(

视频回放地址

ElasticTalk 是一个社区的 Webinar 活动,也欢迎感兴趣的伙伴加入,我们的目标如下:

1.研讨 Elastic Stack 的新功能、原理等,使更多的人以更直接的方式掌握其功能

2.锻炼参与者的选题、语言表达及沟通能力

目前是计划每周六下午 2:00 举行一场,形式主要以在线直播为主。

如果你对这个项目感兴趣,欢迎联系我!

招聘时间

我司在大力招聘 Elastic 技术专家,欢迎感兴趣的同学来投简历,地址如下:

http://www.elastictech.cn/jobs

想在 Elasticsearch 领域精进的同学,不妨来看看机会,作为 Elastic 官方战略级合作伙伴,我们的培训都是和 Elastic 官方同步的,机不可失!

而我们服务的客户遍布金融、证券、零售、制造业,充满挑战,感兴趣的你快来投递简历吧!

【直播回放】ElasticTalk #15 Filebeat Modules 简介

rockybean 发表了文章 • 0 个评论 • 3245 次浏览 • 2019-06-09 21:12

如果你没来的及参加直播,来看下回放吧!

视频回放地址

ElasticTalk 是一个社区的 Webinar 活动,也欢迎感兴趣的伙伴加入,我们的目标如下:

1.研讨 Elastic Stack 的新功能、原理等,使更多的人以更直接的方式掌握其功能

2.锻炼参与者的选题、语言表达及沟通能力

目前是计划每周六下午 2:00 举行一场,形式主要以在线直播为主。

如果你对这个项目感兴趣,欢迎联系我!

招聘时间

我司在大力招聘 Elastic 技术专家,欢迎感兴趣的同学来投简历,地址如下:

http://www.elastictech.cn/jobs

想在 Elasticsearch 领域精进的同学,不妨来看看机会,作为 Elastic 官方战略级合作伙伴,我们的培训都是和 Elastic 官方同步的,机不可失!

而我们服务的客户遍布金融、证券、零售、制造业,充满挑战,感兴趣的你快来投递简历吧!

【直播回放】ElasticTalk #14 Elastic 安全功能体验

rockybean 发表了文章 • 0 个评论 • 3085 次浏览 • 2019-05-25 19:02

如果你没来的及参加直播,来看下回放吧!

视频回放地址

ElasticTalk 是一个社区的 Webinar 活动,也欢迎感兴趣的伙伴加入,我们的目标如下:

1.研讨 Elastic Stack 的新功能、原理等,使更多的人以更直接的方式掌握其功能

2.锻炼参与者的选题、语言表达及沟通能力

目前是计划每周六下午 2:00 举行一场,形式主要以在线直播为主。

如果你对这个项目感兴趣,欢迎联系我!

招聘时间

我司在大力招聘 Elastic 技术专家,欢迎感兴趣的同学来投简历,地址如下:

http://www.elastictech.cn/jobs

想在 Elasticsearch 领域精进的同学,不妨来看看机会,作为 Elastic 官方战略级合作伙伴,我们的培训都是和 Elastic 官方同步的,机不可失!

而我们服务的客户遍布金融、证券、零售、制造业,充满挑战,感兴趣的你快来投递简历吧!

【直播报名】ElasticTalk #14 Elastic 安全功能体验

rockybean 发表了文章 • 0 个评论 • 3254 次浏览 • 2019-05-25 13:41

5月25日(周六) 14:00~15:00

直播内容:

在最新的 6.8 和 7.1 版本中,Elastic 向社区用户免费开放了安全功能,如果你还没有体验过,快来一起看看吧!

直播方式:

直播链接会在开始前发送到讨论群中。

点击下方网站链接,选择对应 Webinar 注册即可

Webinar 注册链接

腾讯云 Elasticsearch 服务:中国及全球范围内的全新合作关系

medcl 发表了文章 • 0 个评论 • 4570 次浏览 • 2019-05-22 17:44

来自中国昆明的问候!

我们很高兴地宣布 Elastic 与腾讯云达成全球合作关系,通过这一合作,我们能够将 Elasticsearch Service 的出色功能引入到腾讯云 Elasticsearch 服务中。此次合作能够让中国和全球的用户和客户受益,因为他们借助此次合作能够使用到我们完整的产品和解决方案,包括免费和付费的专有 Elastic Stack 功能。 腾讯是全球领先的互联网技术公司之一,拥有多款热门产品,例如微信、QQ 以及腾讯游戏。这次能够与腾讯携手合作,我们倍感荣幸。这种新关系正是 Elastic 热切追寻的合作伙伴关系。我们希望给与用户不同优质的选择来使用我们的产品和解决方案,从而能够在业务上获得成功。随着中国的 Elasticsearch 社区越来越壮大,本次合作能够确保所有用户和客户都能全面利用 到 Elastic Stack 的研发成果,包括我们免费和付费的专有功能,以及我们在腾讯云上的解决方案。 我们还十分高兴能够与腾讯云的工程师团队协作并提供本地化服务支持。此类服务支持是仅为腾讯云这样的合作伙伴而特别提供。

腾讯云 Elasticsearch 服务将于 6 月初推出,届时用户将能够体验到他们一直期待的的完整 Elastic 功能。这其中就包括非常关键且免费的安全功能,例如 TLS 加密通信、基于角色的访问控制、文件和原生身份验证,以及 Kibana 的多租户功能,而且用户还能够启用付费的安全功能,例如单点登录、活动目录/LDAP 身份验证,以及字段级和文档级安全功能。此外,腾讯云还将上线 Elastic 新推出的 Kibana 中文本地化版本,以及其他专有功能,例如 Alerting、Monitoring、Canvas、Elasticsearch SQL、索引生命周期管理 (ILM)、Elastic Maps 等等。

非常重要的是,腾讯云 Elastic 服务将会与 Elastic 在自己 Elastic Cloud 上提供的 Elasticsearch Service(以及与 Elastic 合作的其他平台之上的服务)保持一致,让用户不仅可以使用 Elastic Stack 的全部功能以及 Elastic 越来越丰富的解决方案(例如 App Search、Site Search、Enterprise Search、Logging、APM、Metrics、Security、Business Analytics 等等),还能在多种云服务之间的无缝转换。

Elastic 与众多全球云服务提供商携手为我们的用户和客户提供卓越的 Elasticsearch Service 体验,此次与腾讯云的合作就是我们在这一过程中迈出的另外重要一步。此次合作也进一步呈现了了我们对中国用户的承诺,因为我们一直坚信应在中国本地建立稳定的基石,来为我们的用户、客户和合作伙伴提供支持。目前,我们在中国的发展十分迅速,已经建成了强大的合作伙伴生态系统,而且 Elastic 已在中国设立了负责售后支持、社区、销售、合作伙伴,业务开发和市场营销等部门。我们希望越来越壮大的中国团队能够让这一合作取得成功,并帮助腾讯云打造卓越的 Elasticsearch Service。

【直播回放】ElasticTalk #13 如何使用 Kibana 快速分析表单数据

rockybean 发表了文章 • 0 个评论 • 2936 次浏览 • 2019-05-19 19:30

如果你没来的及参加直播,来看下回放吧!

视频回放地址

ElasticTalk 是一个社区的 Webinar 活动,也欢迎感兴趣的伙伴加入,我们的目标如下:

1.研讨 Elastic Stack 的新功能、原理等,使更多的人以更直接的方式掌握其功能

2.锻炼参与者的选题、语言表达及沟通能力

目前是计划每周六下午 2:00 举行一场,形式主要以在线直播为主。

如果你对这个项目感兴趣,欢迎联系我!

招聘时间

我司在大力招聘 Elastic 技术专家,欢迎感兴趣的同学来投简历,地址如下:

http://www.elastictech.cn/jobs

想在 Elasticsearch 领域精进的同学,不妨来看看机会,作为 Elastic 官方战略级合作伙伴,我们的培训都是和 Elastic 官方同步的,机不可失!

而我们服务的客户遍布金融、证券、零售、制造业,充满挑战,感兴趣的你快来投递简历吧!

【直播报名】ElasticTalk #13 如何使用 Kibana 快速分析表单数据

rockybean 发表了文章 • 0 个评论 • 3201 次浏览 • 2019-05-18 09:49

5月18日(周六) 14:00~15:00

直播内容:

随着 Kibana 功能的进化,Kibana 已经可以作为一款优秀的数据分析平台,本次我们就尝试不写一行代码来用 Kibana 分析一个 csv 文件,并快速制作图表分析数据!

直播方式:

直播链接会在开始前发送到讨论群中。

点击下方网站链接,选择对应 Webinar 注册即可

Webinar 注册链接

【直播报名】ElasticTalk #12 Elasticsearch 数据建模

rockybean 发表了文章 • 0 个评论 • 3290 次浏览 • 2019-05-11 12:03

5月11日(周六) 14:00~15:00

直播内容:

大家都知道数据建模很重要,那么在 elasticsearch 中进行数据建模是应该注意哪些事情呢?快来了解下吧!

直播方式:

直播链接会在开始前发送到讨论群中。

点击下方网站链接,选择对应 Webinar 注册即可

Webinar 注册链接

【直播回放】ElasticTalk #11 用 ELK 来分析 Elastic 的版本发布情况

rockybean 发表了文章 • 0 个评论 • 3008 次浏览 • 2019-05-04 19:19

- Logstash 是什么以及主要组成?

- 如何使用 Logstash 来爬取 github 上的 elastic 版本数据?

- 如何使用 Kibana 来动态分析 elastic 发布数据?

如果你没来的及参加直播,来看下回放吧!

视频回放地址

ElasticTalk 是一个社区的 Webinar 活动,也欢迎感兴趣的伙伴加入,我们的目标如下:

1.研讨 Elastic Stack 的新功能、原理等,使更多的人以更直接的方式掌握其功能

2.锻炼参与者的选题、语言表达及沟通能力

目前是计划每周六下午 2:00 举行一场,形式主要以在线直播为主。

如果你对这个项目感兴趣,欢迎联系我!

招聘时间

我司在大力招聘 Elastic 技术专家,欢迎感兴趣的同学来投简历,地址如下:

http://www.elastictech.cn/jobs

想在 Elasticsearch 领域精进的同学,不妨来看看机会,作为 Elastic 官方战略级合作伙伴,我们的培训都是和 Elastic 官方同步的,机不可失!

而我们服务的客户遍布金融、证券、零售、制造业,充满挑战,感兴趣的你快来投递简历吧!

ElasticTalk #11 用 ELK 来分析 Elastic 的版本发布情况

rockybean 发表了文章 • 0 个评论 • 4281 次浏览 • 2019-05-02 18:56

5月4日(周六) 14:00~15:00

直播内容:

elastic 产品的一大特点就是版本迭代更新速度超级快,那么他们产品发布有无什么规律呢?比如多久会发一个大版本?我们能从历史数据中分析出些规律吗?本次直播我们就用 ELK 来分析下他们的发版情况吧!

直播方式:

直播链接会在开始前发送到讨论群中。

点击下方网站链接,选择对应 Webinar 注册即可

Webinar 注册链接

【直播报名】ElasticTalk #10 Kibana Canvas Intro

rockybean 发表了文章 • 0 个评论 • 3767 次浏览 • 2019-04-27 12:09

4月27日(周六) 14:00~15:00

直播内容:

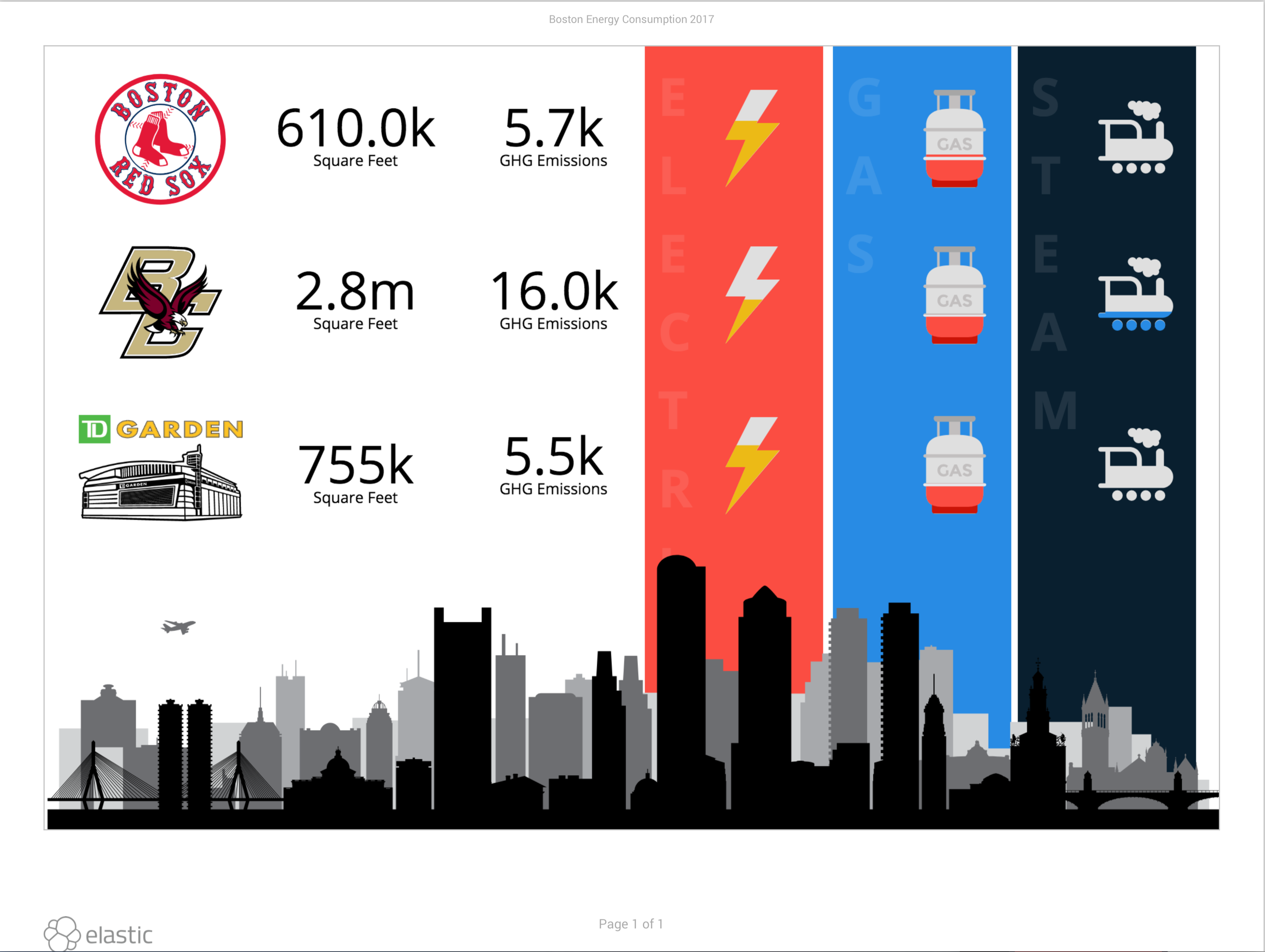

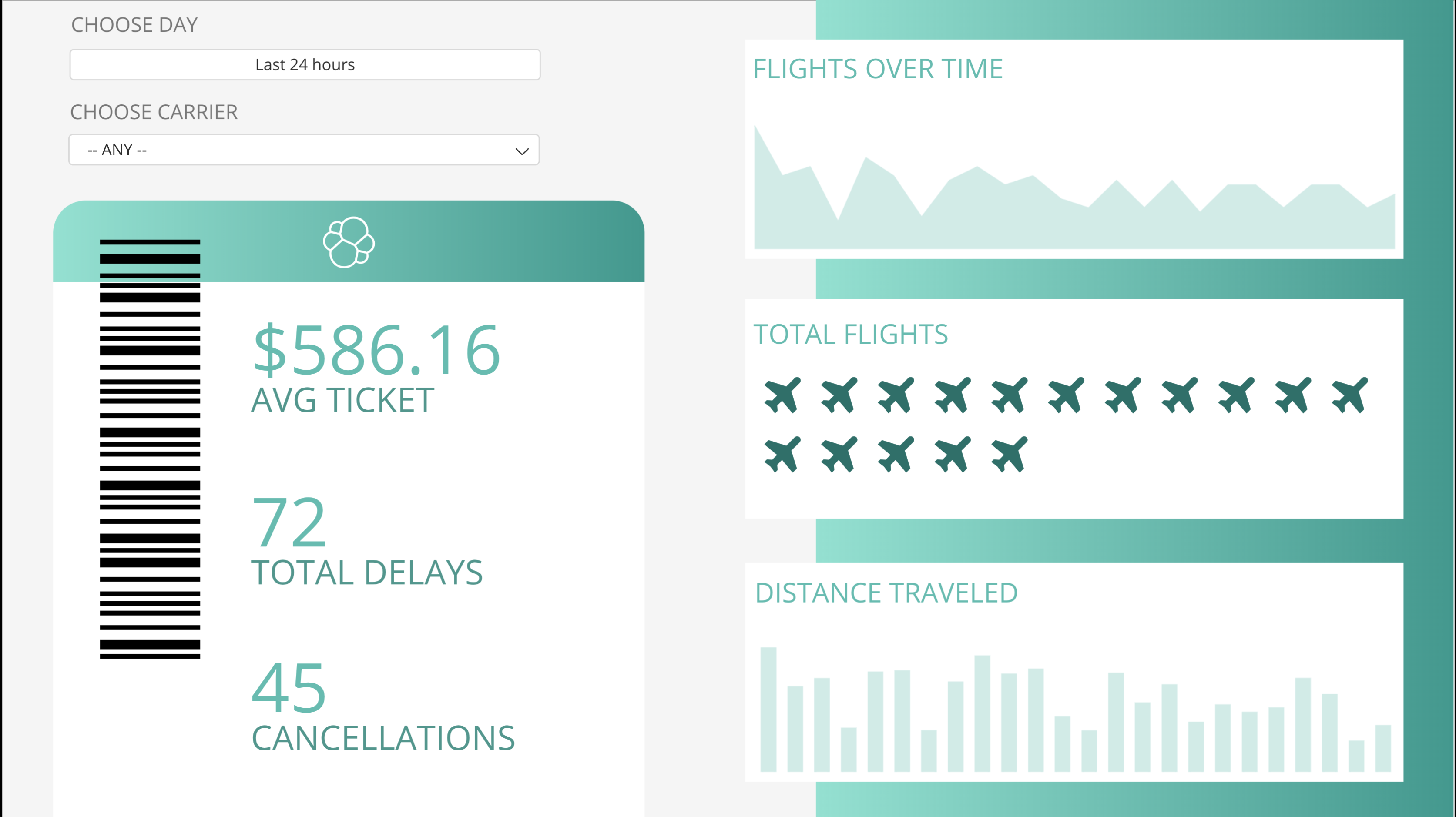

Kibana Canvas 是 ElasticStack 最新的大屏可视化展示方案,允许用户以更高的灵活性实现数据信息图的效果,而且其数据都是实时的,快来了解下吧~

直播方式:

直播链接会在开始前发送到讨论群中。

点击下方网站链接,选择对应 Webinar 注册即可

Webinar 注册链接