ELK

【1月8日】Elastic 中国开发者大会 2021 日程新鲜出炉!福利票抢先购!

Elasticsearch • liaosy 发表了文章 • 0 个评论 • 5409 次浏览 • 2021-12-27 21:46

重要的事情说三遍

- Elastic 中国开发者大会 2021 的精彩日程现已上线!

- Elastic 中国开发者大会 2021 的精彩日程现已上线!

- Elastic 中国开发者大会 2021 的精彩日程现已上线!

关于本次大会

Elastic 中国开发者大会 2021 是由 Elastic 官方、Elastic 中文社区和极限科技联合主办的开发者大会,作为中国国内唯一一个专门讨论 Elasticsearch 开源技术的大会,是中国最权威和最具实力干货的技术大会,其专业性和内容的质量一直以来在业内都是有口皆碑。本次大会邀请的演讲嘉宾有来自 Elastic 官方、Google、腾讯、阿里巴巴、字节跳动、vivo等众多公司的技术专家,为中国广大的 Elasticsearch 开发者提供一个技术交流和学习切磋的地方,汇集业界众多的成功案例,集思广益,发散思维,促进社区和行业的进步。

更多详细介绍请参见大会官网:

关于大会议程

精彩内容不容错过,八折购票火热进行中(折扣码: 80OFF),扫码购买。

花旗金融 - 诚聘ELK平台工程师/架构师

求职招聘 • Hebing1933 回复了问题 • 2 人关注 • 2 个回复 • 3934 次浏览 • 2021-09-29 14:47

2021 Elastic 中文社区深圳线下 Meetup 重磅重启,讲师招募进行中!

活动 • howardhuang 发表了文章 • 0 个评论 • 4165 次浏览 • 2021-05-21 15:49

训练营报名中 | 5天突破Elasticsearch全观测日志分析能力

Elasticsearch • zengcici 发表了文章 • 0 个评论 • 3430 次浏览 • 2020-09-08 11:43

报名时间:截止 2020年9月13日 23:59分 报名链接:https://developer.aliyun.com/learning/trainingcamp/es/1?spm=a2c6h.17708739.J_1655470630.1.20d5624dXGy59Z

训练营介绍

奖品介绍

云栖大会 | Elasticsearch 场景化应用专场,将于2020年9月18日 下午13:00开始,如果你不想错过,马上订阅吧 https://yunqi.aliyun.com/2020/session55?dtrid=6bW7hKei95

更多Elasticsearch 场景化应用,请下载白皮书【Elasticsearch 八大经典应用】 下载链接:https://files.alicdn.com/tpsservice/d95297082f35355f91528a2020afd926.pdf

报名时间:截止 2020年9月13日 23:59分 报名链接:https://developer.aliyun.com/learning/trainingcamp/es/1?spm=a2c6h.17708739.J_1655470630.1.20d5624dXGy59Z

训练营介绍

奖品介绍

云栖大会 | Elasticsearch 场景化应用专场,将于2020年9月18日 下午13:00开始,如果你不想错过,马上订阅吧 https://yunqi.aliyun.com/2020/session55?dtrid=6bW7hKei95

更多Elasticsearch 场景化应用,请下载白皮书【Elasticsearch 八大经典应用】 下载链接:https://files.alicdn.com/tpsservice/d95297082f35355f91528a2020afd926.pdf

logstash消费kafka,日志顺序发生了改变

Logstash • pony_maggie 回复了问题 • 2 人关注 • 1 个回复 • 5001 次浏览 • 2020-07-24 09:23

Logstash正则表达式,如何同时匹配两种格式不同的日志

回复Logstash • onionwithhoney 回复了问题 • 1 人关注 • 1 个回复 • 5137 次浏览 • 2020-04-03 10:30

[已解决]pipline 自动创建索引,ILM报错 Index lifecycle error number_format_exception: For input string: "1|UTC}}"

Elasticsearch • zqc0512 回复了问题 • 2 人关注 • 1 个回复 • 6196 次浏览 • 2019-12-03 16:41

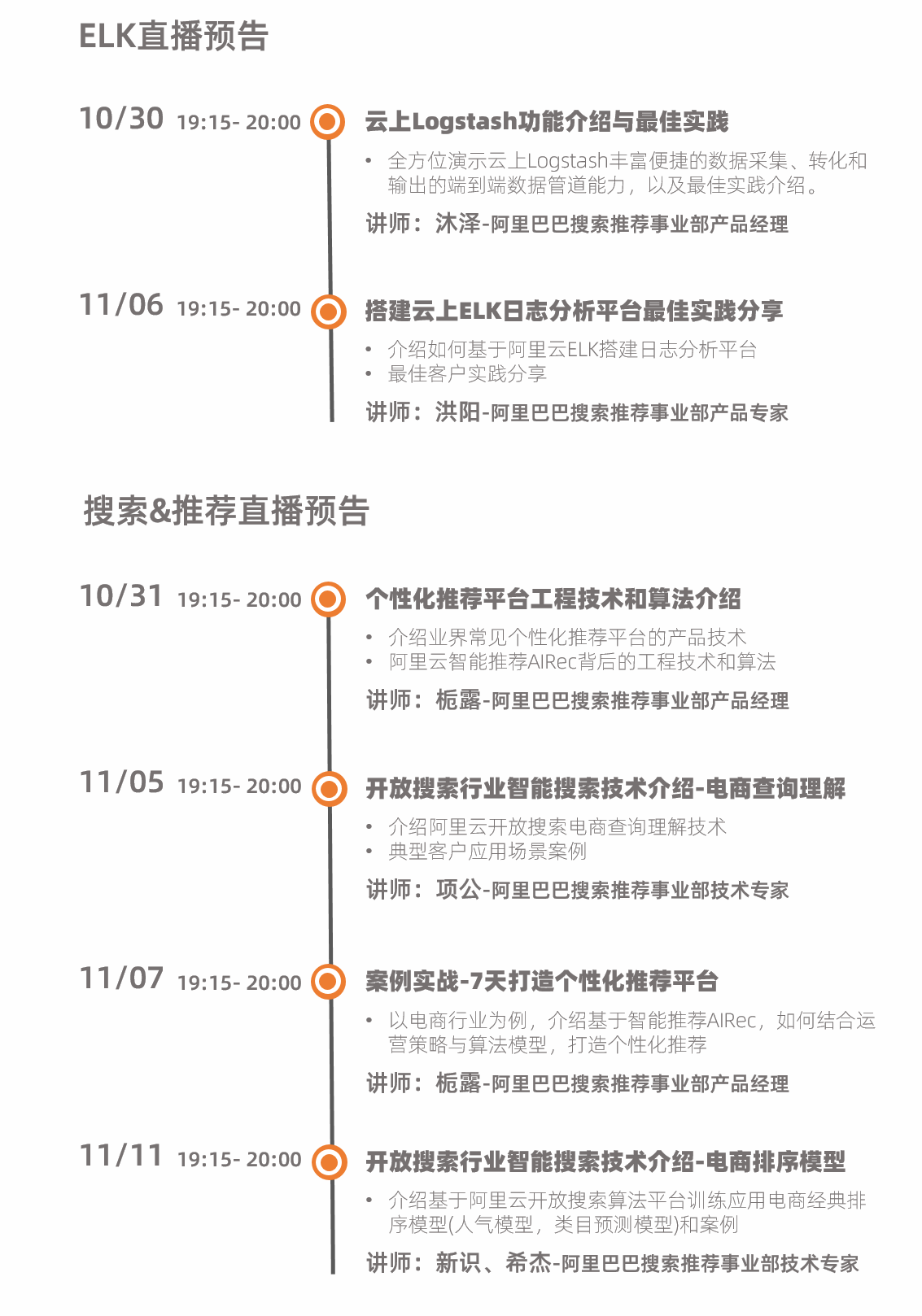

【阿里云技术直播】全面了解ELK云上生态与日志分析场景实践 | 直播预约中

活动 • zengcici 发表了文章 • 0 个评论 • 3989 次浏览 • 2019-10-28 18:06

请问这个时什么工具啊

默认分类 • gomatu 回复了问题 • 3 人关注 • 3 个回复 • 4896 次浏览 • 2019-04-18 14:41

ELK 使用小技巧(第 5 期)

Elasticsearch • rochy 发表了文章 • 0 个评论 • 7411 次浏览 • 2019-02-22 12:24

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Logstash 性能调优主要参数

pipeline.workers:设置启动多少个线程执行 fliter 和 output;当 input 的内容出现堆积而 CPU 使用率还比较充足时,可以考虑增加该参数的大小;pipeline.batch.size:设置单个工作线程在执行过滤器和输出之前收集的最大事件数,较大的批量大小通常更高效,但会增加内存开销。输出插件会将每个批处理作为一个输出单元。;例如,ES 输出会为收到的每个批次发出批量请求;调整pipeline.batch.size可调整发送到 ES 的批量请求(Bulk)的大小;pipeline.batch.delay:设置 Logstash 管道的延迟时间, 管道批处理延迟是 Logstash 在当前管道工作线程中接收事件后等待新消息的最长时间(以毫秒为单位);简单来说,当pipeline.batch.size不满足时,会等待pipeline.batch.delay设置的时间,超时后便开始执行 filter 和 output 操作。

2、'reader' unacceptable character ' ' (0x0)

logstash 执行使用 Jdbc input plugin 后报错:

[main]-pipeline-manager] ERROR logstash.agent - Pipeline aborted due to error {

:exception=>#<Psych::SyntaxError: (): 'reader' unacceptable character ' ' (0x0) special characters are not allowed in "'reader'",

position 0 at line 0 column 0>, :backtrace=>["org/jruby/ext/psych/PsychParser.java:232:in parse'"解决方案:删除 $USER_HOME/.logstash_jdbc_last_run 文件即可。

二、Elasticsearch

1、TermsQuery 与多个 TermQuery 的区别

当 terms 的个数较少的时候,TermsQuery 等效为 ConstantScoreQuery 内部包含多个 TermQuery:

Query q1 = new TermInSetQuery(new Term("field", "foo"), new Term("field", "bar"));

// 等效为下面的语句

BooleanQuery bq = new BooleanQuery();

bq.add(new TermQuery(new Term("field", "foo")), Occur.SHOULD);

bq.add(new TermQuery(new Term("field", "bar")), Occur.SHOULD);

Query q2 = new ConstantScoreQuery(bq);当 terms 较多的时候,它将使用匹配的文档组合成一个位集,并在该位集上进行评分;此时查询效率比普通的 Bool 合并要更加高效。

当 terms 的个数较多时,TermsQuery 比多个 TermQuery 组合的查询效率更高。

2、ES 借助 nginx 配置域名

upstream /data/ {

server 192.168.187.xxx:9200;

keepalive 300 ;

}

server {

listen 80;

server_name testelk.xx.com;

keepalive_timeout 120s 120s;

location /data {

proxy_pass http://data/;

proxy_http_version 1.1;

proxy_set_header Connection "Keep-Alive";

proxy_set_header Proxy-Connection "Keep-Alive";

proxy_set_header X-Real-IP $remote_addr;

proxy_pass_header remote_user

proxy_set_header X-Forwarded-For $remote_addr;

proxy_set_header Host $http_host;

proxy_set_header X-Nginx-Proxy true;

}

}3、ES Reindex 时如何不停止写入服务

方案一:kennywu76

ES 的 reindex 在索引有实时的 update/delete 的情况下,即使借助 alias,也没有办法实现真正的 zero down time。

增加新文档比较好办,通过 alias 切换写入到新索引,同时 reindex 做旧->新索引的数据传输即可;但是 update/delete 操作针对的文档如果还未从旧索引传输过来,直接对新索引操作会导致两个索引数据不一致。

我能够想到的(一个未经实际验证)的方案,前提是数据库里的文档有一个类似 last_update_time 字段记录文档最后更新的时间,用作写入 ES 文档的版本号,然后数据写入新索引的时候,url 里带上下面这样的参数:version_type=external_gt&version=xxxxxx。

其中 version_type=external_gt 表示写入文档的版本号大于已有的文档版本号,或者文档不存在,写入才会成功,否则会抛版本冲突的异常。另外 delete 操作都要转换成 index 操作,index 的内容可以是一个空文档。

这样实时数据写入新索引和 reindex 可以同时进行,实时写入的数据应该具有更高的版本,总是能够成功,reindex 如果遇到版本冲突,说明该文档被实时部分更新过了,已经过时,可以直接放弃跳过。

该方案的缺陷:

- 要求数据源里的数据具有版本信息,可能因为各种局限,不太容易更改;

- delete 操作必须转化为写入一个空文档,delete 实际上是一个标记文档,并且本身也有版本信息。但是如果后端发生了 segment merge,delete 可能会被合并以后物理清除。这样 delete 和对应的版本信息丢失,之后 reindex 如果写入了旧版本的文档,仍然会有一致性问题;但是空文档会增加索引文件的大小,有额外的消耗,一个可能的缓解办法是在 reindex 全部做完以后,再做一次空文档的删除。

改进方案:the_best

重建索引步骤如下:

- 保证 delete 操作都要转换成 index 操作,index 的内容可以是一个空文档;

- 对老索引

old_index(业务上的别名还是挂在老索引上)进行重索引操作(version_type=external);curl -X POST 'http://<hostname>:9200/_reindex' { "conflicts": "proceed", "source": { "index": "old_index", "size": 1000 }, "dest": { "index": "new_index", "version_type": "external" } } - 将别名切到 newIndex;

- 将重索引时间段内

old_index产生的热数据,再捞一次到new_index中(conflicts=proceed&version_type=external);curl -X POST /_reindex { "conflicts": "proceed", "source": { "index": "old_index" "query": { "constant_score" : { "filter" : { "range" : { "data_update_time" : { "gte" : <reindex开始时刻前的毫秒时间戳> } } } } } }, "dest": { "index": "new_index", "version_type": "external" } } - 手动做一次空文档的删除。

这种方式取决于重索引期间产生的数据量大小(会影响步骤4的用时),不过我们可以视具体业务情况灵活操作。比如说数据量比较大重索引我们用了10个小时(这10个小时内新产生了200多万的数据),在切别名前,我们可以按步骤(4)的调用方式,把近10个小时的数据再捞一遍到新索引中,如此迭代个几次,直到别名切完后,我们能保证最后一次的步骤(4)可以在较短时间内完成。

4、ES 节点通讯配置

http.port: 9200

http.bind_host: 127.0.0.1

transport.tcp.port: 9300

transport.bind_host: 127.0.0.15、把 Lucene 的原生 query 传给 ES

SearchRequest searchRequest = new SearchRequest(indexName);

searchRequest.types(typeName);

SearchSourceBuilder sourceBuilder = new SearchSourceBuilder();

sourceBuilder.from(0);

sourceBuilder.size(10);

sourceBuilder.timeout(new TimeValue(60, TimeUnit.SECONDS));

//q为Lucene检索表达式, 直接输入关键词匹配_all或者*字段, 字段匹配user:kimchy,

//多字段匹配user:kimchy AND message:Elasticsearch

QueryStringQueryBuilder queryStringQueryBuilder = QueryBuilders.queryStringQuery(q);

sourceBuilder.query(queryStringQueryBuilder);

searchRequest.source(sourceBuilder);

SearchResponse searchResponse = restHighLevelClient.search(searchRequest);

SearchHits searchHits = searchResponse.getHits();6、ES 文档字段个数限制

ES 文档默认不允许文档字段超过 1000,超过 1000 会报如下错误:

failed to put mappings on indices [[[nfvoemspm/srjL3cMMRUqa7DgOrYqX-A]]], type [log]

java.lang.IllegalArgumentException: Limit of total fields [1000] in index [xxx] has been exceeded可以通过修改索引配置来修改字段个数限制,不过还是推荐从业务上进行优化:

修改settings

{

"index.mapping.total_fields.limit": 2000

}7、将 DSL 字符串转换为 QueryBuilder

## wrapper 案例

GET /_search

{

"query" : {

"wrapper": {

"query" : "eyJ0ZXJtIiA6IHsgInVzZXIiIDogIktpbWNoeSIgfX0="

}

}

}

## RestClient

QueryBuilders.wrapperQuery("{\"term\": {\"field\":\"value\"}}")8、ES 集群重启后 Slice Scroll 速度变慢

重启机器之后,pagecache 都没有了,所有数据都要重新从磁盘加载。

9、ES 开启索引新建删除日志

PUT _cluster/settings

{

"persistent": {

"logger.cluster.service": "DEBUG"

}

}10、慢日志全局级别设定

- 对已经存在的索引可以通过 PUT _settings 做存量设置

- 对之后新增的索引,可以使用类似于下面的template

PUT _template/global-slowlog_template { "order": -1, "version": 0, "template": "*", "settings": { "index.indexing.slowlog.threshold.index.debug" : "10ms", "index.indexing.slowlog.threshold.index.info" : "50ms", "index.indexing.slowlog.threshold.index.warn" : "100ms", "index.search.slowlog.threshold.fetch.debug" : "100ms", "index.search.slowlog.threshold.fetch.info" : "200ms", "index.search.slowlog.threshold.fetch.warn" : "500ms", "index.search.slowlog.threshold.query.debug" : "100ms", "index.search.slowlog.threshold.query.info" : "200ms", "index.search.slowlog.threshold.query.warn" : "1s" } }

11、TCP 设置多个端口的用途

transport.tcp.port这个参数不写,默认为9300-9399,开放那么多 端口有用么?

- 如果设置一个端口,假设这个端口占用了程序就无法正常启动;

- 如果设置多个端口,一个端口占用会寻找下一个端口,直至找到可用端口。

12、ES 临时重启,设置分片延迟分配策略

PUT _all/_settings

{

"settings": {

"index.unassigned.node_left.delayed_timeout": "5m"

}

}三、Kibana

1、kibana 图表自定义标注

可以用 TSVB,支持标注。

Kibana TSVB 注解的使用:https://elasticsearch.cn/article/701

2、Kibana discover 导出 csv 文件

请参考文章:如何快速把 Kibana Discover 页的 Document Table 导出成 CSV

3、修改 kibana 的默认主页

四、社区文章精选

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

ELK 使用小技巧(第 4 期)

Elasticsearch • rochy 发表了文章 • 6 个评论 • 6391 次浏览 • 2019-01-07 20:43

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Logstash 性能调优主要参数

pipeline.workers:设置启动多少个线程执行 fliter 和 output;当 input 的内容出现堆积而 CPU 使用率还比较充足时,可以考虑增加该参数的大小;pipeline.batch.size:设置单个工作线程在执行过滤器和输出之前收集的最大事件数,较大的批量大小通常更高效,但会增加内存开销。输出插件会将每个批处理作为一个输出单元。;例如,ES 输出会为收到的每个批次发出批量请求;调整pipeline.batch.size可调整发送到 ES 的批量请求(Bulk)的大小;pipeline.batch.delay:设置 Logstash 管道的延迟时间, 管道批处理延迟是 Logstash 在当前管道工作线程中接收事件后等待新消息的最长时间(以毫秒为单位);简单来说,当pipeline.batch.size不满足时,会等待pipeline.batch.delay设置的时间,超时后便开始执行 filter 和 output 操作。

2、使用 Ruby Filter 根据现有字段计算一个新字段

filter {

ruby {

code => "event.set('kpi', ((event.get('a') + event.get('b'))/(event.get('c')+event.get('d'))).round(2))"

}

}3、logstash filter 如何判断字段是够为空或者 null

if ![updateTime]4、Date Filter 设置多种日期格式

date {

match => ["logtime", "yyyy-MM-dd HH:mm:ss.SSS","yyyy-MM-dd HH:mm:ss,SSS"]

target => "logtime_utc"

}二、Elasticsearch

1、高效翻页 Search After

通常情况下我们会使用 from 和 size 的方式实现查询结果的翻页,但是当达到深度分页时,成本变得过高(堆内存占用和时间耗费与 from+size 的大小成正比),因此 ES 设置了限制(index.max_result_window),默认值为 10000,防止用户进行过于深入的翻页。

推荐使用 Scroll api 进行高效深度滚动,但滚动上下文代价很高,因此不要将 Scroll 用于实时用户请求。search_after 参数通过提供实时游标来解决深度滚动的问题,其主要思路是使用上一页的结果来帮助检索下一页。

GET twitter/_search

{

"size": 10,

"query": {

"match" : {

"title" : "elasticsearch"

}

},

"search_after": [1463538857, "654323"],

"sort": [

{"date": "asc"},

{"tie_breaker_id": "asc"}

]

}2、ES 文档相似度 BM25 参数设置

ES2.X 默认是以 TF/IDF 算法计算文档相似度,从 ES5.X 开始,BM25 作为默认的相似度计算算法。

PUT /index

{

"settings" : {

"index" : {

"similarity" : {

"my_similarity" : {

"type" : "DFR",

"basic_model" : "g",

"after_effect" : "l",

"normalization" : "h2",

"normalization.h2.c" : "3.0"

}

}

}

}

}

PUT /index/_mapping/_doc

{

"properties" : {

"title" : { "type" : "text", "similarity" : "my_similarity" }

}

}3、ES2.X 得分计算

得分计算脚本:

double tf = Math.sqrt(doc.freq);

double idf = Math.log((field.docCount+1.0)/(term.docFreq+1.0)) + 1.0;

double norm = 1/Math.sqrt(doc.length);

return query.boost * tf * idf * norm;- 忽略词频统计及词频位置:将字段的

index_options设置为docs; - 忽略字段长度:设置字段的

"norms": { "enabled": false };

4、CircuitBreakingException: [parent] Data too large

报错信息:

[WARN ][r.suppressed ] path: /, params: {}

org.elasticsearch.common.breaker.CircuitBreakingException: [parent] Data too large, data for [<http_request>] would be [1454565650/1.3gb], which is larger than the limit of [1454427340/1.3gb], usages [request=0/0b, fielddata=568/568b, in_flight_requests=0/0b, accounting=1454565082/1.3gb]jvm 堆内存不够当前查询加载数据所以会报 data too large, 请求被熔断,indices.breaker.request.limit默认为 jvm heap 的 60%,因此可以通过调整 ES 的 Heap Size 来解决该问题。

5、ES 免费的自动化运维工具推荐

- Ansible: https://github.com/elastic/ansible-elasticsearch

- Puppet: https://github.com/elastic/puppet-elasticsearch

- Cookbook: https://github.com/elastic/cookbook-elasticsearch

- Curator:https://www.elastic.co/guide/en/elasticsearch/client/curator/current/about.html

6、elasticsearch-hanlp 分词插件包

核心功能:

- 内置多种分词模式,适合不同场景;

- 内置词典,无需额外配置即可使用;

- 支持外置词典,用户可自定义分词算法,基于词典或是模型;

- 支持分词器级别的自定义词典,便于用于多租户场景;

- 支持远程词典热更新(待开发);

- 拼音过滤器、繁简体过滤器(待开发);

- 基于词语或单字的 ngram 切分分词(待开发)。

7、节点重启时延迟索引分片重分配

当某个节点短时间离开集群时,一般是不会影响整体系统运行的,可以通过下面的请求延迟索引分片的再分配。

PUT _all/_settings

{

"settings": {

"index.unassigned.node_left.delayed_timeout": "5m"

}

}8、ES 数据修改后,查询还是未修改前的数据

默认是 1 秒可见,如果你的需求一定要写完就可见,那在写的时候增加 refresh 参数,强制刷新即可,但强烈建议不这么干,因为这样会把整个集群拖垮。

9、Terms Query 从另一个索引获取 terms

当 Terms Query 需要指定很多 terms 的时候,如果手动设置还是相当麻烦的,可以通过 terms-lookup 的方式从另外一个索引加载需要匹配的 terms。

PUT /users/_doc/2

{

"followers" : ["1", "3"]

}

PUT /tweets/_doc/1

{

"user" : "1"

}

GET /tweets/_search

{

"query" : {

"terms" : {

"user" : {

"index" : "users",

"type" : "_doc",

"id" : "2",

"path" : "followers"

}

}

}

}

-----------等效下面的语句--------------

PUT /users/_doc/2

{

"followers" : [

{

"id" : "1"

},

{

"id" : "2"

}

]

}10、ES 备份路径设置

报错信息:

doesn't match any of the locations specified by path.repo because this setting is empty结局方案,修改 ES 的配置文件:

# 在 elasticsearch.yml 中添加下面配置来设置备份仓库路径

path.repo: ["/home/test/backup/zty_logstash"]11、Query cache 和 Filter cache 的区别

Filter cache 被重命名为 Node Query Cache,也就是说 Query cache 等同于 Filter cache;Query Cache 采用了 LRU 的缓存方式(当缓存满的时候,淘汰旧的不用的缓存数据),Query Cache 只缓存被用于 filter 上下文的内容。

12、Shard 大小需要考虑的因素有哪些?

Lucene 底层没有这个大小的限制,20-40GB 的这个区间范围本身就比较大,经验值有时候就是拍脑袋,不一定都好使。

- Elasticsearch 对数据的隔离和迁移是以分片为单位进行的,分片太大,会加大迁移成本;

- 一个分片就是一个 Lucene 的库,一个 Lucene 目录里面包含很多 Segment,每个 Segment 有文档数的上限,Segment 内部的文档 ID 目前使用的是 Java 的整型,也就是 2 的 31 次方,所以能够表示的总的文档数为 Integer.MAX_VALUE - 128 = 2^31 - 128 = 2147483647 - 1 = 2,147,483,519,也就是21.4亿条;

- 同样,如果你不 force merge 成一个 Segment,单个 shard 的文档数能超过这个数;

- 单个 Lucene 越大,索引会越大,查询的操作成本自然要越高,IO 压力越大,自然会影响查询体验;

- 具体一个分片多少数据合适,还是需要结合实际的业务数据和实际的查询来进行测试以进行评估。

13、ES 索引更新时通过 mapping 限制指定字段更新

Elasticsearch 默认是 Dynamic Mapping,新字段会自动猜测数据类型,并自动 merge 到之前的 Mapping,你可以在 Mapping 里面可以配置字段是否支持动态加入,设置参数dynamic即可:true,默认,表示支持动态加入新字段;false,表示忽略该字段的后续索引等操作,但是索引还是成功的;strict支持不支持未知字段,直接抛错。

14、ES 数据快照到 HDFS

ES 做快照和使用 ES-Hadoop 导数据是完全的两种不同的方式,使用 ES-Hadoopp 后期导入的成本可能也不小。

- 如果要恢复快,当然是做快照和还原的方式最快,速度完全取决于网络和磁盘的速度;

- 如果为了节省磁盘,快照的时候,可以选 6.5 最新支持的

source_only模式,导出的快照要小很多,不过恢复的时候要进行重建,速度慢。

15、segment.memory 简介

segment 的大小,和 indexing buffer 有关,有三种方式会生成 segment:

- 一种是 indexing buffer 写满了会生成 segment 文件,默认是堆内存的10%,是节点共享的;

- 一种是 index buffer 有文档,但是还没满,但是 refresh 时间到了,这个时候就会把 buffer 里面的生成 segment 文件;

- 还有最后一种就是 es 自动的会将小的 segment 文件定期合并产生新的 segment 文件。

三、社区文章精选

- 2018 年 Elastic Advent Calendar 分享活动

- 使用 ES-Hadoop 将 Spark Streaming 流数据写入 ES

- Elastic Stack 6.5 最新功能

- 让Elasticsearch飞起来!——性能优化实践干货

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

logstash sql_last_value 记录的时间比SQL查到的最后一条数据的时间大十四个小时

Logstash • zqc0512 回复了问题 • 4 人关注 • 3 个回复 • 6059 次浏览 • 2018-12-24 08:54

Day 1 - ELK 使用小技巧(第 3 期)

Advent • rochy 发表了文章 • 1 个评论 • 6069 次浏览 • 2018-12-01 02:28

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Filebeat 设置多个 output

在 6.0 之前,Filebeat 可以设置多个输出(必须是不同类型的输出);从 6.0 开始已经禁止多输出了,只能拥有一个输出,如果想实现多输出,可以借助 logstash 等中间组件进行输出分发。

二、Elasticsearch

1、ES 用户占用的内存大于为 ES 设置的 heapsize

ES 是 Java 应用,底层存储引擎是基于 Lucene 的,heapsize 设置的是 Java 应用的内存;而 Lucene 建立倒排索引(Inverted Index)是先在内存里生成,然后定期以段文件(segment file)的形式刷到磁盘的,因此 Lucene 也会占用一部分内存。

2、ES 使用别名插入数据

ES 可以通过索引的方式向索引插入数据,但是同时只能有一个索引可以被写入,而且需要手动设置,未设置的情况下会报错:no write index is defined for alias [xxxx], The write index may be explicitly disabled using is_write_index=false or the alias points to multiple indices without one being designated as a write index。

POST /_aliases

{

"actions" : [

{

"add" : {

"index" : "test",

"alias" : "alias1",

"is_write_index" : true

}

}

]

}3、ES 设置 G1 垃圾回收

修改 jvm.options文件,将下面几行:

-XX:+UseConcMarkSweepGC

-XX:CMSInitiatingOccupancyFraction=75

-XX:+UseCMSInitiatingOccupancyOnly改为

-XX:+UseG1GC

-XX:MaxGCPauseMillis=50即可。

其中 -XX:MaxGCPauseMillis 是控制预期的最高 GC 时长,默认值为 200ms,如果线上业务特性对于 GC 停顿非常敏感,可以适当设置低一些。但是这个值如果设置过小,可能会带来比较高的 cpu 消耗。

4、ES 和 Zipkin 集成时设置验证信息

java -DKAFKA_ZOOKEEPER=10.14.123.117:2181

-DSTORAGE_TYPE=elasticsearch

-DES_HOSTS=http://10.14.125.5:9200

ES_USERNAME=xxx ES_PASSWORD=xxx

-jar zipkin.jar5、ES 集群部署报错

问题 1 报错信息如下:

Received message from unsupported version:[2.0.0] minimal compatible version is:[5.6.0]经排查是集群中存在低版本的 ES 实例,将低版本实例移除即可。

问题 2 报错信息如下:

with the same id but is a different node instance删除对应节点 elsticsearch 文件夹下的 data 文件夹下的节点数据即可。

6、海量中文分词插件

海量分词是天津海量信息技术股份有限公司自主研发的中文分词核心,经测试分词效果还是不错的,值得一试。

7、查询一个索引下的所有 type 名

通过下面的 API,即可获取全部的 type,下面的例子中 doc 就是 indexName 索引下的一个 type:

GET http://es127.0.0.1:9200/indexName/_mappings

-----------------------------------------------

{

indexName: - {

mappings: - {

doc: - {

_all: + {... },

dynamic_date_formats: + [... ],

dynamic_templates: + [... ],

properties: + {... }

}

}

}

}8、索引模板中根据字段值设置别名

设置索引模板的时候,别名可以使用 Query 条件来进行匹配。

PUT _template/template_1

{

"index_patterns" : ["te*"],

"settings" : {

"number_of_shards" : 1

},

"aliases" : {

"alias2" : {

"filter" : {

"term" : {"user" : "kimchy" }

},

"routing" : "kimchy"

},

"{index}-alias" : {}

}

}9、索引模板设置默认时间匹配格式

ES 默认是不会将 yyyy-MM-dd HH:mm:ss 识别为时间的,可以通过在索引模板进行如下设置实现多种时间格式的识别:

"mappings": {

"doc": {

"dynamic_date_formats": ["yyyy-MM-dd HH:mm:ss||strict_date_optional_time||epoch_millis"],10、ES 中 Merge 相关设置

Merge 是非常耗费 CPU 的操作;而且如果不是 SSD 的话,推荐将 index.merge.scheduler.max_thread_count 设置为 1;否则 ES 会启动 Math.min(3, Runtime.getRuntime().availableProcessors() / 2) 个线程进行 Merge 操作;这样大部分机械硬盘的磁盘 IO 都很难承受,就可能出现阻塞。

"index": {

"refresh_interval": "5s",

"number_of_shards": "3",

"max_result_window": 10000,

"translog": {

"flush_threshold_size": "500mb",

"sync_interval": "30s",

"durability": "async"

},

"merge": {

"scheduler": {

"max_merge_count": "100",

"max_thread_count": "1"

}

},11、mapping 中 enabled store index 参数

- enabled:默认是true,只用于 mapping 中的 object 字段类型;当设置为 false 时,其作用是使 es 不去解析该字段,并且该字段不能被查询和 store,只有在 source 中才能看到,设置 enabled 为 false,可以不设置字段类型,默认类型为 object;

- store:默认 false,store 参数的功能和 source 有一些相似,我们的数据默认都会在 source 中存在,但我们也可以将数据 store 起来;当我们使用

copy_to参数时,copy_to的目标字段并不会在 source 中存储,此时 store 就派上用场了; - index:默认是 true,当设置为 false,表明该字段不能被查询,如果查询会报错。

12、ES 图片搜索

- 可以借助局部敏感 LSH 或者 pHash 来实现:https://stackoverflow.com/questions/32785803

- Github 也有一个开源项目使用了多种 Hash 算法借助 ES 来实现图片搜索:https://github.com/usc-isi-i2/elasticsearch-image-features

13、Term 聚合根据子聚合结果排序

GET /_search

{

"aggs" : {

"genres" : {

"terms" : {

"field" : "genre",

"order" : { "playback_stats.max" : "desc" }

},

"aggs" : {

"playback_stats" : { "stats" : { "field" : "play_count" } }

}

}

}

}三、社区文章精选

ELK 使用小技巧(第 2 期)

Elasticsearch • rochy 发表了文章 • 1 个评论 • 8522 次浏览 • 2018-11-17 18:36

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Filebeat :Non-zero metrics in the last 30s

- 问题表现:Filebeat 无法向 Elasticsearch 发送日志数据;

- 错误信息:

INFO [monitoring] 1og/log.go:124 Non-zero metrics in the last 30s; - 社区反馈:在 input 和 output 下面添加属性 enabled:true。

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/*.log

output.elasticsearch:

hosts: ["https://localhost:9200"]

username: "filebeat_internal"

password: "YOUR_PASSWORD"

enabled: trueinput 和 output 下 enabled 属性默认值为 true,因此怀疑另有其因。

2、Logstash 按月生成索引

output {

if [type] == "typeA"{

elasticsearch {

hosts => "127.0.0.1:9200"

index => "log_%{+YYYY_MM}"

}

}

}按照日的原理类似:%{+YYYY.MM.dd}

3、Filebeat 通过配置删除特定字段

Filebeat 实现了类似 Logstash 中 filter 的功能,叫做处理器(processors),processors 种类不多,尽可能在保持 Filebeat 轻量化的基础上提供更多常用的功能。

下面列几种常用的 processors:

add_cloud_metadata:添加云服务器的 meta 信息;add_locale:添加本地时区;decode_json_fields:解析并处理包含 Json 字符串的字段;drop_event:丢弃符合条件的消息事件;drop_fields:删除符合条件的字段;include_fields:选择符合条件的字段;rename:字段重命名;add_kubernetes_metadata:添加 k8s 的 meta 信息;add_docker_metadata:添加容器的 meta 信息;add_host_metadata:添加操作系统的 meta 信息;dissect:类似与 gork 的正则匹配字段的功能;dns:配置 filebeat 独立的 dns 解析方式;add_process_metadata:添加进程的元信息。

processors 的使用方式:

- type: <input_type>

processors:

- <processor_name>:

when:

<condition>

<parameters>

...4、LogStash 采集 FTP 日志文件

exec {

codec => plain { }

command => "curl ftp://server/logs.log"

interval => 3000}

}5、Logstash docker-compose 启动失败(Permission denied)

在 docker-compose 中使用 user 选项设置使用 root 用户启动 docker,能解决权限问题。

$ cat docker-compose.yml

version: '2'

services:

logstash:

image: docker.elastic.co/logstash/logstash:6.4.2

user: root

command: id6、Metricize filter plugin

将一条消息拆分为多条消息。

# 原始信息

{

type => "type A"

metric1 => "value1"

metric2 => "value2"

}

# 配置信息

filter {

metricize {

metrics => [ "metric1", "metric2" ]

}

}

# 最终输出

{ {

type => "type A" type => "type A"

metric => "metric1" metric => "metric2"

value => "value1" value => "value2"

} }二、Elasticsearch

1、ES 倒排索引内部结构

Lucene 的倒排索引都是按照字段(field)来存储对应的文档信息的,如果 docName 和 docContent 中有“苹果”这个 term,就会有这两个索引链,如下所示:

docName:

"苹果" -> "doc1, doc2, doc3..."

docContent:

"苹果" -> "doc2, doc4, doc6..."2、Jest 和 RestHighLevelClient 哪个好用点

RestHighLevelClient 是官方组件,会一直得到官方的支持,且会与 ES 保持同步更新,推荐使用官方的高阶 API。

Jest 由于是社区维护,所以更新会有一定延迟,目前最新版对接 ES6.3.1,近一个月只有四个 issue,说明整体活跃度较低,因此不推荐使用。

此外推荐一份 TransportClient 的中文使用手册,翻译的很不错:https://github.com/jackiehff/elasticsearch-client-java-api-cn。

3、ES 单分片使用 From/Size 分页遇到重复数据

常规情况下 ES 单分片使用 From/Size 是不会遇到数据重复的,数据重复的可能原因有:

- 没有添加排序;

- 添加了按得分排序,但是查询语句全部为 filter 过滤条件(此时得分都一致);

- 添加了排序,但是有索引中文档的新增、修改、删除等操作。

对于多分片,推荐添加 preference 参数来实现分页结果的一致性。

4、The number of object passed must be even but was [1]

ES 在调用 setSource 的时候传入 Json 对象后会报错:The number of object passed must be even but was [1],此时可以推荐将 Json 对象转为 Map 集合,或者把 Json 对象转为 json 字符串,不过传入字符串的时候需要设置类型。

IndexRequest indexRequest = new IndexRequest("index", "type", "id");

JSONObject doc = new JSONObject();

//indexRequest.source(jsonObject); 错误的使用方法

//转为 Map 对象

indexRequest.source(JSONObject.parseObject((String) doc.get("json"), Map.class));

//转为 Json 字符串(声明字符串类型)

indexRequest.source(JSON.toJSONString(doc), XContentType.JSON);5、跨集群搜索

ES 6.X 原生支持跨集群搜索,具体配置请参考:https://www.elastic.co/guide/en/kibana/current/management-cross-cluster-search.html

PUT _cluster/settings

{

"persistent": {

"cluster": {

"remote": {

"cluster_one": {

"seeds": [

"127.0.0.1:9300"

]

},

"cluster_two": {

"seeds": [

"127.0.0.1:9301"

]

},

"cluster_three": {

"seeds": [

"127.0.0.1:9302"

]

}

}

}

}

}ES 6.5 推出了新功能,跨集群同步(Cross-cluster replication),感兴趣的可以自行了解。

6、ES 排序时设置空值排序位置

GET /_search

{

"sort" : [

{ "price" : {"missing" : "_last"} }

],

"query" : {

"term" : { "product" : "chocolate" }

}

}7、ES 冷归档数据如何处理

使用相对低配的大磁盘机器配置为 ES 的 Warm Nodes,可以通过 index.routing.allocation.require.box_type 来设置索引是冷数据或者热数据。如果索引极少使用,可以 close 索引,然后在需要搜索的时候 open 即可。

8、ES 相似文章检测

对于大文本的去重,可以参考 SimHash 算法,通过 SimHash 可以提取到文档指纹(64位),两篇文章通过 SimHash 计算海明距离即可判断是否重复。海明距离计算,可以通过插件实现:https://github.com/joway/elasticsearch-hamming-plugin

9、Terms 聚合查询优化

- 如果只需要聚合后前 N 条记录,推荐在 Terms 聚合时添加上

"collect_mode": "breadth_first"; - 此外可以通过设置

"min_doc_count": 10来限制最小匹配文档数; - 如果对返回的 Term 有所要求,可以通过设置

include和exclude来过滤 Term; - 如果想获取全部 Term 聚合结果,但是聚合结果又很多,可以考虑将聚合分成多个批次分别取回(Filtering Values with partitions)。

10、Tomcat 字符集造成的 ES 查询无结果

两个系统连接同一个 ES 服务,配置和代码完全一致,同一个搜索条件,一个能够搜索出来东西,一个什么都搜索不出来,排查结果是因为其中一个系统的 tomcat 配置有问题,导致请求的时候乱码了,所以搜不到数据。

11、ES 索引设置默认分词器

默认情况下,如果字段不指定分词器,ES 或使用 standard 分词器进行分词;可以通过下面的设置更改默认的分词器。

2.X 支持设置默认的索引分词器(default_index)和默认的查询分词器(default_search),6.X 已经不再支持。

PUT /index

{

"settings": {

"analysis": {

"analyzer": {

"default": {

"type": "ik_max_word",

"tokenizer": "ik_max_word"

}

}

}

}

}12、ES 中的魔法参数

- 索引名:_index

- 类型名:_type

- 文档Id:_id

- 得分:_score

- 索引排序:_doc

如果你对排序没有特别的需求,推荐使用 _doc 进行排序,例如执行 Scroll 操作时。

13、ES 延迟执行数据上卷(Rollup )

Rollup job 有个 delay 参数控制 job 执行的延迟时间,默认情况下不延迟执行,这样如果某个 interval 的数据已经聚合好了,该 interval 迟到的数据是不会处理的。

好在 rollup api 可以支持同时搜索裸索引和 rollup 过的索引,所以如果数据经常有延迟的话,可以考虑设置一个合适的 delay,比如 1h、6h 甚至 24h,这样 rollup 的索引产生会有延迟,但是能确保迟到的数据被处理。

从应用场景上看,rollup 一般是为了对历史数据做聚合存放,减少存储空间,所以延迟几个小时,甚至几天都是合理的。搜索的时候,同时搜索最近的裸索引和历史的 rollup 索引,就能将两者的数据组合起来,在给出正确的聚合结果的情况下,又兼顾了性能。

Rollup 是实验性功能,不过非常有用,特别是使用 ES 做数据仓库的场景。

14、ES6.x 获取所有的聚合结果

ES2.x 版本中,在聚合查询时,通过设置 setSize(0) 就可以获取所有的聚合结果,在ES6.x 中直接设置 setSize(Integer.MAX_VALUE) 等效于 2.x 中设置为 0。

15、ES Jar 包冲突问题

经常会遇到 ES 与业务集成时出现 Jar 包冲突问题,推荐的解决方法是使用 maven-shade-plugin 插件,该插件通过将冲突的 Jar 包更换一个命名空间的方式来解决 Jar 包的冲突问题,具体使用可以参考文章:https://www.jianshu.com/p/d9fb7afa634d。

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>2.4.1</version>

<configuration>

<createDependencyReducedPom>false</createDependencyReducedPom>

</configuration>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<relocations>

<relocation>

<pattern>com.google.guava</pattern>

<shadedPattern>net.luculent.elasticsearch.guava</shadedPattern>

</relocation>

<relocation>

<pattern>com.fasterxml.jackson</pattern>

<shadedPattern>net.luculent.elasticsearch.jackson</shadedPattern>

</relocation>

<relocation>

<pattern>org.joda</pattern>

<shadedPattern>net.luculent.elasticsearch.joda</shadedPattern>

</relocation>

<relocation>

<pattern>com.google.common</pattern>

<shadedPattern>net.luculent.elasticsearch.common</shadedPattern>

</relocation>

<relocation>

<pattern>com.google.thirdparty</pattern>

<shadedPattern>net.luculent.elasticsearch.thirdparty</shadedPattern>

</relocation>

</relocations>

<transformers>

<transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer" />

<transformer implementation="org.apache.maven.plugins.shade.resource.ServicesResourceTransformer"/>

</transformers>

</configuration>

</execution>

</executions>

</plugin>

</plugins>16、ES 如何选择 Shard 存储文档?

ES 采用 djb2 哈希算法对要索引文档的指定(或者默认随机生成的)_id 进行哈希,得到哈希结果后对索引 shard 数目 n 取模,公式如下:hash(_id) % n;根据取模结果决定存储到哪一个 shard 。

三、Kibana

1、在 Kiabana 的 Discovery 界面显示自定义字段

Kibana 的 Discovery 界面默认只显示 time 和 _source 两个字段,这个界面的左半部分,在 Popular 下面展示了很多,你只需要在你需要展示的字段后面点击 add 即可将自定义的字段添加到 discovery 界面。

2、filebeat 的 monitor 指标的说明

- Total:'All events newly created in the publishing pipeline'

- Emitted: 'Events processed by the output (including retries)'

- Acknowledged:'Events acknowledged by the output (includes events dropped by the output)'

- Queued:'Events added to the event pipeline queue'

四、社区文章精选

- Elastic认证考试心得

- 一文快速上手Logstash

- 当Elasticsearch遇见Kafka--Kafka Connect

- elasticsearch冷热数据读写分离

- elasticsearch优秀实践

- ELK 使用小技巧(第 1 期)

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

2021 Elastic 中文社区深圳线下 Meetup 重磅重启,讲师招募进行中!

活动 • howardhuang 发表了文章 • 0 个评论 • 4165 次浏览 • 2021-05-21 15:49

logstash消费kafka,日志顺序发生了改变

回复Logstash • pony_maggie 回复了问题 • 2 人关注 • 1 个回复 • 5001 次浏览 • 2020-07-24 09:23

Logstash正则表达式,如何同时匹配两种格式不同的日志

回复Logstash • onionwithhoney 回复了问题 • 1 人关注 • 1 个回复 • 5137 次浏览 • 2020-04-03 10:30

[已解决]pipline 自动创建索引,ILM报错 Index lifecycle error number_format_exception: For input string: "1|UTC}}"

回复Elasticsearch • zqc0512 回复了问题 • 2 人关注 • 1 个回复 • 6196 次浏览 • 2019-12-03 16:41

logstash sql_last_value 记录的时间比SQL查到的最后一条数据的时间大十四个小时

回复Logstash • zqc0512 回复了问题 • 4 人关注 • 3 个回复 • 6059 次浏览 • 2018-12-24 08:54

elastisearch一个索引很大,是否会造成系统负载过高

回复Elasticsearch • laoyang360 回复了问题 • 5 人关注 • 3 个回复 • 4880 次浏览 • 2018-09-26 13:10

【求助】添加es的默认mapping模板的一些字段,但是出现报错

回复Elasticsearch • lovefirewall 回复了问题 • 5 人关注 • 6 个回复 • 18719 次浏览 • 2018-09-22 00:45

filebeat收集日志在kibana中展示时存在毫秒级排序问题

回复Kibana • 张玉明 回复了问题 • 5 人关注 • 6 个回复 • 8739 次浏览 • 2018-09-18 19:26

【求助】elk的索引名,在filebeat定义的名字和解析过后不一致

回复Logstash • luohuanfeng 回复了问题 • 2 人关注 • 2 个回复 • 5184 次浏览 • 2018-09-11 17:05

elasticsearch的分片问题 出现UNASSIGNED

回复Elasticsearch • zqc0512 回复了问题 • 5 人关注 • 3 个回复 • 7187 次浏览 • 2018-09-10 16:01

【1月8日】Elastic 中国开发者大会 2021 日程新鲜出炉!福利票抢先购!

Elasticsearch • liaosy 发表了文章 • 0 个评论 • 5409 次浏览 • 2021-12-27 21:46

重要的事情说三遍

- Elastic 中国开发者大会 2021 的精彩日程现已上线!

- Elastic 中国开发者大会 2021 的精彩日程现已上线!

- Elastic 中国开发者大会 2021 的精彩日程现已上线!

关于本次大会

Elastic 中国开发者大会 2021 是由 Elastic 官方、Elastic 中文社区和极限科技联合主办的开发者大会,作为中国国内唯一一个专门讨论 Elasticsearch 开源技术的大会,是中国最权威和最具实力干货的技术大会,其专业性和内容的质量一直以来在业内都是有口皆碑。本次大会邀请的演讲嘉宾有来自 Elastic 官方、Google、腾讯、阿里巴巴、字节跳动、vivo等众多公司的技术专家,为中国广大的 Elasticsearch 开发者提供一个技术交流和学习切磋的地方,汇集业界众多的成功案例,集思广益,发散思维,促进社区和行业的进步。

更多详细介绍请参见大会官网:

关于大会议程

精彩内容不容错过,八折购票火热进行中(折扣码: 80OFF),扫码购买。

2021 Elastic 中文社区深圳线下 Meetup 重磅重启,讲师招募进行中!

活动 • howardhuang 发表了文章 • 0 个评论 • 4165 次浏览 • 2021-05-21 15:49

训练营报名中 | 5天突破Elasticsearch全观测日志分析能力

Elasticsearch • zengcici 发表了文章 • 0 个评论 • 3430 次浏览 • 2020-09-08 11:43

报名时间:截止 2020年9月13日 23:59分 报名链接:https://developer.aliyun.com/learning/trainingcamp/es/1?spm=a2c6h.17708739.J_1655470630.1.20d5624dXGy59Z

训练营介绍

奖品介绍

云栖大会 | Elasticsearch 场景化应用专场,将于2020年9月18日 下午13:00开始,如果你不想错过,马上订阅吧 https://yunqi.aliyun.com/2020/session55?dtrid=6bW7hKei95

更多Elasticsearch 场景化应用,请下载白皮书【Elasticsearch 八大经典应用】 下载链接:https://files.alicdn.com/tpsservice/d95297082f35355f91528a2020afd926.pdf

报名时间:截止 2020年9月13日 23:59分 报名链接:https://developer.aliyun.com/learning/trainingcamp/es/1?spm=a2c6h.17708739.J_1655470630.1.20d5624dXGy59Z

训练营介绍

奖品介绍

云栖大会 | Elasticsearch 场景化应用专场,将于2020年9月18日 下午13:00开始,如果你不想错过,马上订阅吧 https://yunqi.aliyun.com/2020/session55?dtrid=6bW7hKei95

更多Elasticsearch 场景化应用,请下载白皮书【Elasticsearch 八大经典应用】 下载链接:https://files.alicdn.com/tpsservice/d95297082f35355f91528a2020afd926.pdf

【阿里云技术直播】全面了解ELK云上生态与日志分析场景实践 | 直播预约中

活动 • zengcici 发表了文章 • 0 个评论 • 3989 次浏览 • 2019-10-28 18:06

ELK 使用小技巧(第 5 期)

Elasticsearch • rochy 发表了文章 • 0 个评论 • 7411 次浏览 • 2019-02-22 12:24

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Logstash 性能调优主要参数

pipeline.workers:设置启动多少个线程执行 fliter 和 output;当 input 的内容出现堆积而 CPU 使用率还比较充足时,可以考虑增加该参数的大小;pipeline.batch.size:设置单个工作线程在执行过滤器和输出之前收集的最大事件数,较大的批量大小通常更高效,但会增加内存开销。输出插件会将每个批处理作为一个输出单元。;例如,ES 输出会为收到的每个批次发出批量请求;调整pipeline.batch.size可调整发送到 ES 的批量请求(Bulk)的大小;pipeline.batch.delay:设置 Logstash 管道的延迟时间, 管道批处理延迟是 Logstash 在当前管道工作线程中接收事件后等待新消息的最长时间(以毫秒为单位);简单来说,当pipeline.batch.size不满足时,会等待pipeline.batch.delay设置的时间,超时后便开始执行 filter 和 output 操作。

2、'reader' unacceptable character ' ' (0x0)

logstash 执行使用 Jdbc input plugin 后报错:

[main]-pipeline-manager] ERROR logstash.agent - Pipeline aborted due to error {

:exception=>#<Psych::SyntaxError: (): 'reader' unacceptable character ' ' (0x0) special characters are not allowed in "'reader'",

position 0 at line 0 column 0>, :backtrace=>["org/jruby/ext/psych/PsychParser.java:232:in parse'"解决方案:删除 $USER_HOME/.logstash_jdbc_last_run 文件即可。

二、Elasticsearch

1、TermsQuery 与多个 TermQuery 的区别

当 terms 的个数较少的时候,TermsQuery 等效为 ConstantScoreQuery 内部包含多个 TermQuery:

Query q1 = new TermInSetQuery(new Term("field", "foo"), new Term("field", "bar"));

// 等效为下面的语句

BooleanQuery bq = new BooleanQuery();

bq.add(new TermQuery(new Term("field", "foo")), Occur.SHOULD);

bq.add(new TermQuery(new Term("field", "bar")), Occur.SHOULD);

Query q2 = new ConstantScoreQuery(bq);当 terms 较多的时候,它将使用匹配的文档组合成一个位集,并在该位集上进行评分;此时查询效率比普通的 Bool 合并要更加高效。

当 terms 的个数较多时,TermsQuery 比多个 TermQuery 组合的查询效率更高。

2、ES 借助 nginx 配置域名

upstream /data/ {

server 192.168.187.xxx:9200;

keepalive 300 ;

}

server {

listen 80;

server_name testelk.xx.com;

keepalive_timeout 120s 120s;

location /data {

proxy_pass http://data/;

proxy_http_version 1.1;

proxy_set_header Connection "Keep-Alive";

proxy_set_header Proxy-Connection "Keep-Alive";

proxy_set_header X-Real-IP $remote_addr;

proxy_pass_header remote_user

proxy_set_header X-Forwarded-For $remote_addr;

proxy_set_header Host $http_host;

proxy_set_header X-Nginx-Proxy true;

}

}3、ES Reindex 时如何不停止写入服务

方案一:kennywu76

ES 的 reindex 在索引有实时的 update/delete 的情况下,即使借助 alias,也没有办法实现真正的 zero down time。

增加新文档比较好办,通过 alias 切换写入到新索引,同时 reindex 做旧->新索引的数据传输即可;但是 update/delete 操作针对的文档如果还未从旧索引传输过来,直接对新索引操作会导致两个索引数据不一致。

我能够想到的(一个未经实际验证)的方案,前提是数据库里的文档有一个类似 last_update_time 字段记录文档最后更新的时间,用作写入 ES 文档的版本号,然后数据写入新索引的时候,url 里带上下面这样的参数:version_type=external_gt&version=xxxxxx。

其中 version_type=external_gt 表示写入文档的版本号大于已有的文档版本号,或者文档不存在,写入才会成功,否则会抛版本冲突的异常。另外 delete 操作都要转换成 index 操作,index 的内容可以是一个空文档。

这样实时数据写入新索引和 reindex 可以同时进行,实时写入的数据应该具有更高的版本,总是能够成功,reindex 如果遇到版本冲突,说明该文档被实时部分更新过了,已经过时,可以直接放弃跳过。

该方案的缺陷:

- 要求数据源里的数据具有版本信息,可能因为各种局限,不太容易更改;

- delete 操作必须转化为写入一个空文档,delete 实际上是一个标记文档,并且本身也有版本信息。但是如果后端发生了 segment merge,delete 可能会被合并以后物理清除。这样 delete 和对应的版本信息丢失,之后 reindex 如果写入了旧版本的文档,仍然会有一致性问题;但是空文档会增加索引文件的大小,有额外的消耗,一个可能的缓解办法是在 reindex 全部做完以后,再做一次空文档的删除。

改进方案:the_best

重建索引步骤如下:

- 保证 delete 操作都要转换成 index 操作,index 的内容可以是一个空文档;

- 对老索引

old_index(业务上的别名还是挂在老索引上)进行重索引操作(version_type=external);curl -X POST 'http://<hostname>:9200/_reindex' { "conflicts": "proceed", "source": { "index": "old_index", "size": 1000 }, "dest": { "index": "new_index", "version_type": "external" } } - 将别名切到 newIndex;

- 将重索引时间段内

old_index产生的热数据,再捞一次到new_index中(conflicts=proceed&version_type=external);curl -X POST /_reindex { "conflicts": "proceed", "source": { "index": "old_index" "query": { "constant_score" : { "filter" : { "range" : { "data_update_time" : { "gte" : <reindex开始时刻前的毫秒时间戳> } } } } } }, "dest": { "index": "new_index", "version_type": "external" } } - 手动做一次空文档的删除。

这种方式取决于重索引期间产生的数据量大小(会影响步骤4的用时),不过我们可以视具体业务情况灵活操作。比如说数据量比较大重索引我们用了10个小时(这10个小时内新产生了200多万的数据),在切别名前,我们可以按步骤(4)的调用方式,把近10个小时的数据再捞一遍到新索引中,如此迭代个几次,直到别名切完后,我们能保证最后一次的步骤(4)可以在较短时间内完成。

4、ES 节点通讯配置

http.port: 9200

http.bind_host: 127.0.0.1

transport.tcp.port: 9300

transport.bind_host: 127.0.0.15、把 Lucene 的原生 query 传给 ES

SearchRequest searchRequest = new SearchRequest(indexName);

searchRequest.types(typeName);

SearchSourceBuilder sourceBuilder = new SearchSourceBuilder();

sourceBuilder.from(0);

sourceBuilder.size(10);

sourceBuilder.timeout(new TimeValue(60, TimeUnit.SECONDS));

//q为Lucene检索表达式, 直接输入关键词匹配_all或者*字段, 字段匹配user:kimchy,

//多字段匹配user:kimchy AND message:Elasticsearch

QueryStringQueryBuilder queryStringQueryBuilder = QueryBuilders.queryStringQuery(q);

sourceBuilder.query(queryStringQueryBuilder);

searchRequest.source(sourceBuilder);

SearchResponse searchResponse = restHighLevelClient.search(searchRequest);

SearchHits searchHits = searchResponse.getHits();6、ES 文档字段个数限制

ES 文档默认不允许文档字段超过 1000,超过 1000 会报如下错误:

failed to put mappings on indices [[[nfvoemspm/srjL3cMMRUqa7DgOrYqX-A]]], type [log]

java.lang.IllegalArgumentException: Limit of total fields [1000] in index [xxx] has been exceeded可以通过修改索引配置来修改字段个数限制,不过还是推荐从业务上进行优化:

修改settings

{

"index.mapping.total_fields.limit": 2000

}7、将 DSL 字符串转换为 QueryBuilder

## wrapper 案例

GET /_search

{

"query" : {

"wrapper": {

"query" : "eyJ0ZXJtIiA6IHsgInVzZXIiIDogIktpbWNoeSIgfX0="

}

}

}

## RestClient

QueryBuilders.wrapperQuery("{\"term\": {\"field\":\"value\"}}")8、ES 集群重启后 Slice Scroll 速度变慢

重启机器之后,pagecache 都没有了,所有数据都要重新从磁盘加载。

9、ES 开启索引新建删除日志

PUT _cluster/settings

{

"persistent": {

"logger.cluster.service": "DEBUG"

}

}10、慢日志全局级别设定

- 对已经存在的索引可以通过 PUT _settings 做存量设置

- 对之后新增的索引,可以使用类似于下面的template

PUT _template/global-slowlog_template { "order": -1, "version": 0, "template": "*", "settings": { "index.indexing.slowlog.threshold.index.debug" : "10ms", "index.indexing.slowlog.threshold.index.info" : "50ms", "index.indexing.slowlog.threshold.index.warn" : "100ms", "index.search.slowlog.threshold.fetch.debug" : "100ms", "index.search.slowlog.threshold.fetch.info" : "200ms", "index.search.slowlog.threshold.fetch.warn" : "500ms", "index.search.slowlog.threshold.query.debug" : "100ms", "index.search.slowlog.threshold.query.info" : "200ms", "index.search.slowlog.threshold.query.warn" : "1s" } }

11、TCP 设置多个端口的用途

transport.tcp.port这个参数不写,默认为9300-9399,开放那么多 端口有用么?

- 如果设置一个端口,假设这个端口占用了程序就无法正常启动;

- 如果设置多个端口,一个端口占用会寻找下一个端口,直至找到可用端口。

12、ES 临时重启,设置分片延迟分配策略

PUT _all/_settings

{

"settings": {

"index.unassigned.node_left.delayed_timeout": "5m"

}

}三、Kibana

1、kibana 图表自定义标注

可以用 TSVB,支持标注。

Kibana TSVB 注解的使用:https://elasticsearch.cn/article/701

2、Kibana discover 导出 csv 文件

请参考文章:如何快速把 Kibana Discover 页的 Document Table 导出成 CSV

3、修改 kibana 的默认主页

四、社区文章精选

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

ELK 使用小技巧(第 4 期)

Elasticsearch • rochy 发表了文章 • 6 个评论 • 6391 次浏览 • 2019-01-07 20:43

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Logstash 性能调优主要参数

pipeline.workers:设置启动多少个线程执行 fliter 和 output;当 input 的内容出现堆积而 CPU 使用率还比较充足时,可以考虑增加该参数的大小;pipeline.batch.size:设置单个工作线程在执行过滤器和输出之前收集的最大事件数,较大的批量大小通常更高效,但会增加内存开销。输出插件会将每个批处理作为一个输出单元。;例如,ES 输出会为收到的每个批次发出批量请求;调整pipeline.batch.size可调整发送到 ES 的批量请求(Bulk)的大小;pipeline.batch.delay:设置 Logstash 管道的延迟时间, 管道批处理延迟是 Logstash 在当前管道工作线程中接收事件后等待新消息的最长时间(以毫秒为单位);简单来说,当pipeline.batch.size不满足时,会等待pipeline.batch.delay设置的时间,超时后便开始执行 filter 和 output 操作。

2、使用 Ruby Filter 根据现有字段计算一个新字段

filter {

ruby {

code => "event.set('kpi', ((event.get('a') + event.get('b'))/(event.get('c')+event.get('d'))).round(2))"

}

}3、logstash filter 如何判断字段是够为空或者 null

if ![updateTime]4、Date Filter 设置多种日期格式

date {

match => ["logtime", "yyyy-MM-dd HH:mm:ss.SSS","yyyy-MM-dd HH:mm:ss,SSS"]

target => "logtime_utc"

}二、Elasticsearch

1、高效翻页 Search After

通常情况下我们会使用 from 和 size 的方式实现查询结果的翻页,但是当达到深度分页时,成本变得过高(堆内存占用和时间耗费与 from+size 的大小成正比),因此 ES 设置了限制(index.max_result_window),默认值为 10000,防止用户进行过于深入的翻页。

推荐使用 Scroll api 进行高效深度滚动,但滚动上下文代价很高,因此不要将 Scroll 用于实时用户请求。search_after 参数通过提供实时游标来解决深度滚动的问题,其主要思路是使用上一页的结果来帮助检索下一页。

GET twitter/_search

{

"size": 10,

"query": {

"match" : {

"title" : "elasticsearch"

}

},

"search_after": [1463538857, "654323"],

"sort": [

{"date": "asc"},

{"tie_breaker_id": "asc"}

]

}2、ES 文档相似度 BM25 参数设置

ES2.X 默认是以 TF/IDF 算法计算文档相似度,从 ES5.X 开始,BM25 作为默认的相似度计算算法。

PUT /index

{

"settings" : {

"index" : {

"similarity" : {

"my_similarity" : {

"type" : "DFR",

"basic_model" : "g",

"after_effect" : "l",

"normalization" : "h2",

"normalization.h2.c" : "3.0"

}

}

}

}

}

PUT /index/_mapping/_doc

{

"properties" : {

"title" : { "type" : "text", "similarity" : "my_similarity" }

}

}3、ES2.X 得分计算

得分计算脚本:

double tf = Math.sqrt(doc.freq);

double idf = Math.log((field.docCount+1.0)/(term.docFreq+1.0)) + 1.0;

double norm = 1/Math.sqrt(doc.length);

return query.boost * tf * idf * norm;- 忽略词频统计及词频位置:将字段的

index_options设置为docs; - 忽略字段长度:设置字段的

"norms": { "enabled": false };

4、CircuitBreakingException: [parent] Data too large

报错信息:

[WARN ][r.suppressed ] path: /, params: {}

org.elasticsearch.common.breaker.CircuitBreakingException: [parent] Data too large, data for [<http_request>] would be [1454565650/1.3gb], which is larger than the limit of [1454427340/1.3gb], usages [request=0/0b, fielddata=568/568b, in_flight_requests=0/0b, accounting=1454565082/1.3gb]jvm 堆内存不够当前查询加载数据所以会报 data too large, 请求被熔断,indices.breaker.request.limit默认为 jvm heap 的 60%,因此可以通过调整 ES 的 Heap Size 来解决该问题。

5、ES 免费的自动化运维工具推荐

- Ansible: https://github.com/elastic/ansible-elasticsearch

- Puppet: https://github.com/elastic/puppet-elasticsearch

- Cookbook: https://github.com/elastic/cookbook-elasticsearch

- Curator:https://www.elastic.co/guide/en/elasticsearch/client/curator/current/about.html

6、elasticsearch-hanlp 分词插件包

核心功能:

- 内置多种分词模式,适合不同场景;

- 内置词典,无需额外配置即可使用;

- 支持外置词典,用户可自定义分词算法,基于词典或是模型;

- 支持分词器级别的自定义词典,便于用于多租户场景;

- 支持远程词典热更新(待开发);

- 拼音过滤器、繁简体过滤器(待开发);

- 基于词语或单字的 ngram 切分分词(待开发)。

7、节点重启时延迟索引分片重分配

当某个节点短时间离开集群时,一般是不会影响整体系统运行的,可以通过下面的请求延迟索引分片的再分配。

PUT _all/_settings

{

"settings": {

"index.unassigned.node_left.delayed_timeout": "5m"

}

}8、ES 数据修改后,查询还是未修改前的数据

默认是 1 秒可见,如果你的需求一定要写完就可见,那在写的时候增加 refresh 参数,强制刷新即可,但强烈建议不这么干,因为这样会把整个集群拖垮。

9、Terms Query 从另一个索引获取 terms

当 Terms Query 需要指定很多 terms 的时候,如果手动设置还是相当麻烦的,可以通过 terms-lookup 的方式从另外一个索引加载需要匹配的 terms。

PUT /users/_doc/2

{

"followers" : ["1", "3"]

}

PUT /tweets/_doc/1

{

"user" : "1"

}

GET /tweets/_search

{

"query" : {

"terms" : {

"user" : {

"index" : "users",

"type" : "_doc",

"id" : "2",

"path" : "followers"

}

}

}

}

-----------等效下面的语句--------------

PUT /users/_doc/2

{

"followers" : [

{

"id" : "1"

},

{

"id" : "2"

}

]

}10、ES 备份路径设置

报错信息:

doesn't match any of the locations specified by path.repo because this setting is empty结局方案,修改 ES 的配置文件:

# 在 elasticsearch.yml 中添加下面配置来设置备份仓库路径

path.repo: ["/home/test/backup/zty_logstash"]11、Query cache 和 Filter cache 的区别

Filter cache 被重命名为 Node Query Cache,也就是说 Query cache 等同于 Filter cache;Query Cache 采用了 LRU 的缓存方式(当缓存满的时候,淘汰旧的不用的缓存数据),Query Cache 只缓存被用于 filter 上下文的内容。

12、Shard 大小需要考虑的因素有哪些?

Lucene 底层没有这个大小的限制,20-40GB 的这个区间范围本身就比较大,经验值有时候就是拍脑袋,不一定都好使。

- Elasticsearch 对数据的隔离和迁移是以分片为单位进行的,分片太大,会加大迁移成本;

- 一个分片就是一个 Lucene 的库,一个 Lucene 目录里面包含很多 Segment,每个 Segment 有文档数的上限,Segment 内部的文档 ID 目前使用的是 Java 的整型,也就是 2 的 31 次方,所以能够表示的总的文档数为 Integer.MAX_VALUE - 128 = 2^31 - 128 = 2147483647 - 1 = 2,147,483,519,也就是21.4亿条;

- 同样,如果你不 force merge 成一个 Segment,单个 shard 的文档数能超过这个数;

- 单个 Lucene 越大,索引会越大,查询的操作成本自然要越高,IO 压力越大,自然会影响查询体验;

- 具体一个分片多少数据合适,还是需要结合实际的业务数据和实际的查询来进行测试以进行评估。

13、ES 索引更新时通过 mapping 限制指定字段更新

Elasticsearch 默认是 Dynamic Mapping,新字段会自动猜测数据类型,并自动 merge 到之前的 Mapping,你可以在 Mapping 里面可以配置字段是否支持动态加入,设置参数dynamic即可:true,默认,表示支持动态加入新字段;false,表示忽略该字段的后续索引等操作,但是索引还是成功的;strict支持不支持未知字段,直接抛错。

14、ES 数据快照到 HDFS

ES 做快照和使用 ES-Hadoop 导数据是完全的两种不同的方式,使用 ES-Hadoopp 后期导入的成本可能也不小。

- 如果要恢复快,当然是做快照和还原的方式最快,速度完全取决于网络和磁盘的速度;

- 如果为了节省磁盘,快照的时候,可以选 6.5 最新支持的

source_only模式,导出的快照要小很多,不过恢复的时候要进行重建,速度慢。

15、segment.memory 简介

segment 的大小,和 indexing buffer 有关,有三种方式会生成 segment:

- 一种是 indexing buffer 写满了会生成 segment 文件,默认是堆内存的10%,是节点共享的;

- 一种是 index buffer 有文档,但是还没满,但是 refresh 时间到了,这个时候就会把 buffer 里面的生成 segment 文件;

- 还有最后一种就是 es 自动的会将小的 segment 文件定期合并产生新的 segment 文件。

三、社区文章精选

- 2018 年 Elastic Advent Calendar 分享活动

- 使用 ES-Hadoop 将 Spark Streaming 流数据写入 ES

- Elastic Stack 6.5 最新功能

- 让Elasticsearch飞起来!——性能优化实践干货

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

Day 1 - ELK 使用小技巧(第 3 期)

Advent • rochy 发表了文章 • 1 个评论 • 6069 次浏览 • 2018-12-01 02:28

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Filebeat 设置多个 output

在 6.0 之前,Filebeat 可以设置多个输出(必须是不同类型的输出);从 6.0 开始已经禁止多输出了,只能拥有一个输出,如果想实现多输出,可以借助 logstash 等中间组件进行输出分发。

二、Elasticsearch

1、ES 用户占用的内存大于为 ES 设置的 heapsize

ES 是 Java 应用,底层存储引擎是基于 Lucene 的,heapsize 设置的是 Java 应用的内存;而 Lucene 建立倒排索引(Inverted Index)是先在内存里生成,然后定期以段文件(segment file)的形式刷到磁盘的,因此 Lucene 也会占用一部分内存。

2、ES 使用别名插入数据

ES 可以通过索引的方式向索引插入数据,但是同时只能有一个索引可以被写入,而且需要手动设置,未设置的情况下会报错:no write index is defined for alias [xxxx], The write index may be explicitly disabled using is_write_index=false or the alias points to multiple indices without one being designated as a write index。

POST /_aliases

{

"actions" : [

{

"add" : {

"index" : "test",

"alias" : "alias1",

"is_write_index" : true

}

}

]

}3、ES 设置 G1 垃圾回收

修改 jvm.options文件,将下面几行:

-XX:+UseConcMarkSweepGC

-XX:CMSInitiatingOccupancyFraction=75

-XX:+UseCMSInitiatingOccupancyOnly改为

-XX:+UseG1GC

-XX:MaxGCPauseMillis=50即可。

其中 -XX:MaxGCPauseMillis 是控制预期的最高 GC 时长,默认值为 200ms,如果线上业务特性对于 GC 停顿非常敏感,可以适当设置低一些。但是这个值如果设置过小,可能会带来比较高的 cpu 消耗。

4、ES 和 Zipkin 集成时设置验证信息

java -DKAFKA_ZOOKEEPER=10.14.123.117:2181

-DSTORAGE_TYPE=elasticsearch

-DES_HOSTS=http://10.14.125.5:9200

ES_USERNAME=xxx ES_PASSWORD=xxx

-jar zipkin.jar5、ES 集群部署报错

问题 1 报错信息如下:

Received message from unsupported version:[2.0.0] minimal compatible version is:[5.6.0]经排查是集群中存在低版本的 ES 实例,将低版本实例移除即可。

问题 2 报错信息如下:

with the same id but is a different node instance删除对应节点 elsticsearch 文件夹下的 data 文件夹下的节点数据即可。

6、海量中文分词插件

海量分词是天津海量信息技术股份有限公司自主研发的中文分词核心,经测试分词效果还是不错的,值得一试。

7、查询一个索引下的所有 type 名

通过下面的 API,即可获取全部的 type,下面的例子中 doc 就是 indexName 索引下的一个 type:

GET http://es127.0.0.1:9200/indexName/_mappings

-----------------------------------------------

{

indexName: - {

mappings: - {

doc: - {

_all: + {... },

dynamic_date_formats: + [... ],

dynamic_templates: + [... ],

properties: + {... }

}

}

}

}8、索引模板中根据字段值设置别名

设置索引模板的时候,别名可以使用 Query 条件来进行匹配。

PUT _template/template_1

{

"index_patterns" : ["te*"],

"settings" : {

"number_of_shards" : 1

},

"aliases" : {

"alias2" : {

"filter" : {

"term" : {"user" : "kimchy" }

},

"routing" : "kimchy"

},

"{index}-alias" : {}

}

}9、索引模板设置默认时间匹配格式

ES 默认是不会将 yyyy-MM-dd HH:mm:ss 识别为时间的,可以通过在索引模板进行如下设置实现多种时间格式的识别:

"mappings": {

"doc": {

"dynamic_date_formats": ["yyyy-MM-dd HH:mm:ss||strict_date_optional_time||epoch_millis"],10、ES 中 Merge 相关设置

Merge 是非常耗费 CPU 的操作;而且如果不是 SSD 的话,推荐将 index.merge.scheduler.max_thread_count 设置为 1;否则 ES 会启动 Math.min(3, Runtime.getRuntime().availableProcessors() / 2) 个线程进行 Merge 操作;这样大部分机械硬盘的磁盘 IO 都很难承受,就可能出现阻塞。

"index": {

"refresh_interval": "5s",

"number_of_shards": "3",

"max_result_window": 10000,

"translog": {

"flush_threshold_size": "500mb",

"sync_interval": "30s",

"durability": "async"

},

"merge": {

"scheduler": {

"max_merge_count": "100",

"max_thread_count": "1"

}

},11、mapping 中 enabled store index 参数

- enabled:默认是true,只用于 mapping 中的 object 字段类型;当设置为 false 时,其作用是使 es 不去解析该字段,并且该字段不能被查询和 store,只有在 source 中才能看到,设置 enabled 为 false,可以不设置字段类型,默认类型为 object;

- store:默认 false,store 参数的功能和 source 有一些相似,我们的数据默认都会在 source 中存在,但我们也可以将数据 store 起来;当我们使用

copy_to参数时,copy_to的目标字段并不会在 source 中存储,此时 store 就派上用场了; - index:默认是 true,当设置为 false,表明该字段不能被查询,如果查询会报错。

12、ES 图片搜索

- 可以借助局部敏感 LSH 或者 pHash 来实现:https://stackoverflow.com/questions/32785803

- Github 也有一个开源项目使用了多种 Hash 算法借助 ES 来实现图片搜索:https://github.com/usc-isi-i2/elasticsearch-image-features

13、Term 聚合根据子聚合结果排序

GET /_search

{

"aggs" : {

"genres" : {

"terms" : {

"field" : "genre",

"order" : { "playback_stats.max" : "desc" }

},

"aggs" : {

"playback_stats" : { "stats" : { "field" : "play_count" } }

}

}

}

}三、社区文章精选

ELK 使用小技巧(第 2 期)

Elasticsearch • rochy 发表了文章 • 1 个评论 • 8522 次浏览 • 2018-11-17 18:36

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Filebeat :Non-zero metrics in the last 30s

- 问题表现:Filebeat 无法向 Elasticsearch 发送日志数据;

- 错误信息:

INFO [monitoring] 1og/log.go:124 Non-zero metrics in the last 30s; - 社区反馈:在 input 和 output 下面添加属性 enabled:true。

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/*.log

output.elasticsearch:

hosts: ["https://localhost:9200"]

username: "filebeat_internal"

password: "YOUR_PASSWORD"

enabled: trueinput 和 output 下 enabled 属性默认值为 true,因此怀疑另有其因。

2、Logstash 按月生成索引

output {

if [type] == "typeA"{

elasticsearch {

hosts => "127.0.0.1:9200"

index => "log_%{+YYYY_MM}"

}

}

}按照日的原理类似:%{+YYYY.MM.dd}

3、Filebeat 通过配置删除特定字段

Filebeat 实现了类似 Logstash 中 filter 的功能,叫做处理器(processors),processors 种类不多,尽可能在保持 Filebeat 轻量化的基础上提供更多常用的功能。

下面列几种常用的 processors:

add_cloud_metadata:添加云服务器的 meta 信息;add_locale:添加本地时区;decode_json_fields:解析并处理包含 Json 字符串的字段;drop_event:丢弃符合条件的消息事件;drop_fields:删除符合条件的字段;include_fields:选择符合条件的字段;rename:字段重命名;add_kubernetes_metadata:添加 k8s 的 meta 信息;add_docker_metadata:添加容器的 meta 信息;add_host_metadata:添加操作系统的 meta 信息;dissect:类似与 gork 的正则匹配字段的功能;dns:配置 filebeat 独立的 dns 解析方式;add_process_metadata:添加进程的元信息。

processors 的使用方式:

- type: <input_type>

processors:

- <processor_name>:

when:

<condition>

<parameters>

...4、LogStash 采集 FTP 日志文件

exec {

codec => plain { }

command => "curl ftp://server/logs.log"

interval => 3000}

}5、Logstash docker-compose 启动失败(Permission denied)

在 docker-compose 中使用 user 选项设置使用 root 用户启动 docker,能解决权限问题。

$ cat docker-compose.yml

version: '2'

services:

logstash:

image: docker.elastic.co/logstash/logstash:6.4.2

user: root

command: id6、Metricize filter plugin

将一条消息拆分为多条消息。

# 原始信息

{

type => "type A"

metric1 => "value1"

metric2 => "value2"

}

# 配置信息

filter {

metricize {

metrics => [ "metric1", "metric2" ]

}

}

# 最终输出

{ {

type => "type A" type => "type A"

metric => "metric1" metric => "metric2"

value => "value1" value => "value2"

} }二、Elasticsearch

1、ES 倒排索引内部结构

Lucene 的倒排索引都是按照字段(field)来存储对应的文档信息的,如果 docName 和 docContent 中有“苹果”这个 term,就会有这两个索引链,如下所示:

docName:

"苹果" -> "doc1, doc2, doc3..."

docContent:

"苹果" -> "doc2, doc4, doc6..."2、Jest 和 RestHighLevelClient 哪个好用点

RestHighLevelClient 是官方组件,会一直得到官方的支持,且会与 ES 保持同步更新,推荐使用官方的高阶 API。

Jest 由于是社区维护,所以更新会有一定延迟,目前最新版对接 ES6.3.1,近一个月只有四个 issue,说明整体活跃度较低,因此不推荐使用。

此外推荐一份 TransportClient 的中文使用手册,翻译的很不错:https://github.com/jackiehff/elasticsearch-client-java-api-cn。

3、ES 单分片使用 From/Size 分页遇到重复数据

常规情况下 ES 单分片使用 From/Size 是不会遇到数据重复的,数据重复的可能原因有:

- 没有添加排序;

- 添加了按得分排序,但是查询语句全部为 filter 过滤条件(此时得分都一致);

- 添加了排序,但是有索引中文档的新增、修改、删除等操作。

对于多分片,推荐添加 preference 参数来实现分页结果的一致性。

4、The number of object passed must be even but was [1]

ES 在调用 setSource 的时候传入 Json 对象后会报错:The number of object passed must be even but was [1],此时可以推荐将 Json 对象转为 Map 集合,或者把 Json 对象转为 json 字符串,不过传入字符串的时候需要设置类型。

IndexRequest indexRequest = new IndexRequest("index", "type", "id");

JSONObject doc = new JSONObject();

//indexRequest.source(jsonObject); 错误的使用方法

//转为 Map 对象

indexRequest.source(JSONObject.parseObject((String) doc.get("json"), Map.class));

//转为 Json 字符串(声明字符串类型)

indexRequest.source(JSON.toJSONString(doc), XContentType.JSON);5、跨集群搜索

ES 6.X 原生支持跨集群搜索,具体配置请参考:https://www.elastic.co/guide/en/kibana/current/management-cross-cluster-search.html

PUT _cluster/settings

{

"persistent": {

"cluster": {

"remote": {

"cluster_one": {

"seeds": [

"127.0.0.1:9300"

]

},

"cluster_two": {

"seeds": [

"127.0.0.1:9301"

]

},

"cluster_three": {

"seeds": [

"127.0.0.1:9302"

]

}

}

}

}

}ES 6.5 推出了新功能,跨集群同步(Cross-cluster replication),感兴趣的可以自行了解。

6、ES 排序时设置空值排序位置

GET /_search

{

"sort" : [

{ "price" : {"missing" : "_last"} }

],

"query" : {

"term" : { "product" : "chocolate" }

}

}7、ES 冷归档数据如何处理

使用相对低配的大磁盘机器配置为 ES 的 Warm Nodes,可以通过 index.routing.allocation.require.box_type 来设置索引是冷数据或者热数据。如果索引极少使用,可以 close 索引,然后在需要搜索的时候 open 即可。

8、ES 相似文章检测

对于大文本的去重,可以参考 SimHash 算法,通过 SimHash 可以提取到文档指纹(64位),两篇文章通过 SimHash 计算海明距离即可判断是否重复。海明距离计算,可以通过插件实现:https://github.com/joway/elasticsearch-hamming-plugin

9、Terms 聚合查询优化

- 如果只需要聚合后前 N 条记录,推荐在 Terms 聚合时添加上

"collect_mode": "breadth_first"; - 此外可以通过设置

"min_doc_count": 10来限制最小匹配文档数; - 如果对返回的 Term 有所要求,可以通过设置

include和exclude来过滤 Term; - 如果想获取全部 Term 聚合结果,但是聚合结果又很多,可以考虑将聚合分成多个批次分别取回(Filtering Values with partitions)。

10、Tomcat 字符集造成的 ES 查询无结果

两个系统连接同一个 ES 服务,配置和代码完全一致,同一个搜索条件,一个能够搜索出来东西,一个什么都搜索不出来,排查结果是因为其中一个系统的 tomcat 配置有问题,导致请求的时候乱码了,所以搜不到数据。

11、ES 索引设置默认分词器

默认情况下,如果字段不指定分词器,ES 或使用 standard 分词器进行分词;可以通过下面的设置更改默认的分词器。

2.X 支持设置默认的索引分词器(default_index)和默认的查询分词器(default_search),6.X 已经不再支持。

PUT /index

{

"settings": {

"analysis": {

"analyzer": {

"default": {

"type": "ik_max_word",

"tokenizer": "ik_max_word"

}

}

}

}

}12、ES 中的魔法参数

- 索引名:_index

- 类型名:_type

- 文档Id:_id

- 得分:_score

- 索引排序:_doc

如果你对排序没有特别的需求,推荐使用 _doc 进行排序,例如执行 Scroll 操作时。

13、ES 延迟执行数据上卷(Rollup )

Rollup job 有个 delay 参数控制 job 执行的延迟时间,默认情况下不延迟执行,这样如果某个 interval 的数据已经聚合好了,该 interval 迟到的数据是不会处理的。

好在 rollup api 可以支持同时搜索裸索引和 rollup 过的索引,所以如果数据经常有延迟的话,可以考虑设置一个合适的 delay,比如 1h、6h 甚至 24h,这样 rollup 的索引产生会有延迟,但是能确保迟到的数据被处理。

从应用场景上看,rollup 一般是为了对历史数据做聚合存放,减少存储空间,所以延迟几个小时,甚至几天都是合理的。搜索的时候,同时搜索最近的裸索引和历史的 rollup 索引,就能将两者的数据组合起来,在给出正确的聚合结果的情况下,又兼顾了性能。

Rollup 是实验性功能,不过非常有用,特别是使用 ES 做数据仓库的场景。

14、ES6.x 获取所有的聚合结果

ES2.x 版本中,在聚合查询时,通过设置 setSize(0) 就可以获取所有的聚合结果,在ES6.x 中直接设置 setSize(Integer.MAX_VALUE) 等效于 2.x 中设置为 0。

15、ES Jar 包冲突问题

经常会遇到 ES 与业务集成时出现 Jar 包冲突问题,推荐的解决方法是使用 maven-shade-plugin 插件,该插件通过将冲突的 Jar 包更换一个命名空间的方式来解决 Jar 包的冲突问题,具体使用可以参考文章:https://www.jianshu.com/p/d9fb7afa634d。

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>2.4.1</version>

<configuration>

<createDependencyReducedPom>false</createDependencyReducedPom>

</configuration>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<relocations>

<relocation>

<pattern>com.google.guava</pattern>

<shadedPattern>net.luculent.elasticsearch.guava</shadedPattern>

</relocation>

<relocation>

<pattern>com.fasterxml.jackson</pattern>

<shadedPattern>net.luculent.elasticsearch.jackson</shadedPattern>

</relocation>

<relocation>

<pattern>org.joda</pattern>

<shadedPattern>net.luculent.elasticsearch.joda</shadedPattern>

</relocation>

<relocation>

<pattern>com.google.common</pattern>

<shadedPattern>net.luculent.elasticsearch.common</shadedPattern>

</relocation>

<relocation>

<pattern>com.google.thirdparty</pattern>

<shadedPattern>net.luculent.elasticsearch.thirdparty</shadedPattern>

</relocation>

</relocations>

<transformers>

<transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer" />

<transformer implementation="org.apache.maven.plugins.shade.resource.ServicesResourceTransformer"/>

</transformers>

</configuration>

</execution>

</executions>

</plugin>

</plugins>16、ES 如何选择 Shard 存储文档?

ES 采用 djb2 哈希算法对要索引文档的指定(或者默认随机生成的)_id 进行哈希,得到哈希结果后对索引 shard 数目 n 取模,公式如下:hash(_id) % n;根据取模结果决定存储到哪一个 shard 。

三、Kibana

1、在 Kiabana 的 Discovery 界面显示自定义字段

Kibana 的 Discovery 界面默认只显示 time 和 _source 两个字段,这个界面的左半部分,在 Popular 下面展示了很多,你只需要在你需要展示的字段后面点击 add 即可将自定义的字段添加到 discovery 界面。

2、filebeat 的 monitor 指标的说明

- Total:'All events newly created in the publishing pipeline'

- Emitted: 'Events processed by the output (including retries)'

- Acknowledged:'Events acknowledged by the output (includes events dropped by the output)'

- Queued:'Events added to the event pipeline queue'

四、社区文章精选

- Elastic认证考试心得

- 一文快速上手Logstash

- 当Elasticsearch遇见Kafka--Kafka Connect

- elasticsearch冷热数据读写分离

- elasticsearch优秀实践

- ELK 使用小技巧(第 1 期)

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

ELK 使用小技巧(第 1 期)

Elasticsearch • rochy 发表了文章 • 1 个评论 • 10531 次浏览 • 2018-10-27 19:16

ELK Tips 主要介绍一些 ELK 使用过程中的小技巧,内容主要来源为 Elastic 中文社区。

一、Logstash

1、Logstash 字符串分割(Split)

以下配置将 message 内容按照 \t 进行切分,为了使 \t 生效需要将 logstah.yml 中配置项 config.support_escapes 设置为 true,当设置为 true 时,带引号的字符串将处理转义字符,默认值为 false。

filter {

mutate {

split => {"message" => "\t"}

add_field => {

"ftimeold" => "%{[message][0]}"

}

}

}2、Logstash 按文件读取内容并存储到 ES

下面的配置将读取/home/txts/*下的文件,并读取整个文件内容,然后将文件内容存储到 test-text 索引中,同时该条记录的 _id 为文档的文件名。这里需要注意的是,想读取到文档末尾时,分隔符需设置为 EOF。

input {

file {

path => ["/home/txts/*"]

start_position => "beginning"

mode => "read"

delimiter => "EOF"

file_completed_action => "log"

file_completed_log_path => "/home/logs/file.log"

}

}

output {

elasticsearch {

hosts => ["http://192.168.3.214:9200/"]

index => "test-text"

document_id => "%{path}"

}

stdout {}

}3、ES Ingest Node 脚本案例

Ingest Node 可以使用多种过滤器对数据进行处理,其中 Script 脚本的功能非常强大,下面的案例实现了将一个 Json 结构进行了 Flat 化:

{

"script" : {

"lang" : "painless",

"source" : "def dict = ['result': new HashMap()]; for (entry in ctx['json'].entrySet()) { dict['result'][entry.getKey()] = entry.getValue(); } ctx['osquery'] = dict; ctx.remove('json');"

}

}4、Logstash input file 插件中 sincedb 维护问题

- 如果不想保存 sincedb,可以使用下面配置:

sincedb_path => "/dev/null"; - 如果希望被扫描的记录超过一段时间后自动被清除,可以使用

sincedb_clean_after => "2 weeks"来实现,sincedb_clean_after表示当一个文件在设定的时间内没有发生过任何变化,则关于这个文件的扫描记录将不会存储到 sincedb 里面,简单来说就是一条记录的过期时间。

二、Elasticsearch

1、ES 查询结果的一致性

为了保证用户每次查询结果的一致性(文档在结果中的顺序),可以在查询 url 里添加 preference=<some string> 这个参数,其中<some string>可以是用户的 session ID,这样某一个用户查询的时候,查询会被固定在某几个 shard。

2、同义词的扩展或收缩

- 简单扩展,把同义词列表中的任意一个词扩展成同义词列表所有的词:

jump,hop,leap; - 简单收缩,把左边的多个同义词映射到了右边的单个词:

leap,hop => jump; - 类型扩展,完全不同于简单收缩或扩张,并不是平等看待所有的同义词,而是扩大了词的意义使被拓展的词更为通用:

"cat => cat,pet", "kitten => kitten,cat,pet", "dog => dog,pet" "puppy => puppy,dog,pet"

3、设置某个索引为只读状态

index.blocks.write 设置为 true 来禁止对索引的写操作,但索引的 metadatra 可以正常写。

PUT indexName/_settings

{

"index.blocks.write": true

}4、Failed to process cluster event (put-mapping) within 30s

这个是创建 mapping 的时候超时了,默认是 30s 应该是集群处理不过来了。索引文件太多,使得集群的状态数据过多过大,在每个小时新建索引和设置索引 mapping 的时候,就产生集群状态更新任务交给 master 处理,master 在变更状态数据的时候是单线程处理的,如果集群总的状态数据很大,master处理这些任务就容易出现超时。

解决办法:

- 控制集群的总的索引数量,shard 数量;

- 如果同时创建的索引非常多,最好避免通过写入数据自动创建索引;

- 可以通过 cron 任务,预先顺序的创建好索引。

5、Get 查询获取不到数据,但是用 _search 就可以查询到

这种情况一般在索引时候加入了路由字段(routing),那么在 get,delete,update 操作中都必须使用路由字段。

PUT my_index/my_type/1?routing=user1&refresh=true

{

"title": "This is a document"

}

GET my_index/my_type/1?routing=user16、ES 5.X 版本多个 type 的数据迁移到 6.X

把 5.x 集群中的索引按不同 type 拆分 reindex 到 6.x 集群索引中,然后将拆分出来的多个索引使用别名进行组织;例如 5.x 集群中有索引 IndexA,该索引上有 typeA 和 typeB,reindex 到 6.x 集群IndexA_TypeA和IndexB_TypeB,reindex 语句如下所示:

POST _reindex

{

"source": {

"index": "IndexA",

"type": "TypeA",

"size": 10000

},

"dest": {

"index": "IndexA_TypeA"

}

}最后给 6.x 集群的IndexA_TypeA和IndexB_TypeB添加别名 IndexA,用户查询时使用的索引名称就不用变化。

POST _aliases

{

"actions": [

{"add": {"index": "IndexA_TypeA", "alias": "IndexA"}},

{"add": {"index": "IndexA_TypeB", "alias": "IndexA"}}

]

}7、reindex 将多个索引合并成一个索引,需要重新设置新索引的 mapping 吗?

需要在 reindex 之前为新索引重新设置 mapping ,reindex 只是通过类似 scroll 的方式把数据 bulk 到新的索引,不会自动同步原索引的 mappings 信息。

8、集群的 discovery.zen.ping.unicast.hosts 配置

只需要配置主节点(master)地址即可。

discovery.zen.ping.unicast.hosts:

- 192.168.1.10:9300

- 192.168.1.11

- seeds.mydomain.com 9、ES 的 path.data 配置多个盘的路径,查询效率与单个存储盘的效率比,哪个效率高些?

想最大程度发挥磁盘读写 io,还是推荐 RAID0。

使用多路径不一定会提升读写速度,和集群 shard 的数量有关系;主要是因为一个 shard 对应的文件,只会放到其中一块磁盘上,不会跨磁盘存储。比如一个极端的场景,集群 shard 数量比较少,每个结点上就一个shard,那么读写只会有一块磁盘发挥作用,其他磁盘都空闲的。

多路径对读写有提升比较大的场景,是每个结点上 shard 数量至少比盘的数量多,并且 shard 大小也差别不太多;shard 数量比较少,shard 大小差别太大,可能产生读写热点问题,即有的磁盘磁盘很忙,有的很闲。

ES 不会将一个索引的主副分片分配到同一台机器,所以即使一台机器的 RAID0 坏了,不会导致数据丢失,仅仅是副本没有了。

用 RAID0 的负面影响主要是磁盘损坏的时候,需要恢复的数据比较多;多路径磁盘,坏一块只会丢一部分数据,恢复数据会比较快;但是他也有缺陷,比如容易出现读写热点问题以及磁盘空间使用不均匀问题。

10、查询索引分片(Shard)位置的接口

# 推荐

GET /_cat/shards/<index_name>?v

GET /_cluster/state/routing_table11、multi_match 与 match_phrase 的区别

- multi_match 是对

boolQuery().should(matchQuery(field, keyword))的一种简化,简单说就是一个关键词,匹配多个字段,匹配方式为 matchQuery,正常的全文匹配。 - match_phrase 简单说就是要匹配一个短语,例如你输入的文本为:中国人,如果被分词为:中国/人,那么查找时候会在指定的字段先查找到 "中国" 这个 term,然后在 "中国" 这个 term 后面去查找 "人"这个term(有顺序要求),如果匹配到则认为匹配成功;所以更像是在匹配一个短语(连贯的句子)。

12、analyzer, tokenizer, token-filter 有什么区别

- analyzer :分析器,analyzer = 1 个 tokenizer + 若干个 token-filter;

- tokenizer :分词器,主要用于对文本进行切割;

- token-filter :过滤器,主要对 tokenizer 切割后的 term 进行再次处理。

13、_source 字段的用途

简单来说:_source 字段用于存储最原始的 JSON 文档内容(创建索引时传递的),这个字段不能被搜索,它可以在 get 或者 search 请求阶段进行返回;此外它会参与字段高亮计算、文档的更新等操作,一般不推荐关闭 _source 字段。

三、Kibana

1、kibana 表格默认排序

在设计表格的时候直接点击需要排序的那一列,然后让它按照倒序或者正序排序,然后点击保存即可,这样这个表格默认就是按照这一列倒序或者正序排列的。

Any Code,Code Any!

扫码关注『AnyCode』,编程路上,一起前行。

【分享】想用ELK做日志分析的TX们可以参考啦~~~

Elasticsearch • hw_cloudsearch 发表了文章 • 1 个评论 • 4450 次浏览 • 2018-05-21 11:24

上海Elasticsearch技术沙龙

活动 • zengcici 发表了文章 • 3 个评论 • 6010 次浏览 • 2018-03-13 14:21

活动介绍

本期邀请了阿里巴巴、Elastic、eBay、饿了么的技术专家,分享Elasticsearch及其相关组件在搜索、日志分析和监控领域的应用,帮助开发者更好的理解Elastisearch及其相关组件。

活动安排

时间:2018年3月24日周六 13:30-17:30

地点:上海浦东南路855号世界广场B2层路演中心会场

活动主题

- 13:30—14:00 签到

- 14:00—14:40 《Elasticsearch在智能运维领域的应用》 Elastic布道师 曾勇

- 14:40—15:20 《Performance Tuning Best Practice in Elasticsearch》 eBay技术专家 王佩

- 15:20—16:00 《基于Elasticsearch的离线搜索平台架构设计》 阿里巴巴技术专家 杨孔仕

- 16:00—16:40 《饿了么在ELasticsearch自动化运维平台和监控平台的应用实践》 饿了么资深搜索工程师 徐胜

- 16:40—17:30 自由交流

报名通道

活动报名通道:

https://yq.aliyun.com/event/208/join

使用钉钉扫描,加入Elasticsearch技术交流群:

嘉宾介绍

曾勇 Elastic布道师、Elasticsearch中国社区发起人

在分布式搜索、高性能、高可用架构、自动化运维等方面积累了超过七年的经验。曾勇是Elasticsearch国内首批用户,自2010年起就开始接触Elasticsearch并投入到生产环境中使用,并编写过一系列的中文处理相关的插件。

演讲主题:《Elasticsearch在智能运维领域的应用》 分享Elasticsearch和X-Pack组件在智能运维领域的技术原理和应用实践,如非监督型机器学习在自动的异常检测、高级关联和分类、根源问题诊断、早期故障预测等方面的应用等。

王佩 eBay技术专家

9年文档存储、索引、搜索领域软件行业从业经验,使用ElasticSearch约3年。现在eBay的ElasticSearch管理平台Pronto项目组工作,主要方向是ElasticSearch集群的部署和性能调优。

演讲主题:《Performance Tuning Best Practice in Elasticsearch》 eBay内部很多个项目组使用了Elasticsearch来提供数据查询和分析服务,其中绝大部分cluster都是建立在Pronto平台上,由Pronto项目组负责管理维护60+集群和监控调优工作。本次分享介绍了Pronto的ElasticSearch性能调优实践流程,调优过程中的注意事项和检查手段。

杨孔仕 阿里巴巴技术专家

2013年加入阿里巴巴, 先后在淘宝终搜和主搜做搜索平台化的工作。2017年加入美柚,负责美柚的搜索工程技术, 同年11月回到阿里巴巴搜索事业部负责Elasticsearch项目开发工作。

演讲主题:《基于Elasticsearch的离线搜索平台架构设计》 本次分享介绍了基于Elasticsearch的搜索离线平台的系统设计,结合阿里终搜和阿里主搜以及美柚的离线平台的设计,聊聊离线的数据流程。

徐胜 饿了么资深搜索工程师

在ELasticsearch运维配置、性能调优、分布式计算有丰富实践。目前是饿了么搜索推荐研发部的资深搜索工程师,负责饿了么十几条业务线的es集群的运维、查询和监控平台。

演讲主题:《饿了么在ELasticsearch自动化运维平台和监控平台的应用实践》 饿了么在10+个业务场景下,Elastisearch集群达到数百个node、千万级indices、TB级别数据量规模。嘉宾分享如何对大规模的线上集群进行运维配置、查询和监控应用。

【阿里云 Meetup】如何使用Elasticsearch进行智能运维

活动 • zengcici 发表了文章 • 9 个评论 • 5876 次浏览 • 2018-01-10 15:20

活动介绍

本期邀请了几位ES大咖做主题分享,并以Demo show和Workshop的形式介绍Elastisearch及其相关组件在搜索、日志分析和监控领域的应用,帮助用户更好的理解Elastisearch及其相关组件,在更多的搜索和分析场景中应用。Workshop环节请务必携带个人电脑参加。

活动安排

时间:2018年1月20日周六 13:30-17:00

地点:北京市海淀区中关村大街46号院-众海加速器(阿里巴巴创新中心)

活动主题

- 13:30—14:00 签到

- 14:00—14:30 主题分享《Elasticsearch在智能运维领域的应用》 Elastic布道师 曾勇

- 14:30—14:40 Q&A

- 14:40—15:10 Demo show《使用X-Pack和Kibana实现Elasticsearch 的监控与报警》 阿里云技术专家 李靖威

- 15:10—15:20 Q&A

- 15:20—15:50 Workshop《基于阿里云Elasticsearch构建网站日志处理系统》 阿里云产品专家 洪阳

- 15:50—16:00 Q&A

- 16:00—16:30 主题分享《ELK在运维工作中应用两三事》 上海安畅运维专家 韩军辉

- 16:30—17:00 现场快闪分享

- 17:00—17:30 现场专家一对一交流

报名通道

活动报名通道:

https://yq.aliyun.com/event/193/join

可提前报名现场快闪分享(5分钟/位),讲讲自己的ELK实践心得,报名链接:

https://survey.aliyun.com/survey/kMXx0zCfB

也可使用钉钉扫描,加入Elasticsearch技术交流群:

嘉宾介绍

曾勇 Elastic布道师

Elastic开发工程师与布道师,在分布式搜索、高性能、高可用架构、自动化运维等方面积累了超过七年的经验。曾勇是Elasticsearch国内首批用户,自2010年起就开始接触Elasticsearch并投入到生产环境中使用,并编写过一系列的中文处理相关的插件。

演讲主题:《Elasticsearch在智能运维领域的应用》

分享Elasticsearch和X-Pack组件在智能运维领域的技术原理和应用实践,如非监督型机器学习在自动的异常检测、高级关联和分类、根源问题诊断、早期故障预测等方面的应用等。

李靖威 阿里云技术专家

全栈程序员,精通前后端,在Web微服务系统架构上有深入研究。3年搜索产品相关经验,现负责阿里云Elasticsearch的产品业务部分的开发。

演讲主题:《使用X-Pack和Kibana实现Elasticsearch 的监控与报警》

以开源 Elasticsearch、阿里云 Elasticsearch和X-Pack的Demo show的形式, 对 Elasticsearch 集群监控和报警的内部原理进行讲解和使用方法演示。

洪阳 阿里云产品专家

阿里云搜索产品经理,从事多年大数据及搜索相关产品工作,在离线数据加工、离线调度系统、在线搜索等场景深入研究,对大数据和搜索相关产品有丰富的经验。

演讲主题:《基于阿里云Elasticsearch构建网站日志处理系统》

基于阿里云的Elasticsearch,离线数仓加工工具,数据同步工具等一些列产品来快速构建一个日志处理系统,从离线数据加工到在线数据搜索和分析展现诠释数据加工在阿里云产品上如何快速展开。

韩军辉 上海安畅运维专家

上海安畅网络运维主管,热衷于开源技术的学习和深入研究,从事多年的ELK运维相关工作,对ELK Stack有深入研究,对ELK相关运维有丰富的经验。

演讲主题:《ELK在运维工作中应用两三事》

基于ELK Stack、sflow技术、sflowtool工具、kafka消息队列等开源技术构建一套流量分析、DDOS告警系统。从流量收集、分析、存储、展现、告警一套流程来诠释ELK在流量分析中的应用。

ELK学习资料整理

经验分享 • lsyoung 发表了文章 • 0 个评论 • 16652 次浏览 • 2017-04-14 10:17

- ElasticSearch参考手册,学习 DSL查询语法,包括查找(query)、过滤(filter)和聚合(aggs)等。

- Logstash参考手册,学习数据导入,包括输入(input)、过滤(filter)和输出( output)等,主要是filter中如何对复杂文本 进行拆分和类型 转化。

- Kibana参考手册,使用Kibana提供的前端界面对数据进行快速展示,主要是对Visulize 模块的使

- ElasticSearch

- Logstash:Logstash 最佳实践,ELKStack中文指南

- Kibana:ELKStack中文指南